私的AI研究会 > SberSwap

個別の学習プロセス無しでFaceSwapを実現する「SberSwap」を検証する

FaceSwapは、個別に学習プロセスが必要なため処理に時間がかかる。「SberSwap」は、個別の学習プロセス無しでFaceSwapを実現する

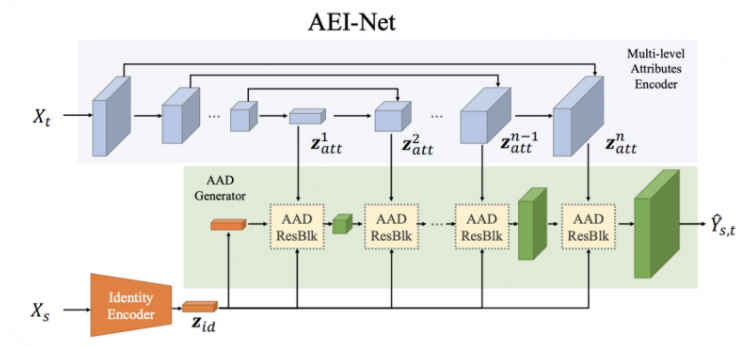

SberSwap モデル図

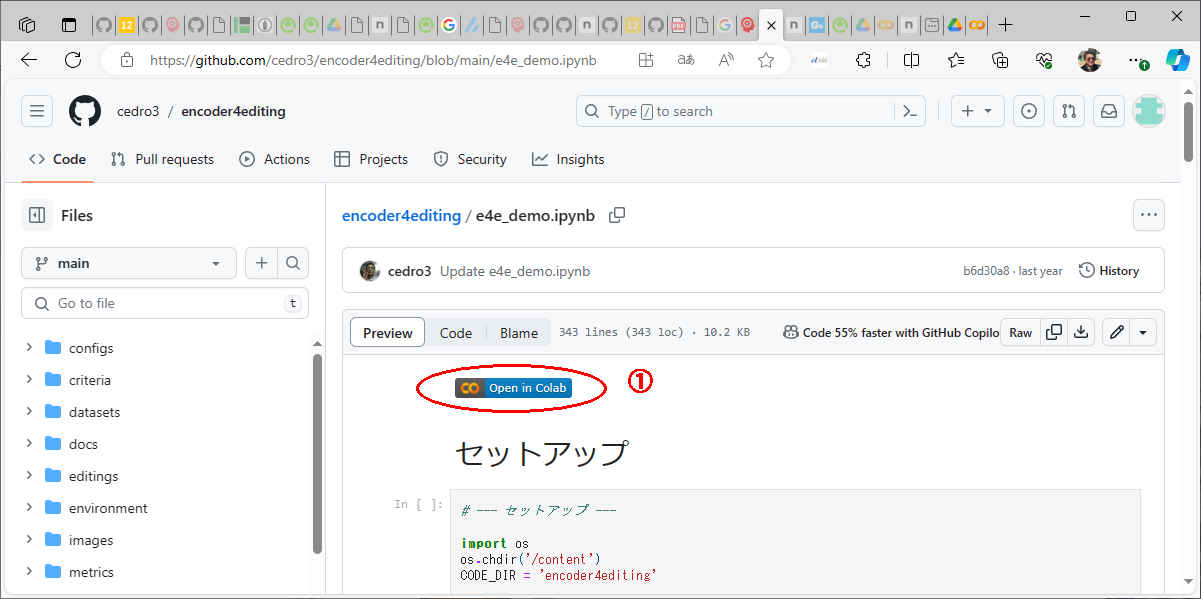

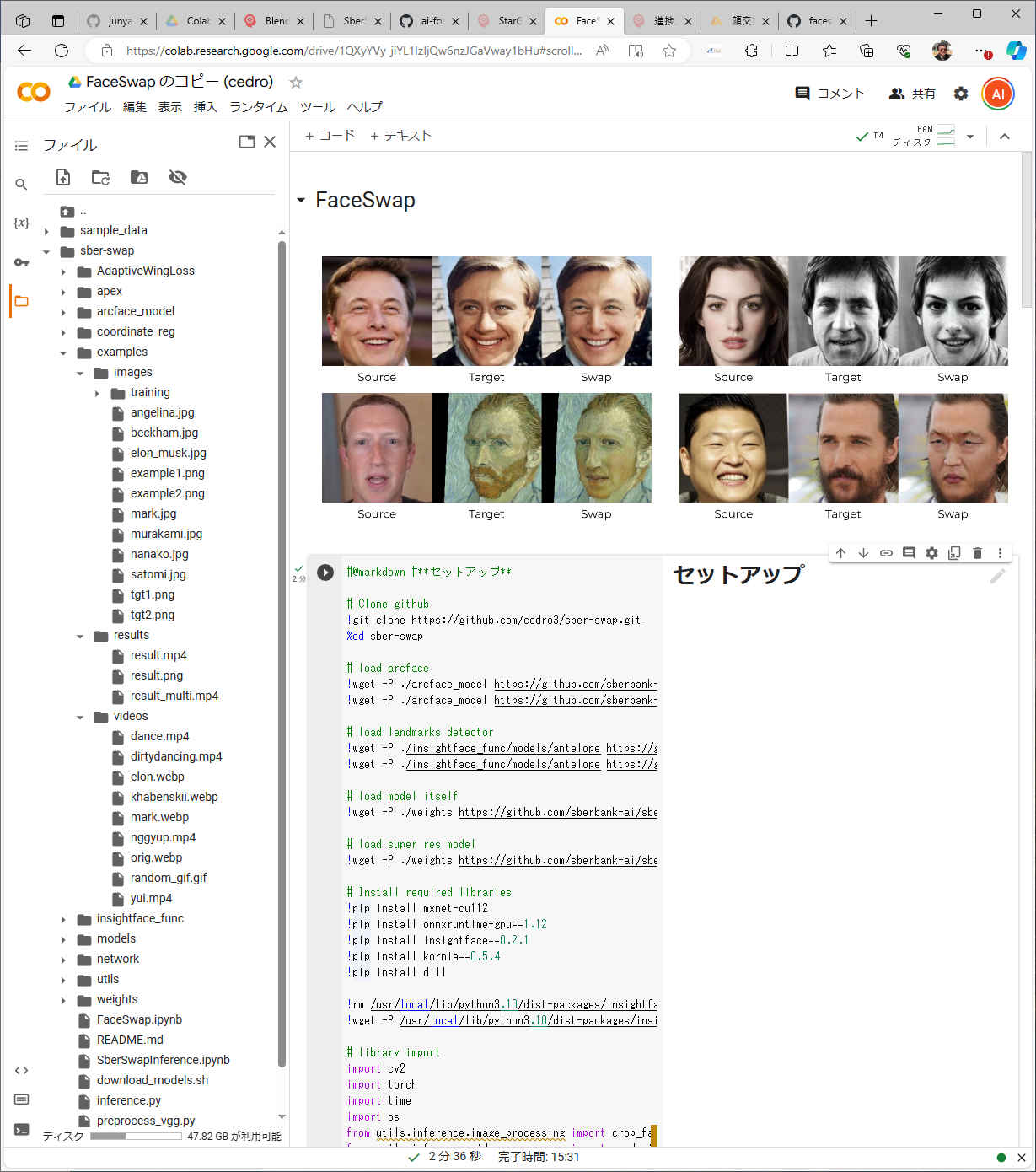

#@markdown #**セットアップ**

# Clone github

!git clone https://github.com/cedro3/sber-swap.git

%cd sber-swap

# load arcface

!wget -P ./arcface_model https://github.com/sberbank-ai/sber-swap/releases/download/arcface/backbone.pth

!wget -P ./arcface_model https://github.com/sberbank-ai/sber-swap/releases/download/arcface/iresnet.py

# load landmarks detector

!wget -P ./insightface_func/models/antelope https://github.com/sberbank-ai/sber-swap/releases/download/antelope/glintr100.onnx

!wget -P ./insightface_func/models/antelope https://github.com/sberbank-ai/sber-swap/releases/download/antelope/scrfd_10g_bnkps.onnx

# load model itself

!wget -P ./weights https://github.com/sberbank-ai/sber-swap/releases/download/sber-swap-v2.0/G_unet_2blocks.pth

# load super res model

!wget -P ./weights https://github.com/sberbank-ai/sber-swap/releases/download/super-res/10_net_G.pth

# Install required libraries

!pip install mxnet-cu112

!pip install onnxruntime-gpu==1.12

!pip install insightface==0.2.1

!pip install kornia==0.5.4

!pip install dill

!rm /usr/local/lib/python3.10/dist-packages/insightface/model_zoo/model_zoo.py #change the path to python in case you use a different version

!wget -P /usr/local/lib/python3.10/dist-packages/insightface/model_zoo/ https://github.com/AlexanderGroshev/insightface/releases/download/model_zoo/model_zoo.py #change the path to python in case you use a different version

# library import

import cv2

import torch

import time

import os

from utils.inference.image_processing import crop_face, get_final_image, show_images

from utils.inference.video_processing import read_video, get_target, get_final_video, add_audio_from_another_video, face_enhancement

from utils.inference.core import model_inference

from network.AEI_Net import AEI_Net

from coordinate_reg.image_infer import Handler

from insightface_func.face_detect_crop_multi import Face_detect_crop

from arcface_model.iresnet import iresnet100

from models.pix2pix_model import Pix2PixModel

from models.config_sr import TestOptions

# --- Initialize models ---

app = Face_detect_crop(name='antelope', root='./insightface_func/models')

app.prepare(ctx_id= 0, det_thresh=0.6, det_size=(640,640))

# main model for generation

G = AEI_Net(backbone='unet', num_blocks=2, c_id=512)

G.eval()

G.load_state_dict(torch.load('weights/G_unet_2blocks.pth', map_location=torch.device('cpu')))

G = G.cuda()

G = G.half()

# arcface model to get face embedding

netArc = iresnet100(fp16=False)

netArc.load_state_dict(torch.load('arcface_model/backbone.pth'))

netArc=netArc.cuda()

netArc.eval()

# model to get face landmarks

handler = Handler('./coordinate_reg/model/2d106det', 0, ctx_id=0, det_size=640)

# model to make superres of face, set use_sr=True if you want to use super resolution or use_sr=False if you don't

use_sr = True

if use_sr:

os.environ['CUDA_VISIBLE_DEVICES'] = '0'

torch.backends.cudnn.benchmark = True

opt = TestOptions()

#opt.which_epoch ='10_7'

model = Pix2PixModel(opt)

model.netG.train()

Connecting to objects.githubusercontent.com (objects.githubusercontent.com)|185.199.111.133|:443... connected.

HTTP request sent, awaiting response... 200 OK

Length: 261223796 (249M) [application/octet-stream]

Saving to: ‘./arcface_model/backbone.pth’

backbone.pth 100%[===================>] 249.12M 97.0MB/s in 2.6s

2023-12-06 06:29:29 (97.0 MB/s) - ‘./arcface_model/backbone.pth’ saved [261223796/261223796]

--2023-12-06 06:29:29-- https://github.com/sberbank-ai/sber-swap/releases/download/arcface/iresnet.py

Resolving github.com (github.com)... 20.27.177.113

Connecting to github.com (github.com)|20.27.177.113|:443... connected.

HTTP request sent, awaiting response... 301 Moved Permanently

Location: https://github.com/ai-forever/ghost/releases/download/arcface/iresnet.py [following]

--2023-12-06 06:29:30-- https://github.com/ai-forever/ghost/releases/download/arcface/iresnet.py

Reusing existing connection to github.com:443.

HTTP request sent, awaiting response... 302 Found

Location: https://objects.githubusercontent.com/github-production-release-asset-2e65be/437939371/898fa1d6-04a6-4dae-adde-961cde1d3444?X-Amz-Algorithm=AWS4-HMAC-SHA256&X-Amz-Credential=AKIAIWNJYAX4CSVEH53A%2F20231206%2Fus-east-1%2Fs3%2Faws4_request&X-Amz-Date=20231206T062930Z&X-Amz-Expires=300&X-Amz-Signature=35fc2e8bb6d11db33636dfe695ba685fdc0090f73f0a333e98d1ddd4ee60e4a2&X-Amz-SignedHeaders=host&actor_id=0&key_id=0&repo_id=437939371&response-content-disposition=attachment%3B%20filename%3Diresnet.py&response-content-type=application%2Foctet-stream [following]

--2023-12-06 06:29:30-- https://objects.githubusercontent.com/github-production-release-asset-2e65be/437939371/898fa1d6-04a6-4dae-adde-961cde1d3444?X-Amz-Algorithm=AWS4-HMAC-SHA256&X-Amz-Credential=AKIAIWNJYAX4CSVEH53A%2F20231206%2Fus-east-1%2Fs3%2Faws4_request&X-Amz-Date=20231206T062930Z&X-Amz-Expires=300&X-Amz-Signature=35fc2e8bb6d11db33636dfe695ba685fdc0090f73f0a333e98d1ddd4ee60e4a2&X-Amz-SignedHeaders=host&actor_id=0&key_id=0&repo_id=437939371&response-content-disposition=attachment%3B%20filename%3Diresnet.py&response-content-type=application%2Foctet-stream

Resolving objects.githubusercontent.com (objects.githubusercontent.com)... 185.199.108.133, 185.199.109.133, 185.199.110.133, ...

Connecting to objects.githubusercontent.com (objects.githubusercontent.com)|185.199.108.133|:443... connected.

HTTP request sent, awaiting response... 200 OK

Length: 7336 (7.2K) [application/octet-stream]

Saving to: ‘./arcface_model/iresnet.py’

iresnet.py 100%[===================>] 7.16K --.-KB/s in 0s

2023-12-06 06:29:30 (35.9 MB/s) - ‘./arcface_model/iresnet.py’ saved [7336/7336]

--2023-12-06 06:29:30-- https://github.com/sberbank-ai/sber-swap/releases/download/antelope/glintr100.onnx

Resolving github.com (github.com)... 20.27.177.113

Connecting to github.com (github.com)|20.27.177.113|:443... connected.

HTTP request sent, awaiting response... 301 Moved Permanently

Location: https://github.com/ai-forever/ghost/releases/download/antelope/glintr100.onnx [following]

--2023-12-06 06:29:31-- https://github.com/ai-forever/ghost/releases/download/antelope/glintr100.onnx

Reusing existing connection to github.com:443.

HTTP request sent, awaiting response... 302 Found

Location: https://objects.githubusercontent.com/github-production-release-asset-2e65be/437939371/6985d1de-2c27-4e9c-83cb-7e15f34656d7?X-Amz-Algorithm=AWS4-HMAC-SHA256&X-Amz-Credential=AKIAIWNJYAX4CSVEH53A%2F20231206%2Fus-east-1%2Fs3%2Faws4_request&X-Amz-Date=20231206T062931Z&X-Amz-Expires=300&X-Amz-Signature=9a1d93c694ed27833dffb49443d59ba85479d6b1c027e4b28e7b534be7b55d5e&X-Amz-SignedHeaders=host&actor_id=0&key_id=0&repo_id=437939371&response-content-disposition=attachment%3B%20filename%3Dglintr100.onnx&response-content-type=application%2Foctet-stream [following]

--2023-12-06 06:29:31-- https://objects.githubusercontent.com/github-production-release-asset-2e65be/437939371/6985d1de-2c27-4e9c-83cb-7e15f34656d7?X-Amz-Algorithm=AWS4-HMAC-SHA256&X-Amz-Credential=AKIAIWNJYAX4CSVEH53A%2F20231206%2Fus-east-1%2Fs3%2Faws4_request&X-Amz-Date=20231206T062931Z&X-Amz-Expires=300&X-Amz-Signature=9a1d93c694ed27833dffb49443d59ba85479d6b1c027e4b28e7b534be7b55d5e&X-Amz-SignedHeaders=host&actor_id=0&key_id=0&repo_id=437939371&response-content-disposition=attachment%3B%20filename%3Dglintr100.onnx&response-content-type=application%2Foctet-stream

Resolving objects.githubusercontent.com (objects.githubusercontent.com)... 185.199.109.133, 185.199.108.133, 185.199.110.133, ...

Connecting to objects.githubusercontent.com (objects.githubusercontent.com)|185.199.109.133|:443... connected.

HTTP request sent, awaiting response... 200 OK

Length: 260665334 (249M) [application/octet-stream]

Saving to: ‘./insightface_func/models/antelope/glintr100.onnx’

glintr100.onnx 100%[===================>] 248.59M 82.4MB/s in 3.0s

2023-12-06 06:29:35 (82.4 MB/s) - ‘./insightface_func/models/antelope/glintr100.onnx’ saved [260665334/260665334]

--2023-12-06 06:29:35-- https://github.com/sberbank-ai/sber-swap/releases/download/antelope/scrfd_10g_bnkps.onnx

Resolving github.com (github.com)... 20.27.177.113

Connecting to github.com (github.com)|20.27.177.113|:443... connected.

HTTP request sent, awaiting response... 301 Moved Permanently

Location: https://github.com/ai-forever/ghost/releases/download/antelope/scrfd_10g_bnkps.onnx [following]

--2023-12-06 06:29:35-- https://github.com/ai-forever/ghost/releases/download/antelope/scrfd_10g_bnkps.onnx

Reusing existing connection to github.com:443.

HTTP request sent, awaiting response... 302 Found

Location: https://objects.githubusercontent.com/github-production-release-asset-2e65be/437939371/ec2a811e-2753-48b0-9c6d-11f22df85358?X-Amz-Algorithm=AWS4-HMAC-SHA256&X-Amz-Credential=AKIAIWNJYAX4CSVEH53A%2F20231206%2Fus-east-1%2Fs3%2Faws4_request&X-Amz-Date=20231206T062935Z&X-Amz-Expires=300&X-Amz-Signature=25813617aa4cf165e2d6bbc676f4182c51bfaa0d17c3169500c73ce23329de31&X-Amz-SignedHeaders=host&actor_id=0&key_id=0&repo_id=437939371&response-content-disposition=attachment%3B%20filename%3Dscrfd_10g_bnkps.onnx&response-content-type=application%2Foctet-stream [following]

--2023-12-06 06:29:35-- https://objects.githubusercontent.com/github-production-release-asset-2e65be/437939371/ec2a811e-2753-48b0-9c6d-11f22df85358?X-Amz-Algorithm=AWS4-HMAC-SHA256&X-Amz-Credential=AKIAIWNJYAX4CSVEH53A%2F20231206%2Fus-east-1%2Fs3%2Faws4_request&X-Amz-Date=20231206T062935Z&X-Amz-Expires=300&X-Amz-Signature=25813617aa4cf165e2d6bbc676f4182c51bfaa0d17c3169500c73ce23329de31&X-Amz-SignedHeaders=host&actor_id=0&key_id=0&repo_id=437939371&response-content-disposition=attachment%3B%20filename%3Dscrfd_10g_bnkps.onnx&response-content-type=application%2Foctet-stream

Resolving objects.githubusercontent.com (objects.githubusercontent.com)... 185.199.108.133, 185.199.109.133, 185.199.110.133, ...

Connecting to objects.githubusercontent.com (objects.githubusercontent.com)|185.199.108.133|:443... connected.

HTTP request sent, awaiting response... 200 OK

Length: 16923827 (16M) [application/octet-stream]

Saving to: ‘./insightface_func/models/antelope/scrfd_10g_bnkps.onnx’

scrfd_10g_bnkps.onn 100%[===================>] 16.14M 43.4MB/s in 0.4s

2023-12-06 06:29:36 (43.4 MB/s) - ‘./insightface_func/models/antelope/scrfd_10g_bnkps.onnx’ saved [16923827/16923827]

--2023-12-06 06:29:36-- https://github.com/sberbank-ai/sber-swap/releases/download/sber-swap-v2.0/G_unet_2blocks.pth

Resolving github.com (github.com)... 20.27.177.113

Connecting to github.com (github.com)|20.27.177.113|:443... connected.

HTTP request sent, awaiting response... 301 Moved Permanently

Location: https://github.com/ai-forever/ghost/releases/download/sber-swap-v2.0/G_unet_2blocks.pth [following]

--2023-12-06 06:29:37-- https://github.com/ai-forever/ghost/releases/download/sber-swap-v2.0/G_unet_2blocks.pth

Reusing existing connection to github.com:443.

HTTP request sent, awaiting response... 302 Found

Location: https://objects.githubusercontent.com/github-production-release-asset-2e65be/437939371/e6fb7fb2-bc89-4168-a9d9-74d1502bed31?X-Amz-Algorithm=AWS4-HMAC-SHA256&X-Amz-Credential=AKIAIWNJYAX4CSVEH53A%2F20231206%2Fus-east-1%2Fs3%2Faws4_request&X-Amz-Date=20231206T062937Z&X-Amz-Expires=300&X-Amz-Signature=60b973f2894e97155299877328b2062113b19169acaa3226bb947aa4ee911690&X-Amz-SignedHeaders=host&actor_id=0&key_id=0&repo_id=437939371&response-content-disposition=attachment%3B%20filename%3DG_unet_2blocks.pth&response-content-type=application%2Foctet-stream [following]

--2023-12-06 06:29:37-- https://objects.githubusercontent.com/github-production-release-asset-2e65be/437939371/e6fb7fb2-bc89-4168-a9d9-74d1502bed31?X-Amz-Algorithm=AWS4-HMAC-SHA256&X-Amz-Credential=AKIAIWNJYAX4CSVEH53A%2F20231206%2Fus-east-1%2Fs3%2Faws4_request&X-Amz-Date=20231206T062937Z&X-Amz-Expires=300&X-Amz-Signature=60b973f2894e97155299877328b2062113b19169acaa3226bb947aa4ee911690&X-Amz-SignedHeaders=host&actor_id=0&key_id=0&repo_id=437939371&response-content-disposition=attachment%3B%20filename%3DG_unet_2blocks.pth&response-content-type=application%2Foctet-stream

Resolving objects.githubusercontent.com (objects.githubusercontent.com)... 185.199.108.133, 185.199.109.133, 185.199.110.133, ...

Connecting to objects.githubusercontent.com (objects.githubusercontent.com)|185.199.108.133|:443... connected.

HTTP request sent, awaiting response... 200 OK

Length: 737523486 (703M) [application/octet-stream]

Saving to: ‘./weights/G_unet_2blocks.pth’

G_unet_2blocks.pth 100%[===================>] 703.36M 60.5MB/s in 7.9s

2023-12-06 06:29:45 (88.6 MB/s) - ‘./weights/G_unet_2blocks.pth’ saved [737523486/737523486]

--2023-12-06 06:29:45-- https://github.com/sberbank-ai/sber-swap/releases/download/super-res/10_net_G.pth

Resolving github.com (github.com)... 20.27.177.113

Connecting to github.com (github.com)|20.27.177.113|:443... connected.

HTTP request sent, awaiting response... 301 Moved Permanently

Location: https://github.com/ai-forever/ghost/releases/download/super-res/10_net_G.pth [following]

--2023-12-06 06:29:46-- https://github.com/ai-forever/ghost/releases/download/super-res/10_net_G.pth

Reusing existing connection to github.com:443.

HTTP request sent, awaiting response... 302 Found

Location: https://objects.githubusercontent.com/github-production-release-asset-2e65be/437939371/47108a99-17fe-4ea6-a65a-61a386f092bb?X-Amz-Algorithm=AWS4-HMAC-SHA256&X-Amz-Credential=AKIAIWNJYAX4CSVEH53A%2F20231206%2Fus-east-1%2Fs3%2Faws4_request&X-Amz-Date=20231206T062946Z&X-Amz-Expires=300&X-Amz-Signature=625a63e4555f31f72894409d6c525fa520b82cc851b78986fc26d75f4e084944&X-Amz-SignedHeaders=host&actor_id=0&key_id=0&repo_id=437939371&response-content-disposition=attachment%3B%20filename%3D10_net_G.pth&response-content-type=application%2Foctet-stream [following]

--2023-12-06 06:29:46-- https://objects.githubusercontent.com/github-production-release-asset-2e65be/437939371/47108a99-17fe-4ea6-a65a-61a386f092bb?X-Amz-Algorithm=AWS4-HMAC-SHA256&X-Amz-Credential=AKIAIWNJYAX4CSVEH53A%2F20231206%2Fus-east-1%2Fs3%2Faws4_request&X-Amz-Date=20231206T062946Z&X-Amz-Expires=300&X-Amz-Signature=625a63e4555f31f72894409d6c525fa520b82cc851b78986fc26d75f4e084944&X-Amz-SignedHeaders=host&actor_id=0&key_id=0&repo_id=437939371&response-content-disposition=attachment%3B%20filename%3D10_net_G.pth&response-content-type=application%2Foctet-stream

Resolving objects.githubusercontent.com (objects.githubusercontent.com)... 185.199.108.133, 185.199.109.133, 185.199.110.133, ...

Connecting to objects.githubusercontent.com (objects.githubusercontent.com)|185.199.108.133|:443... connected.

HTTP request sent, awaiting response... 200 OK

Length: 289322632 (276M) [application/octet-stream]

Saving to: ‘./weights/10_net_G.pth’

10_net_G.pth 100%[===================>] 275.92M 98.6MB/s in 2.8s

2023-12-06 06:29:49 (98.6 MB/s) - ‘./weights/10_net_G.pth’ saved [289322632/289322632]

Collecting mxnet-cu112

Downloading mxnet_cu112-1.9.1-py3-none-manylinux2014_x86_64.whl (499.4 MB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 499.4/499.4 MB 2.5 MB/s eta 0:00:00

Requirement already satisfied: numpy<2.0.0,>1.16.0 in /usr/local/lib/python3.10/dist-packages (from mxnet-cu112) (1.23.5)

Requirement already satisfied: requests<3,>=2.20.0 in /usr/local/lib/python3.10/dist-packages (from mxnet-cu112) (2.31.0)

Collecting graphviz<0.9.0,>=0.8.1 (from mxnet-cu112)

Downloading graphviz-0.8.4-py2.py3-none-any.whl (16 kB)

Requirement already satisfied: charset-normalizer<4,>=2 in /usr/local/lib/python3.10/dist-packages (from requests<3,>=2.20.0->mxnet-cu112) (3.3.2)

Requirement already satisfied: idna<4,>=2.5 in /usr/local/lib/python3.10/dist-packages (from requests<3,>=2.20.0->mxnet-cu112) (3.6)

Requirement already satisfied: urllib3<3,>=1.21.1 in /usr/local/lib/python3.10/dist-packages (from requests<3,>=2.20.0->mxnet-cu112) (2.0.7)

Requirement already satisfied: certifi>=2017.4.17 in /usr/local/lib/python3.10/dist-packages (from requests<3,>=2.20.0->mxnet-cu112) (2023.11.17)

Installing collected packages: graphviz, mxnet-cu112

Attempting uninstall: graphviz

Found existing installation: graphviz 0.20.1

Uninstalling graphviz-0.20.1:

Successfully uninstalled graphviz-0.20.1

Successfully installed graphviz-0.8.4 mxnet-cu112-1.9.1

Collecting onnxruntime-gpu==1.12

Downloading onnxruntime_gpu-1.12.0-cp310-cp310-manylinux_2_17_x86_64.manylinux2014_x86_64.whl (111.0 MB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 111.0/111.0 MB 6.5 MB/s eta 0:00:00

Collecting coloredlogs (from onnxruntime-gpu==1.12)

Downloading coloredlogs-15.0.1-py2.py3-none-any.whl (46 kB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 46.0/46.0 kB 6.8 MB/s eta 0:00:00

Requirement already satisfied: flatbuffers in /usr/local/lib/python3.10/dist-packages (from onnxruntime-gpu==1.12) (23.5.26)

Requirement already satisfied: numpy>=1.21.0 in /usr/local/lib/python3.10/dist-packages (from onnxruntime-gpu==1.12) (1.23.5)

Requirement already satisfied: packaging in /usr/local/lib/python3.10/dist-packages (from onnxruntime-gpu==1.12) (23.2)

Requirement already satisfied: protobuf in /usr/local/lib/python3.10/dist-packages (from onnxruntime-gpu==1.12) (3.20.3)

Requirement already satisfied: sympy in /usr/local/lib/python3.10/dist-packages (from onnxruntime-gpu==1.12) (1.12)

Collecting humanfriendly>=9.1 (from coloredlogs->onnxruntime-gpu==1.12)

Downloading humanfriendly-10.0-py2.py3-none-any.whl (86 kB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 86.8/86.8 kB 11.8 MB/s eta 0:00:00

Requirement already satisfied: mpmath>=0.19 in /usr/local/lib/python3.10/dist-packages (from sympy->onnxruntime-gpu==1.12) (1.3.0)

Installing collected packages: humanfriendly, coloredlogs, onnxruntime-gpu

Successfully installed coloredlogs-15.0.1 humanfriendly-10.0 onnxruntime-gpu-1.12.0

Collecting insightface==0.2.1

Downloading insightface-0.2.1-py2.py3-none-any.whl (24 kB)

Requirement already satisfied: numpy in /usr/local/lib/python3.10/dist-packages (from insightface==0.2.1) (1.23.5)

Collecting onnx (from insightface==0.2.1)

Downloading onnx-1.15.0-cp310-cp310-manylinux_2_17_x86_64.manylinux2014_x86_64.whl (15.7 MB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 15.7/15.7 MB 13.0 MB/s eta 0:00:00

Requirement already satisfied: tqdm in /usr/local/lib/python3.10/dist-packages (from insightface==0.2.1) (4.66.1)

Requirement already satisfied: requests in /usr/local/lib/python3.10/dist-packages (from insightface==0.2.1) (2.31.0)

Requirement already satisfied: matplotlib in /usr/local/lib/python3.10/dist-packages (from insightface==0.2.1) (3.7.1)

Requirement already satisfied: Pillow in /usr/local/lib/python3.10/dist-packages (from insightface==0.2.1) (9.4.0)

Requirement already satisfied: scipy in /usr/local/lib/python3.10/dist-packages (from insightface==0.2.1) (1.11.4)

Requirement already satisfied: opencv-python in /usr/local/lib/python3.10/dist-packages (from insightface==0.2.1) (4.8.0.76)

Requirement already satisfied: scikit-learn in /usr/local/lib/python3.10/dist-packages (from insightface==0.2.1) (1.2.2)

Requirement already satisfied: scikit-image in /usr/local/lib/python3.10/dist-packages (from insightface==0.2.1) (0.19.3)

Requirement already satisfied: easydict in /usr/local/lib/python3.10/dist-packages (from insightface==0.2.1) (1.11)

Requirement already satisfied: contourpy>=1.0.1 in /usr/local/lib/python3.10/dist-packages (from matplotlib->insightface==0.2.1) (1.2.0)

Requirement already satisfied: cycler>=0.10 in /usr/local/lib/python3.10/dist-packages (from matplotlib->insightface==0.2.1) (0.12.1)

Requirement already satisfied: fonttools>=4.22.0 in /usr/local/lib/python3.10/dist-packages (from matplotlib->insightface==0.2.1) (4.45.1)

Requirement already satisfied: kiwisolver>=1.0.1 in /usr/local/lib/python3.10/dist-packages (from matplotlib->insightface==0.2.1) (1.4.5)

Requirement already satisfied: packaging>=20.0 in /usr/local/lib/python3.10/dist-packages (from matplotlib->insightface==0.2.1) (23.2)

Requirement already satisfied: pyparsing>=2.3.1 in /usr/local/lib/python3.10/dist-packages (from matplotlib->insightface==0.2.1) (3.1.1)

Requirement already satisfied: python-dateutil>=2.7 in /usr/local/lib/python3.10/dist-packages (from matplotlib->insightface==0.2.1) (2.8.2)

Requirement already satisfied: protobuf>=3.20.2 in /usr/local/lib/python3.10/dist-packages (from onnx->insightface==0.2.1) (3.20.3)

Requirement already satisfied: charset-normalizer<4,>=2 in /usr/local/lib/python3.10/dist-packages (from requests->insightface==0.2.1) (3.3.2)

Requirement already satisfied: idna<4,>=2.5 in /usr/local/lib/python3.10/dist-packages (from requests->insightface==0.2.1) (3.6)

Requirement already satisfied: urllib3<3,>=1.21.1 in /usr/local/lib/python3.10/dist-packages (from requests->insightface==0.2.1) (2.0.7)

Requirement already satisfied: certifi>=2017.4.17 in /usr/local/lib/python3.10/dist-packages (from requests->insightface==0.2.1) (2023.11.17)

Requirement already satisfied: networkx>=2.2 in /usr/local/lib/python3.10/dist-packages (from scikit-image->insightface==0.2.1) (3.2.1)

Requirement already satisfied: imageio>=2.4.1 in /usr/local/lib/python3.10/dist-packages (from scikit-image->insightface==0.2.1) (2.31.6)

Requirement already satisfied: tifffile>=2019.7.26 in /usr/local/lib/python3.10/dist-packages (from scikit-image->insightface==0.2.1) (2023.9.26)

Requirement already satisfied: PyWavelets>=1.1.1 in /usr/local/lib/python3.10/dist-packages (from scikit-image->insightface==0.2.1) (1.5.0)

Requirement already satisfied: joblib>=1.1.1 in /usr/local/lib/python3.10/dist-packages (from scikit-learn->insightface==0.2.1) (1.3.2)

Requirement already satisfied: threadpoolctl>=2.0.0 in /usr/local/lib/python3.10/dist-packages (from scikit-learn->insightface==0.2.1) (3.2.0)

Requirement already satisfied: six>=1.5 in /usr/local/lib/python3.10/dist-packages (from python-dateutil>=2.7->matplotlib->insightface==0.2.1) (1.16.0)

Installing collected packages: onnx, insightface

Successfully installed insightface-0.2.1 onnx-1.15.0

Collecting kornia==0.5.4

Downloading kornia-0.5.4-py2.py3-none-any.whl (285 kB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 285.7/285.7 kB 5.0 MB/s eta 0:00:00

Requirement already satisfied: numpy in /usr/local/lib/python3.10/dist-packages (from kornia==0.5.4) (1.23.5)

Requirement already satisfied: torch>=1.6.0 in /usr/local/lib/python3.10/dist-packages (from kornia==0.5.4) (2.1.0+cu118)

Requirement already satisfied: filelock in /usr/local/lib/python3.10/dist-packages (from torch>=1.6.0->kornia==0.5.4) (3.13.1)

Requirement already satisfied: typing-extensions in /usr/local/lib/python3.10/dist-packages (from torch>=1.6.0->kornia==0.5.4) (4.5.0)

Requirement already satisfied: sympy in /usr/local/lib/python3.10/dist-packages (from torch>=1.6.0->kornia==0.5.4) (1.12)

Requirement already satisfied: networkx in /usr/local/lib/python3.10/dist-packages (from torch>=1.6.0->kornia==0.5.4) (3.2.1)

Requirement already satisfied: jinja2 in /usr/local/lib/python3.10/dist-packages (from torch>=1.6.0->kornia==0.5.4) (3.1.2)

Requirement already satisfied: fsspec in /usr/local/lib/python3.10/dist-packages (from torch>=1.6.0->kornia==0.5.4) (2023.6.0)

Requirement already satisfied: triton==2.1.0 in /usr/local/lib/python3.10/dist-packages (from torch>=1.6.0->kornia==0.5.4) (2.1.0)

Requirement already satisfied: MarkupSafe>=2.0 in /usr/local/lib/python3.10/dist-packages (from jinja2->torch>=1.6.0->kornia==0.5.4) (2.1.3)

Requirement already satisfied: mpmath>=0.19 in /usr/local/lib/python3.10/dist-packages (from sympy->torch>=1.6.0->kornia==0.5.4) (1.3.0)

Installing collected packages: kornia

Successfully installed kornia-0.5.4

Collecting dill

Downloading dill-0.3.7-py3-none-any.whl (115 kB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 115.3/115.3 kB 2.8 MB/s eta 0:00:00

Installing collected packages: dill

Successfully installed dill-0.3.7

--2023-12-06 06:31:18-- https://github.com/AlexanderGroshev/insightface/releases/download/model_zoo/model_zoo.py

Resolving github.com (github.com)... 20.27.177.113

Connecting to github.com (github.com)|20.27.177.113|:443... connected.

HTTP request sent, awaiting response... 302 Found

Location: https://objects.githubusercontent.com/github-production-release-asset-2e65be/636389020/f2efe3c3-f0a4-45e3-a7a2-084f61aeee64?X-Amz-Algorithm=AWS4-HMAC-SHA256&X-Amz-Credential=AKIAIWNJYAX4CSVEH53A%2F20231206%2Fus-east-1%2Fs3%2Faws4_request&X-Amz-Date=20231206T063119Z&X-Amz-Expires=300&X-Amz-Signature=5cfea055db33a2d3e75e5a104afe5494e2000b1797fffcf7270ad8f86b600f89&X-Amz-SignedHeaders=host&actor_id=0&key_id=0&repo_id=636389020&response-content-disposition=attachment%3B%20filename%3Dmodel_zoo.py&response-content-type=application%2Foctet-stream [following]

--2023-12-06 06:31:19-- https://objects.githubusercontent.com/github-production-release-asset-2e65be/636389020/f2efe3c3-f0a4-45e3-a7a2-084f61aeee64?X-Amz-Algorithm=AWS4-HMAC-SHA256&X-Amz-Credential=AKIAIWNJYAX4CSVEH53A%2F20231206%2Fus-east-1%2Fs3%2Faws4_request&X-Amz-Date=20231206T063119Z&X-Amz-Expires=300&X-Amz-Signature=5cfea055db33a2d3e75e5a104afe5494e2000b1797fffcf7270ad8f86b600f89&X-Amz-SignedHeaders=host&actor_id=0&key_id=0&repo_id=636389020&response-content-disposition=attachment%3B%20filename%3Dmodel_zoo.py&response-content-type=application%2Foctet-stream

Resolving objects.githubusercontent.com (objects.githubusercontent.com)... 185.199.110.133, 185.199.111.133, 185.199.109.133, ...

Connecting to objects.githubusercontent.com (objects.githubusercontent.com)|185.199.110.133|:443... connected.

HTTP request sent, awaiting response... 200 OK

Length: 1808 (1.8K) [application/octet-stream]

Saving to: ‘/usr/local/lib/python3.10/dist-packages/insightface/model_zoo/model_zoo.py’

model_zoo.py 100%[===================>] 1.77K --.-KB/s in 0s

2023-12-06 06:31:19 (36.3 MB/s) - ‘/usr/local/lib/python3.10/dist-packages/insightface/model_zoo/model_zoo.py’ saved [1808/1808]

/usr/local/lib/python3.10/dist-packages/kornia/augmentation/augmentation.py:1830: DeprecationWarning: GaussianBlur is no longer maintained and will be removed from the future versions. Please use RandomGaussianBlur instead.

warnings.warn(

/usr/local/lib/python3.10/dist-packages/mxnet/numpy/utils.py:37: DeprecationWarning: `np.bool` is a deprecated alias for the builtin `bool`. To silence this warning, use `bool` by itself. Doing this will not modify any behavior and is safe. If you specifically wanted the numpy scalar type, use `np.bool_` here.

Deprecated in NumPy 1.20; for more details and guidance: https://numpy.org/devdocs/release/1.20.0-notes.html#deprecations

bool = onp.bool

/usr/local/lib/python3.10/dist-packages/mxnet/numpy/fallback.py:143: DeprecationWarning: In accordance with NEP 32, the function mirr was removed from NumPy version 1.20. A replacement for this function is available in the numpy_financial library: https://pypi.org/project/numpy-financial

mirr = onp.mirr

/usr/local/lib/python3.10/dist-packages/mxnet/numpy/fallback.py:160: DeprecationWarning: In accordance with NEP 32, the function npv was removed from NumPy version 1.20. A replacement for this function is available in the numpy_financial library: https://pypi.org/project/numpy-financial

npv = onp.npv

/usr/local/lib/python3.10/dist-packages/mxnet/numpy/fallback.py:164: DeprecationWarning: In accordance with NEP 32, the function pmt was removed from NumPy version 1.20. A replacement for this function is available in the numpy_financial library: https://pypi.org/project/numpy-financial

pmt = onp.pmt

/usr/local/lib/python3.10/dist-packages/mxnet/numpy/fallback.py:173: DeprecationWarning: In accordance with NEP 32, the function ppmt was removed from NumPy version 1.20. A replacement for this function is available in the numpy_financial library: https://pypi.org/project/numpy-financial

ppmt = onp.ppmt

/usr/local/lib/python3.10/dist-packages/mxnet/numpy/fallback.py:176: DeprecationWarning: In accordance with NEP 32, the function pv was removed from NumPy version 1.20. A replacement for this function is available in the numpy_financial library: https://pypi.org/project/numpy-financial

pv = onp.pv

/usr/local/lib/python3.10/dist-packages/mxnet/numpy/fallback.py:177: DeprecationWarning: In accordance with NEP 32, the function rate was removed from NumPy version 1.20. A replacement for this function is available in the numpy_financial library: https://pypi.org/project/numpy-financial

rate = onp.rate

/usr/local/lib/python3.10/dist-packages/mxnet/numpy_dispatch_protocol.py:48: DeprecationWarning: distutils Version classes are deprecated. Use packaging.version instead.

cur_np_ver = LooseVersion(_np.__version__)

/usr/local/lib/python3.10/dist-packages/mxnet/numpy_dispatch_protocol.py:49: DeprecationWarning: distutils Version classes are deprecated. Use packaging.version instead.

np_1_17_ver = LooseVersion('1.17')

/usr/local/lib/python3.10/dist-packages/mxnet/numpy_dispatch_protocol.py:68: DeprecationWarning: distutils Version classes are deprecated. Use packaging.version instead.

cur_np_ver = LooseVersion(_np.__version__)

/usr/local/lib/python3.10/dist-packages/mxnet/numpy_dispatch_protocol.py:69: DeprecationWarning: distutils Version classes are deprecated. Use packaging.version instead.

np_1_15_ver = LooseVersion('1.15')

/content/sber-swap/models/networks/normalization.py:68: DeprecationWarning: invalid escape sequence '\D'

parsed = re.search('spade(\D+)(\d)x\d', config_text)

/content/sber-swap/utils/inference/util.py:165: DeprecationWarning: invalid escape sequence '\d'

return [atoi(c) for c in re.split('(\d+)', text)]

input mean and std: 127.5 127.5

find model: ./insightface_func/models/antelope/glintr100.onnx recognition

find model: ./insightface_func/models/antelope/scrfd_10g_bnkps.onnx detection

set det-size: (640, 640)

loading ./coordinate_reg/model/2d106det 0

input mean and std: 127.5 127.5

find model: ./insightface_func/models/antelope/glintr100.onnx recognition

find model: ./insightface_func/models/antelope/scrfd_10g_bnkps.onnx detection

set det-size: (640, 640)

Network [LIPSPADEGenerator] was created. Total number of parameters: 72.2 million. To see the architecture, do print(network).

Load checkpoint from path: weights/10_net_G.pth

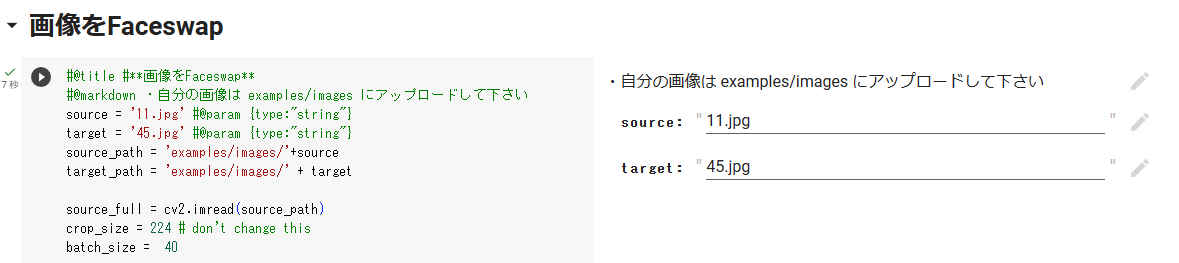

#@title #**画像をFaceswap**

#@markdown ・自分の画像は examples/images にアップロードして下さい

source = '11.jpg' #@param {type:"string"}

target = '45.jpg' #@param {type:"string"}

source_path = 'examples/images/'+source

target_path = 'examples/images/' + target

source_full = cv2.imread(source_path)

crop_size = 224 # don't change this

batch_size = 40

source = crop_face(source_full, app, crop_size)[0]

source = [source[:, :, ::-1]]

target_full = cv2.imread(target_path)

full_frames = [target_full]

target = get_target(full_frames, app, crop_size)

final_frames_list, crop_frames_list, full_frames, tfm_array_list = model_inference(full_frames,source,target,netArc,G,app,set_target = False,crop_size=crop_size,BS=batch_size)

result = get_final_image(final_frames_list, crop_frames_list, full_frames[0], tfm_array_list, handler)

cv2.imwrite('examples/results/result.png', result)

/usr/local/lib/python3.10/dist-packages/ipykernel/ipkernel.py:283: DeprecationWarning: `should_run_async` will not call `transform_cell` automatically in the future. Please pass the result to `transformed_cell` argument and any exception that happen during thetransform in `preprocessing_exc_tuple` in IPython 7.17 and above. and should_run_async(code) 100%|██████████| 1/1 [00:00<00:00, 44.02it/s] 1it [00:00, 1156.09it/s] 100%|██████████| 1/1 [00:00<00:00, 1.75it/s] 100%|██████████| 1/1 [00:00<00:00, 1737.49it/s] /usr/local/lib/python3.10/dist-packages/mxnet/ndarray/utils.py:141: DeprecationWarning: Please use `csr_matrix` from the `scipy.sparse` namespace, the `scipy.sparse.csr` namespace is deprecated. if spsp is not None and isinstance(source_array, spsp.csr.csr_matrix): /usr/local/lib/python3.10/dist-packages/mxnet/ndarray/utils.py:141: DeprecationWarning: Please use `csr_matrix` from the `scipy.sparse` namespace, the `scipy.sparse.csr` namespace is deprecated. if spsp is not None and isinstance(source_array, spsp.csr.csr_matrix): /content/sber-swap/utils/inference/masks.py:7: DeprecationWarning: `np.int` is a deprecated alias for the builtin `int`. To silence this warning, use `int` by itself. Doing this will not modify any behavior and is safe. When replacing `np.int`, you may wish to use e.g. `np.int64` or `np.int32` to specify the precision. If you wish to review your current use, check the release note link for additional information. Deprecated in NumPy 1.20; for more details and guidance: https://numpy.org/devdocs/release/1.20.0-notes.html#deprecations lmrks = np.array( lmrks.copy(), dtype=np.int ) True

#@markdown #**画像を表示** #@markdown ・画像は examples/results/results.png に保存されています import matplotlib.pyplot as plt show_images([source[0][:, :, ::-1], target_full, result], ['Source Image', 'Target Image', 'Swapped Image'], figsize=(20, 15))

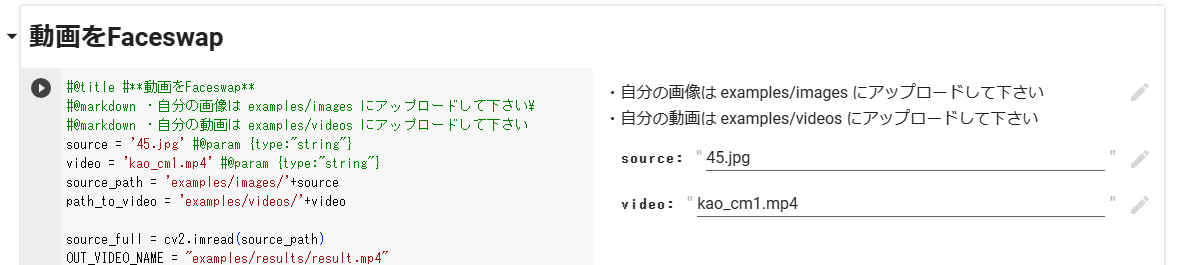

#@title #**動画をFaceswap**

#@markdown ・自分の画像は examples/images にアップロードして下さい\

#@markdown ・自分の動画は examples/videos にアップロードして下さい

source = '45.jpg' #@param {type:"string"}

video = 'kao_cm1.mp4' #@param {type:"string"}

source_path = 'examples/images/'+source

path_to_video = 'examples/videos/'+video

source_full = cv2.imread(source_path)

OUT_VIDEO_NAME = "examples/results/result.mp4"

crop_size = 224 # don't change this

batch_size = 40

source = crop_face(source_full, app, crop_size)[0]

source = [source[:, :, ::-1]]

full_frames, fps = read_video(path_to_video)

target = get_target(full_frames, app, crop_size)

START_TIME = time.time()

final_frames_list, crop_frames_list, full_frames, tfm_array_list = model_inference(full_frames,source,target,netArc,G,app,set_target = False,crop_size=crop_size,BS=batch_size)

if use_sr:

final_frames_list = face_enhancement(final_frames_list, model)

get_final_video(final_frames_list,crop_frames_list,full_frames,tfm_array_list,OUT_VIDEO_NAME,fps,handler)

add_audio_from_another_video(path_to_video, OUT_VIDEO_NAME, "audio")

print(f'Full pipeline took {time.time() - START_TIME}')

print(f"Video saved with path {OUT_VIDEO_NAME}")