私的AI研究会 > ProjectEnv2

AI開発プロジェクト実行に必要な環境を新しく作成する手順(最新版)

『PyTorch ではじめる AI開発』以降のページを実行するために新しく環境を作成する

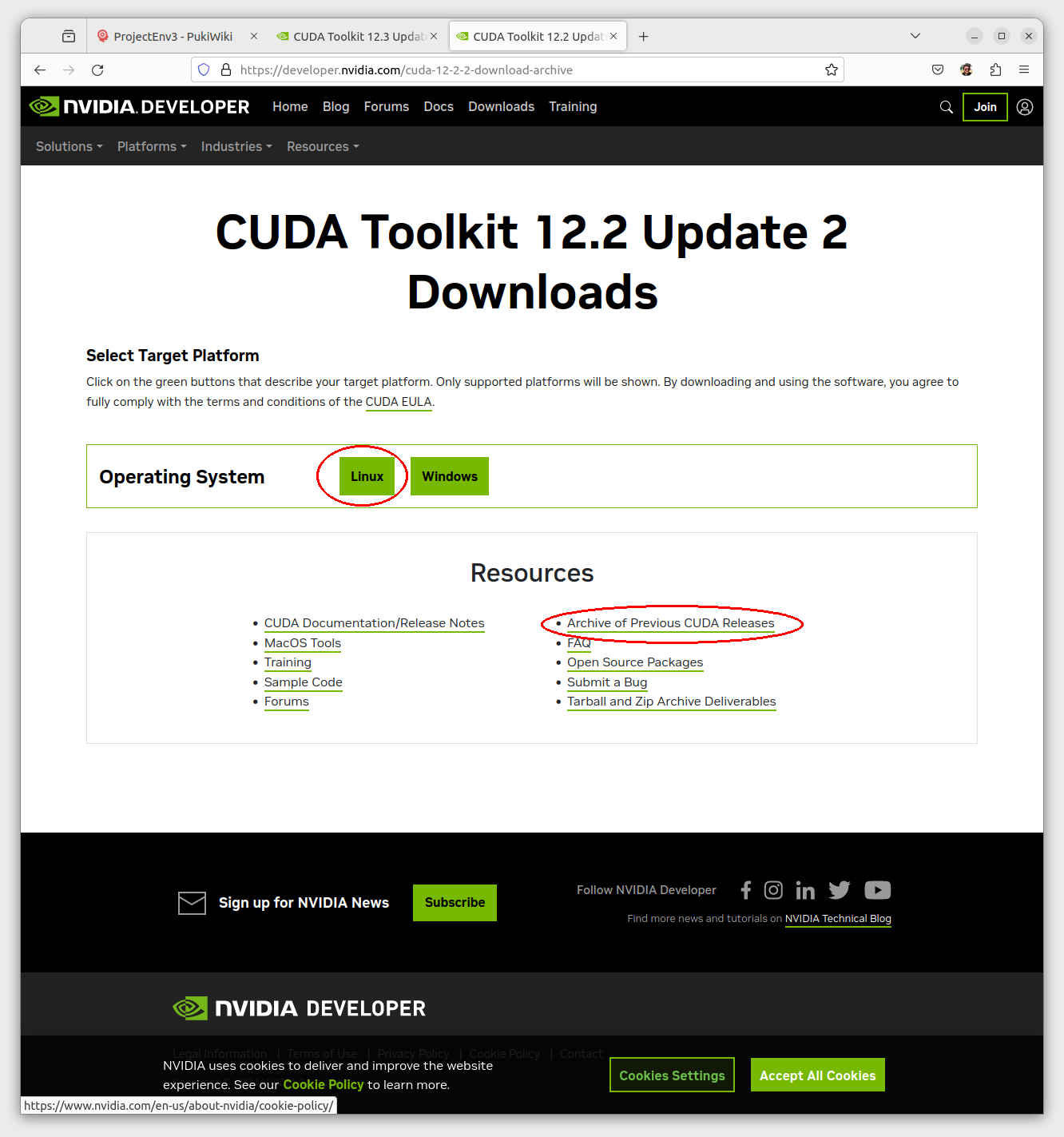

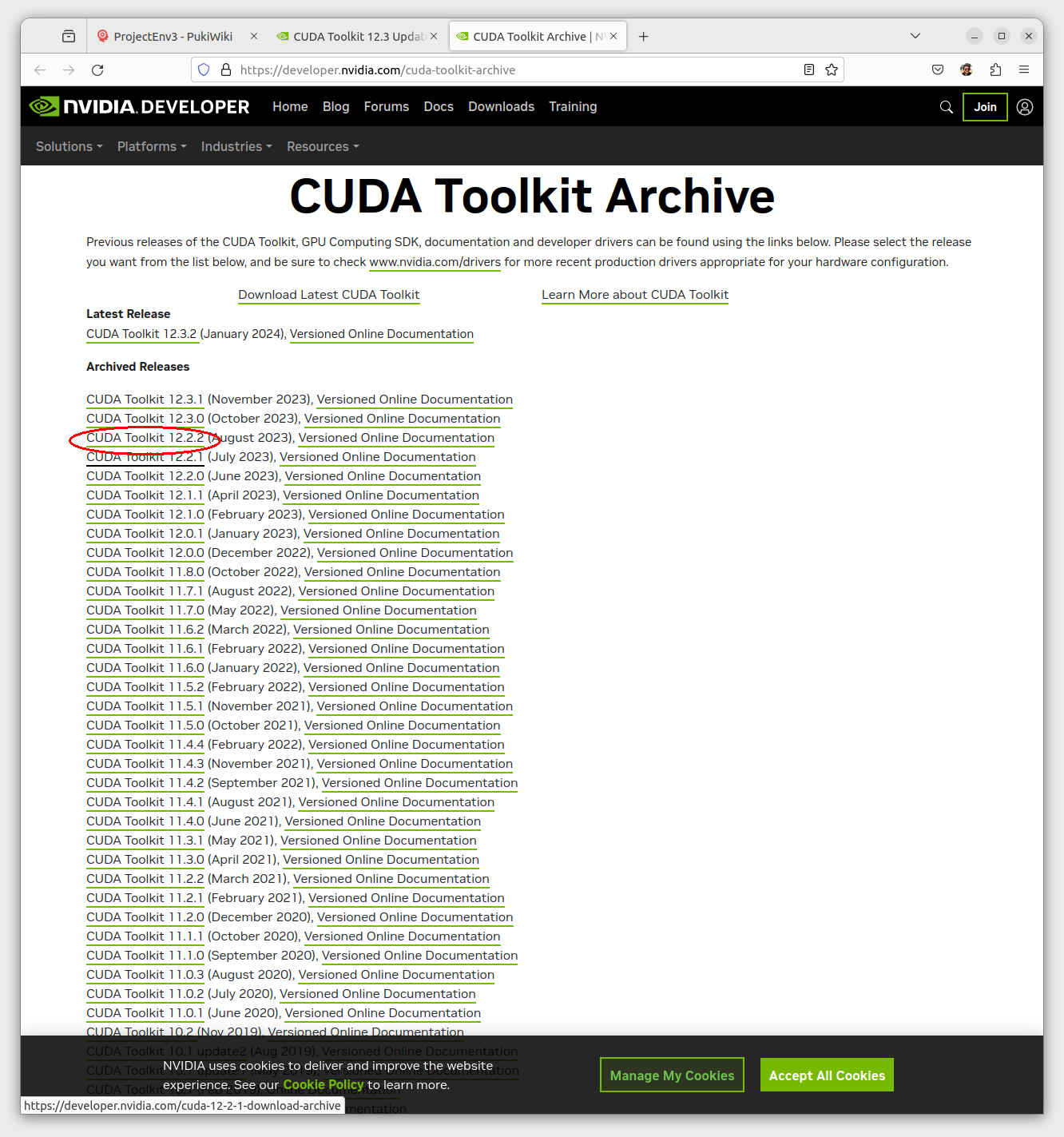

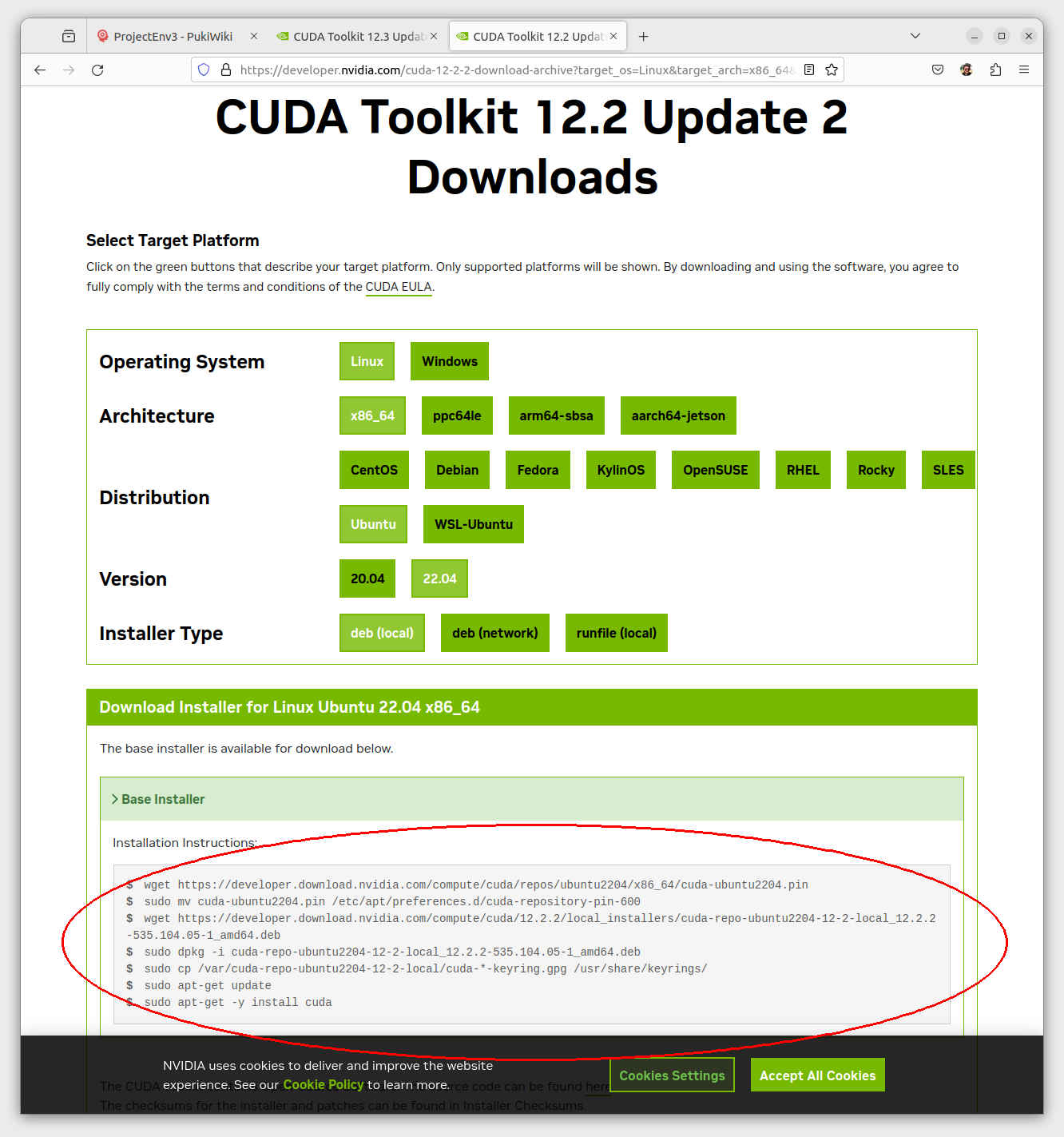

同時に「NVIDIA cuda GPU」を使用できる環境構築をする

HP ENVY Desktop TE02-1097jp

Intel® NUC BXNUC10I5FNH

$ cd ダウンロード

$ ls

Anaconda3-2023.09-0-Linux-x86_64.sh

$ bash Anaconda3-2023.09-0-Linux-x86_64.sh

Welcome to Anaconda3 2023.09-0

In order to continue the installation process, please review the license

agreement.

Please, press ENTER to continue

>>> ← Enter入力

:

Do you accept the license terms? [yes|no]

[no] >>> yes ← yes入力

Anaconda3 will now be installed into this location:

/home/USER/anaconda3

- Press ENTER to confirm the location

- Press CTRL-C to abort the installation

- Or specify a different location below

[/home/USER/anaconda3] >>> ← Enter入力

:

You can undo this by running `conda init --reverse $SHELL`? [yes|no]

[no] >>> ← Enter入力

:

conda init

Thank you for installing Anaconda3!

$ source ~/anaconda3/etc/profile.d/conda.sh ← conda 初期設定(ターミナル起動後一度だけ実行) $ conda -V ← conda バージョン表示 conda 23.7.4 $ conda info -e ← conda 仮想環境一覧表示 # conda environments: # base /home/USER/anaconda3

| 名称 | Python | PyTorch | プロジェクト名称 | 主に使用するプロジェクトフォルダ |

| base | 3.11.5 | - | - | - |

| py311 | 3.11.7 | 2.2.0+cu121 | - | /work |

| py37 | 3.7.16 | 1.13.1 | PyTorch ではじめる AI開発 | /workspace_py37 |

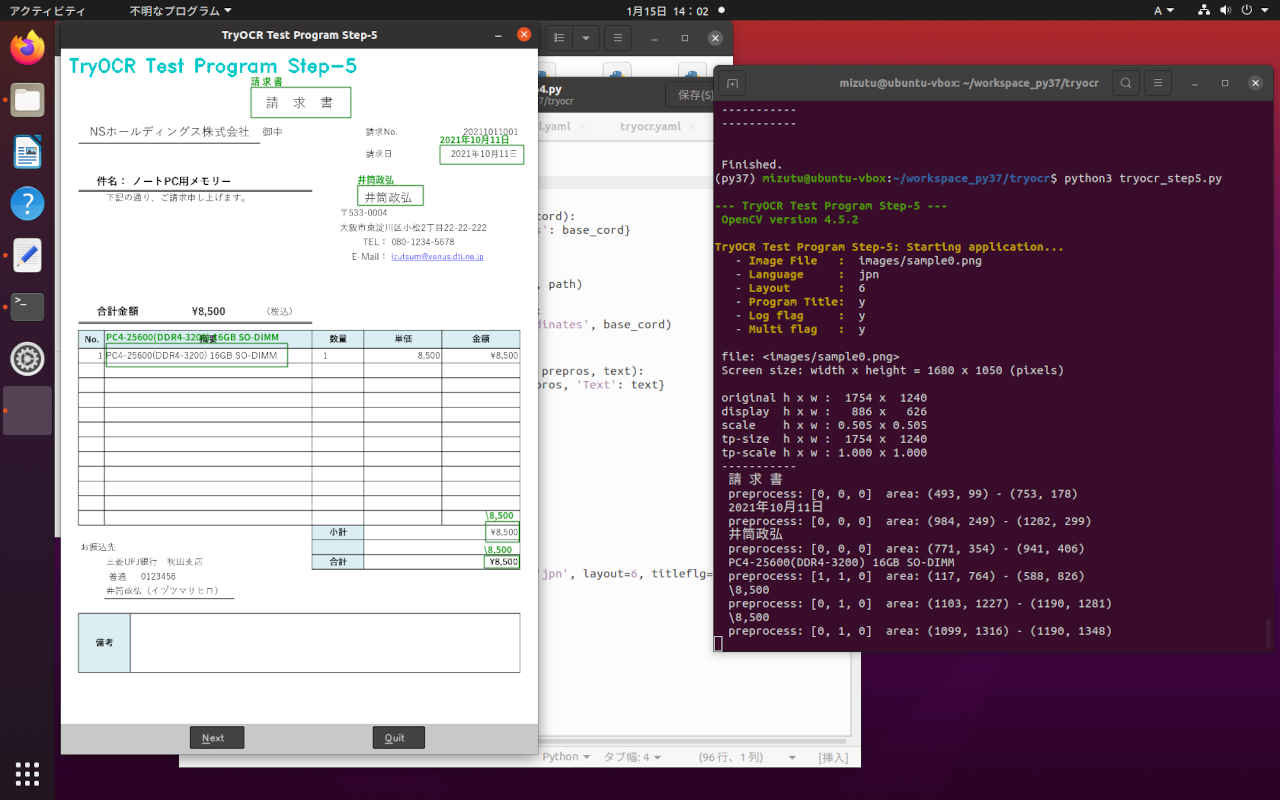

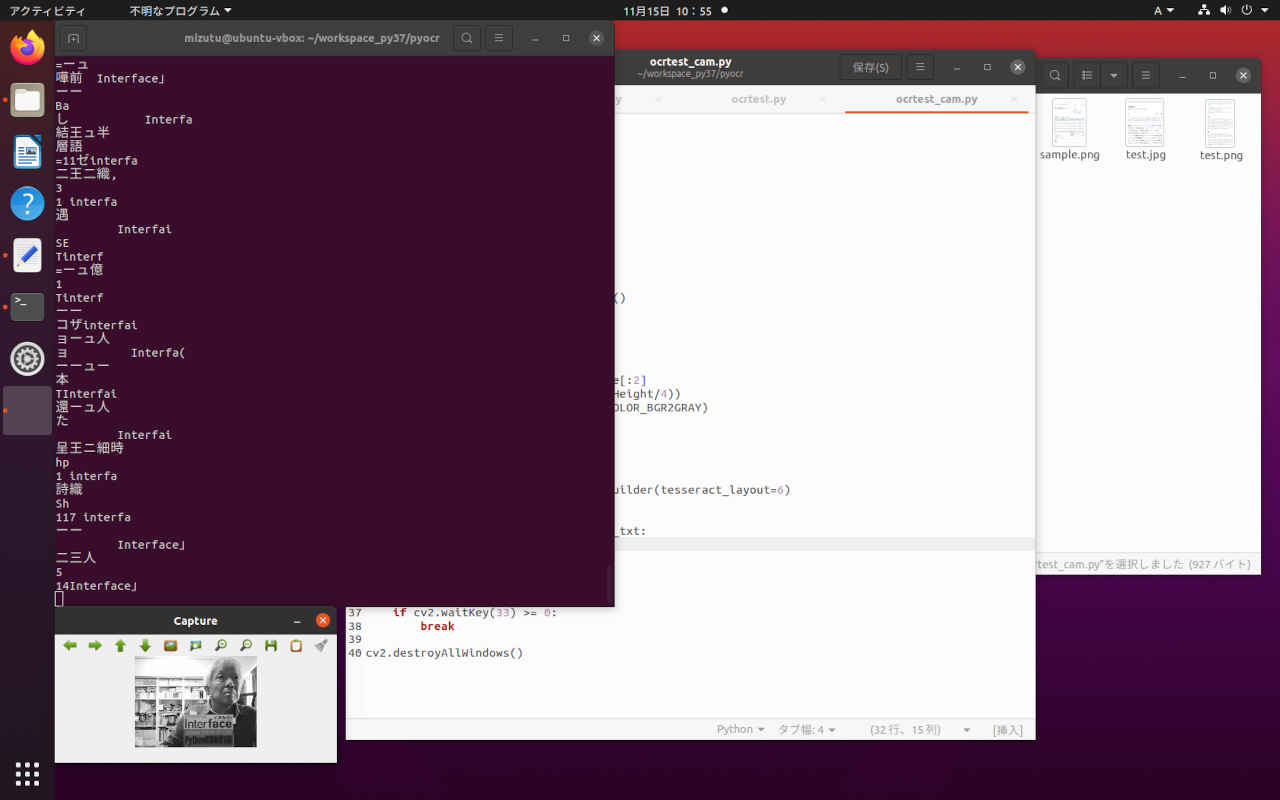

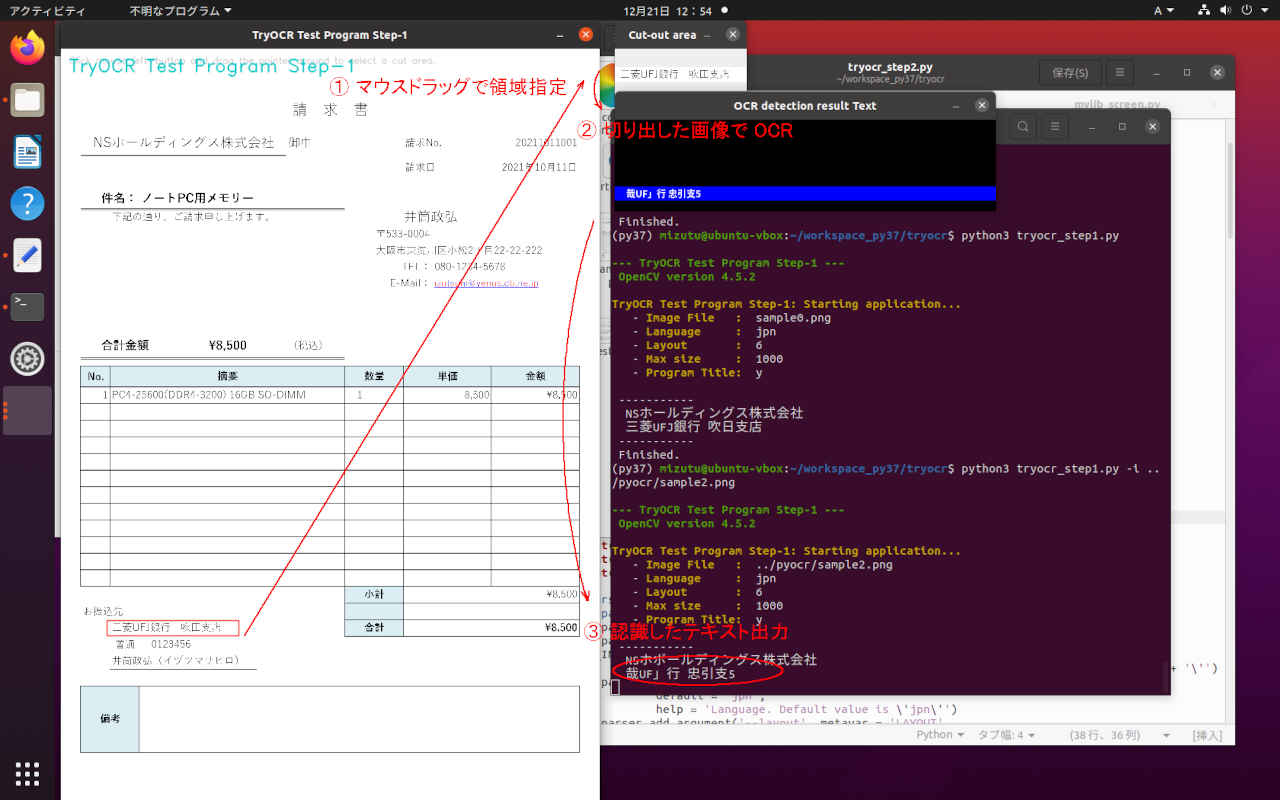

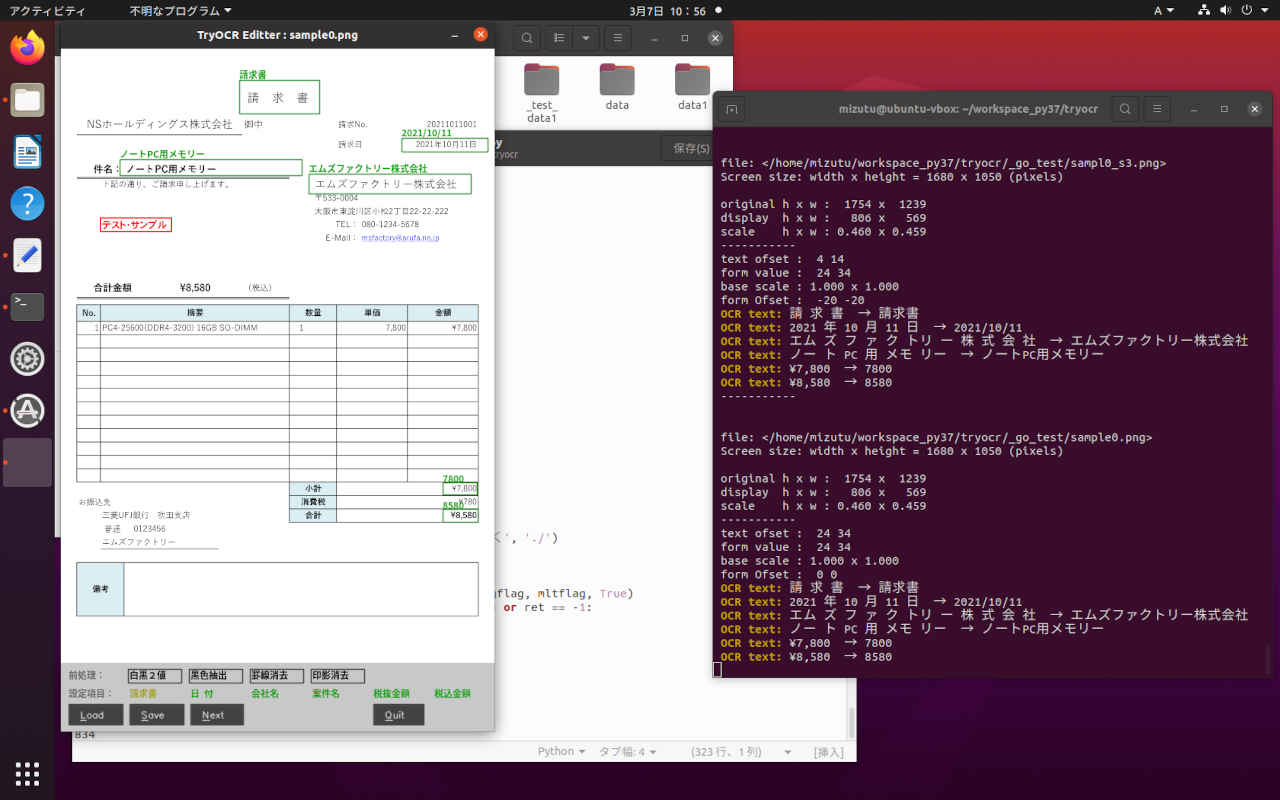

| py37x | 3.7.11 | 1.8.1+cu102 | 文字認識「OCR」 | /workspace_py37 |

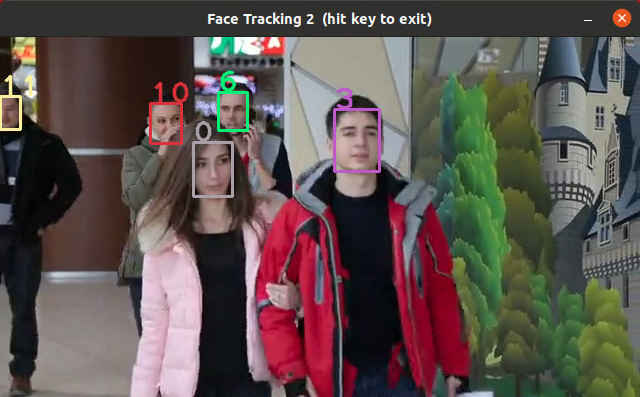

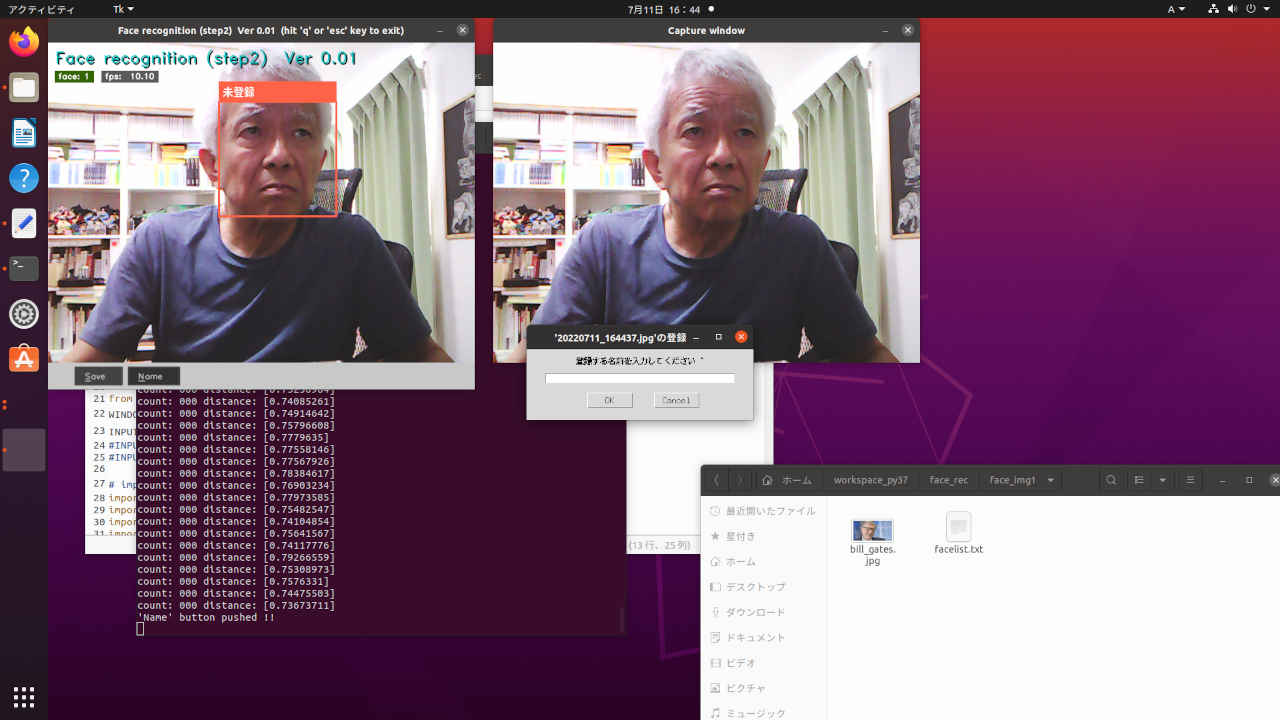

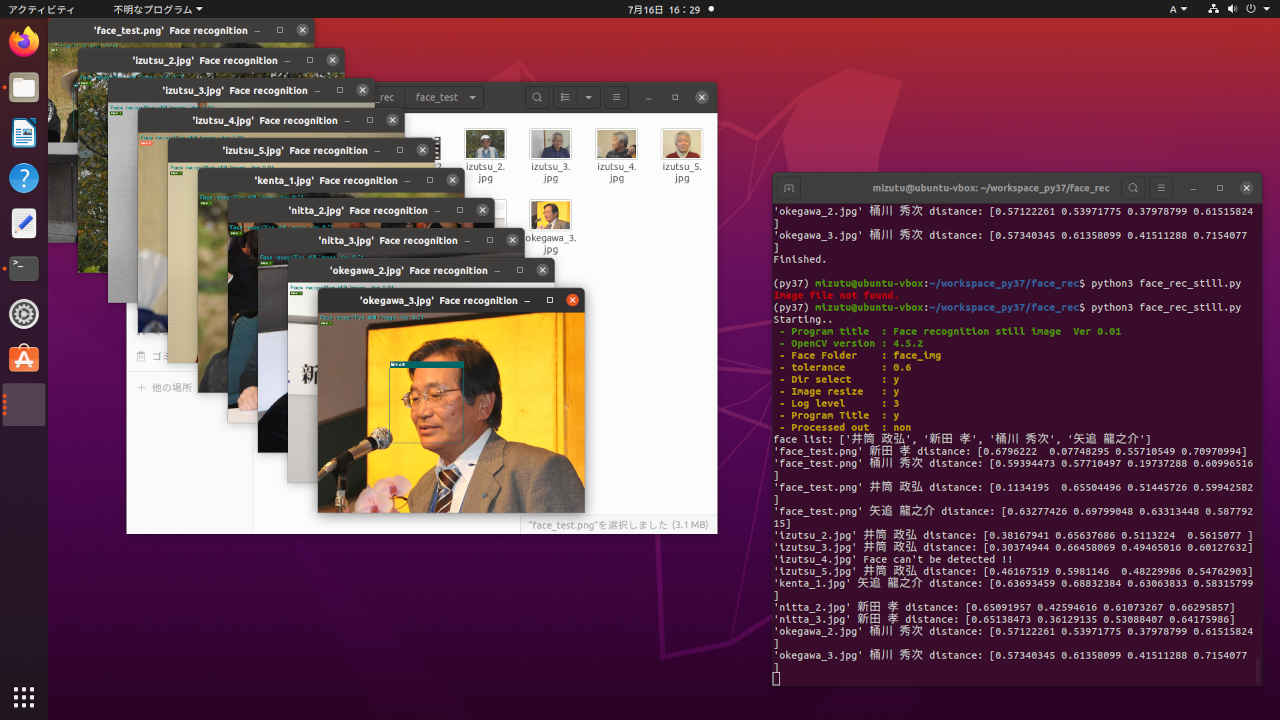

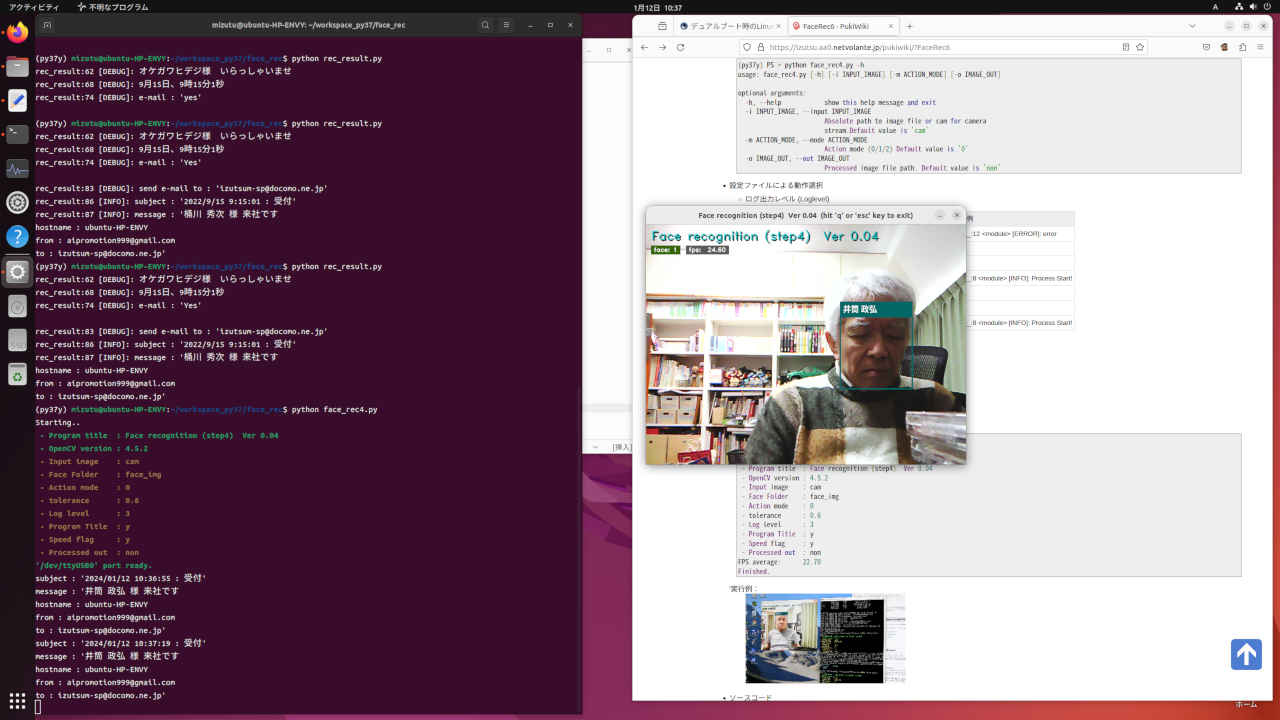

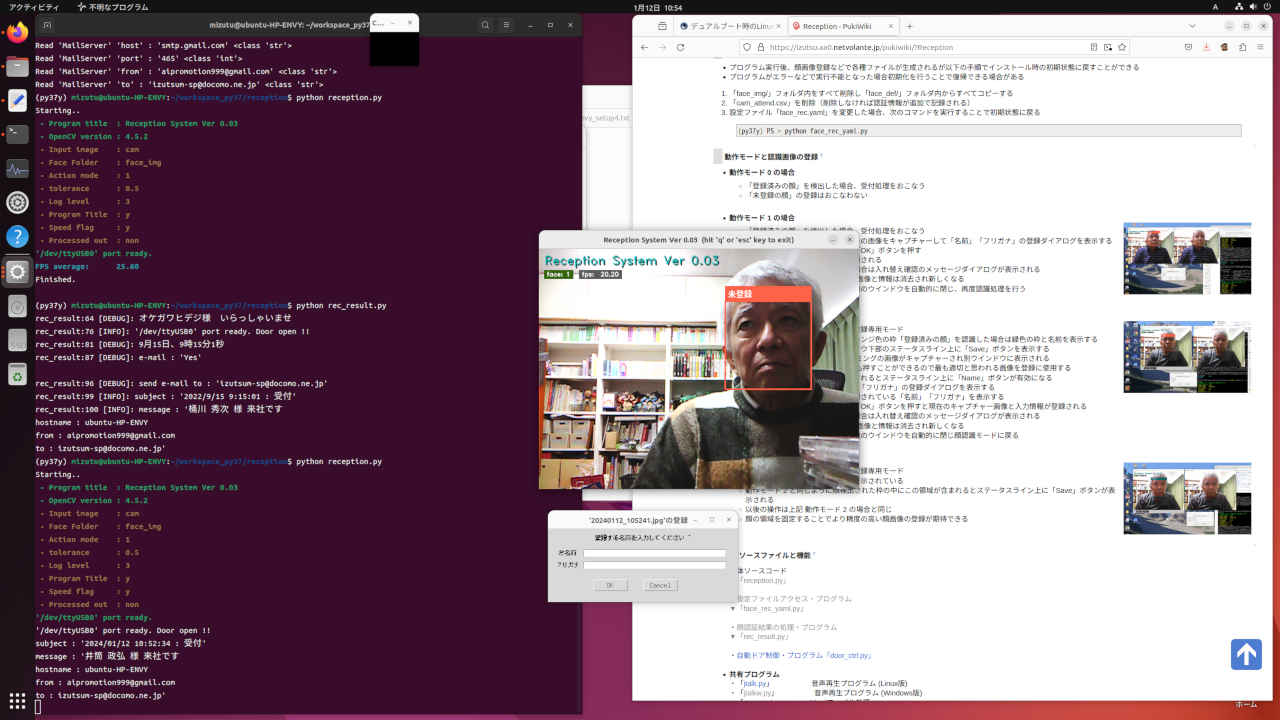

| py37y | 3.7.11 | 1.8.1+cu102 | 顔認証「Face recognition」 | /workspace_py37 |

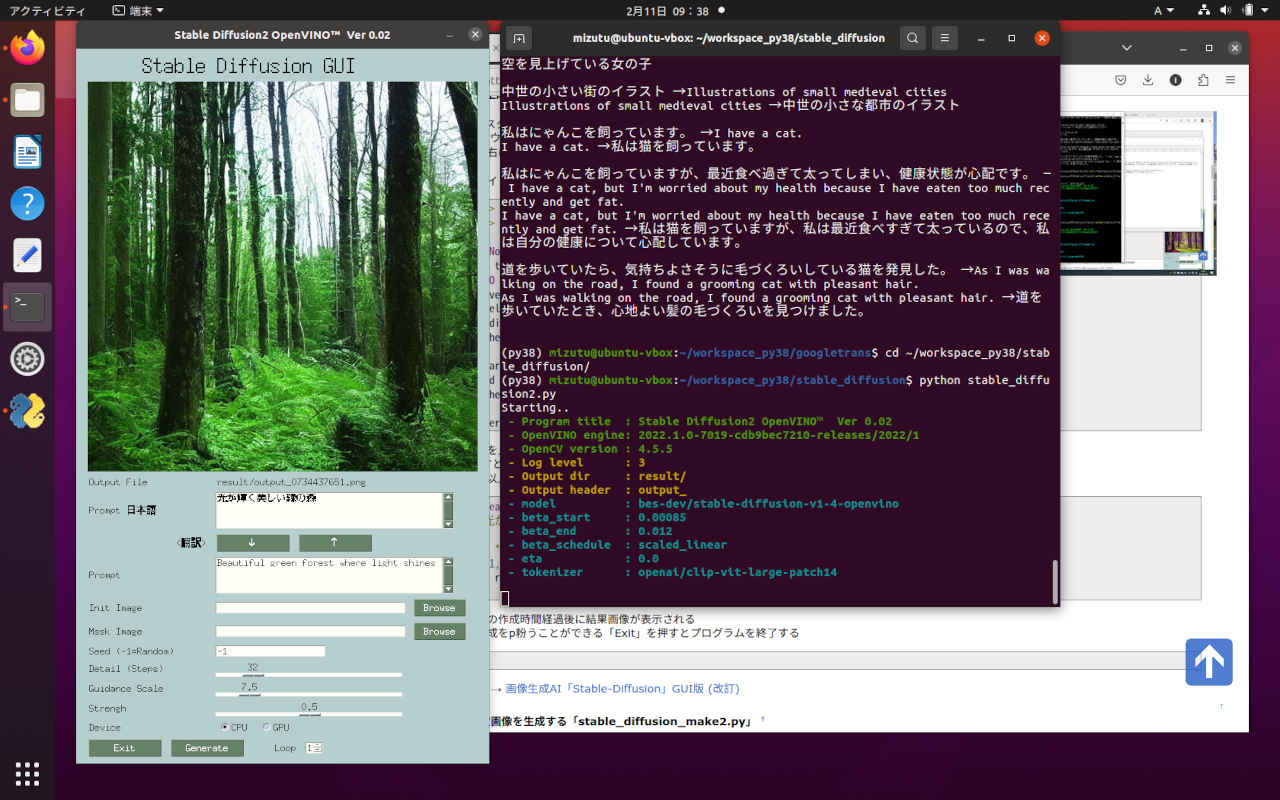

| py38 | 3.8.18 | 2.2.0+cu121 | 画像生成「Stable-diffusion」 | /workspace_py38 |

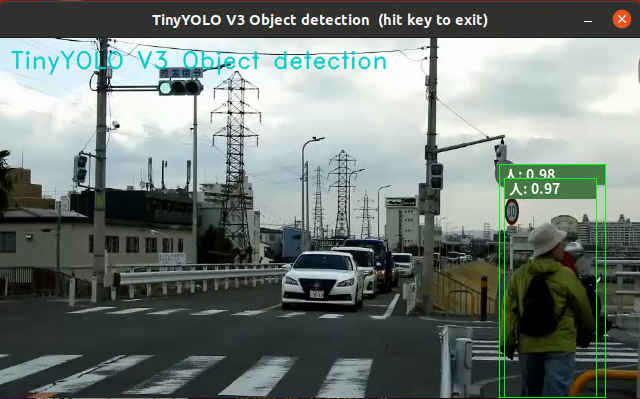

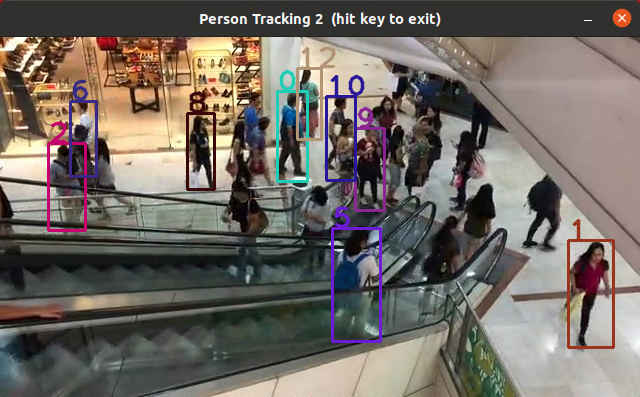

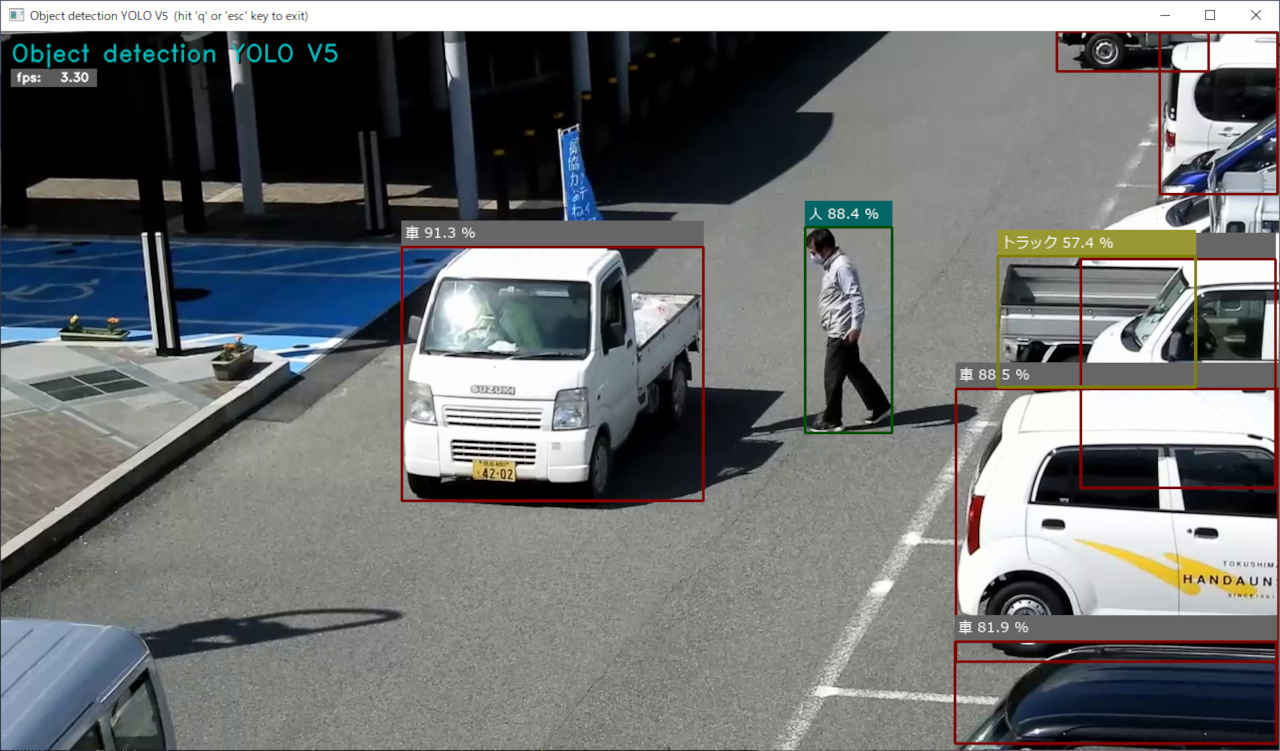

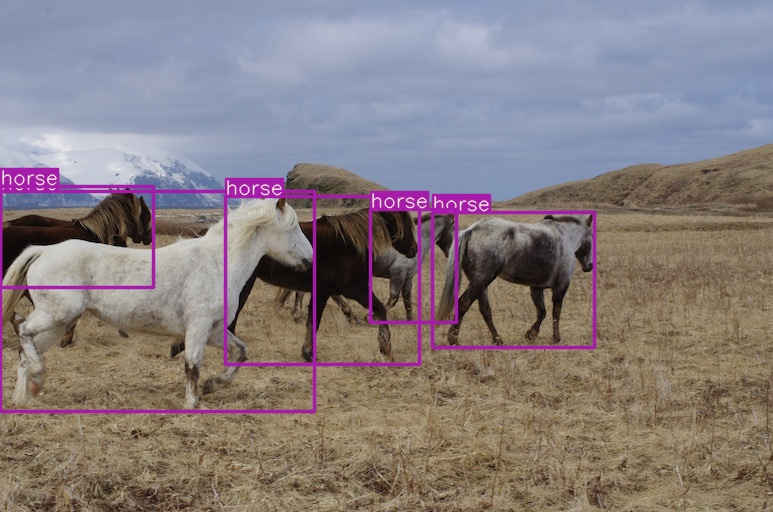

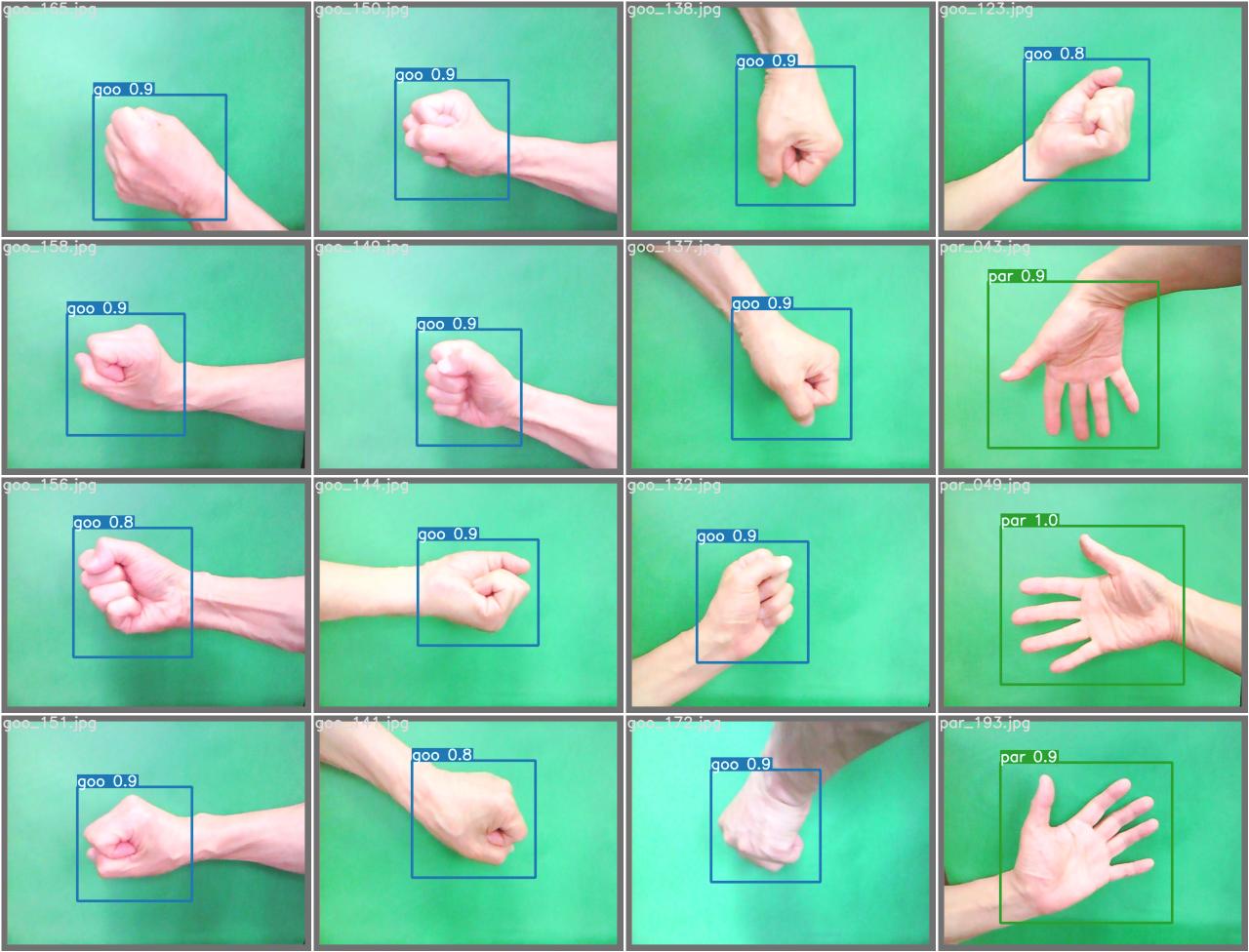

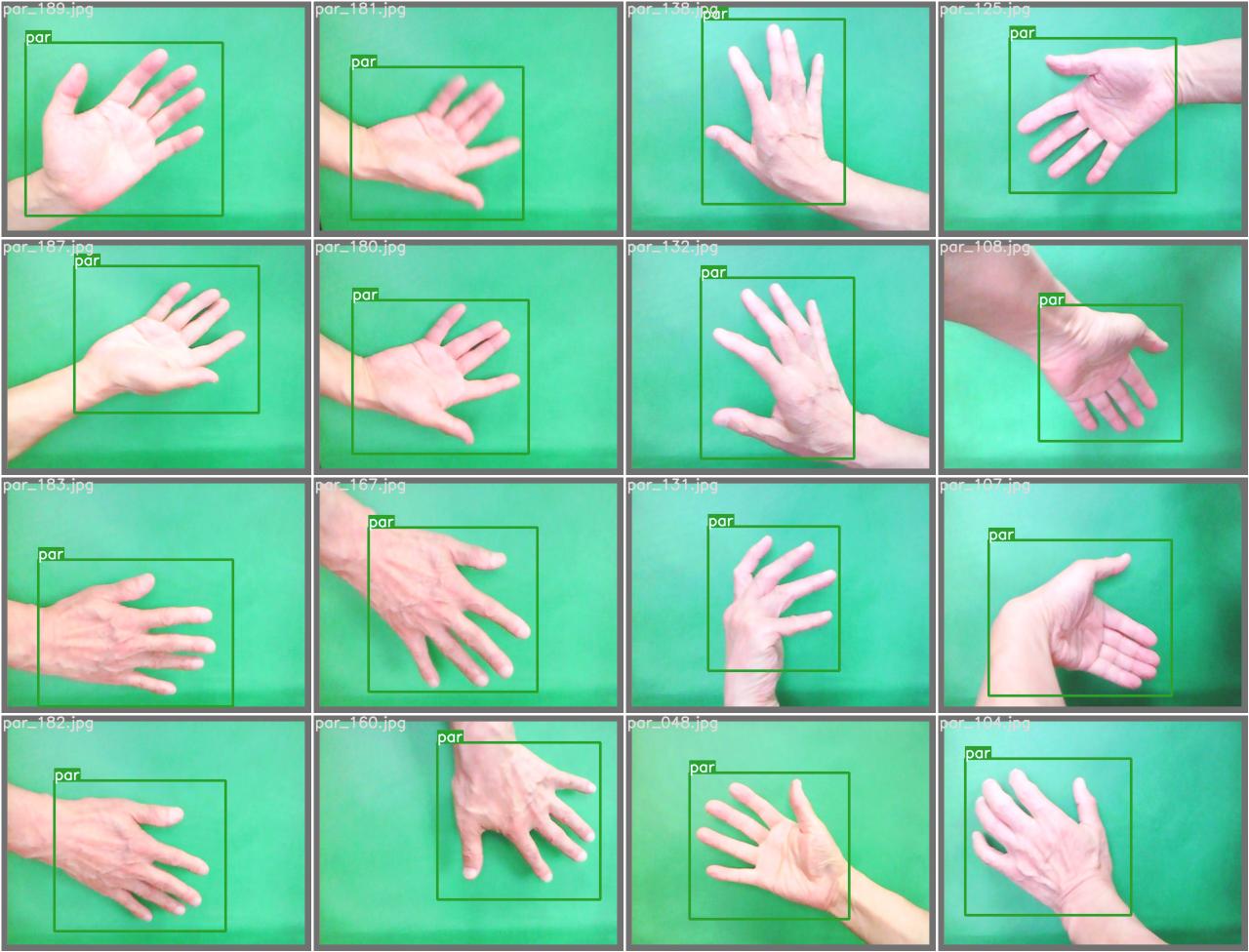

| py38a | 3.8.18 | 2.2.0+cu121 | 物体認識「YOLO V7」 | /work |

| py38b | 3.8.18 | 2.2.0+cu121 | 物体認識「YOLO V7」 | /work |

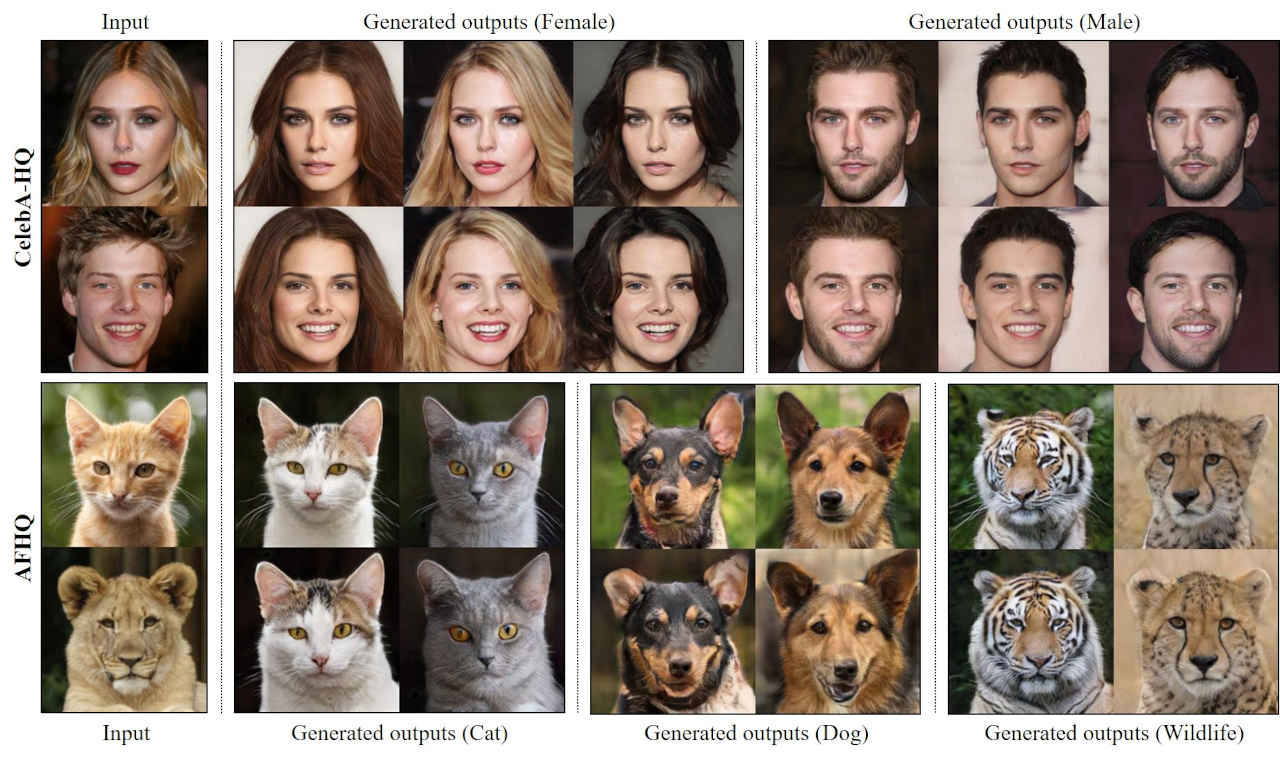

| py38_gan | 3.8.18 | 2.1.2+cu121 | GAN(敵対的生成ネットワーク)」 | /work |

| py_learn | 3.11.7 | 2.2.0+cu121 | PyTorch ではじめる AI開発(復習) | /workspace_py37 |

python -V python -c 'import torch;print(torch.__version__)' python ~/workspace_py311/cuda_test.py※ cuda 利用可能な環境では PyTorch インストール時に指定がない場合、標準で cuda 対応版がインストールされる

(***) $ which python (***) $ which pip (***) $ which conda

(***) $ which python3 (***) $ which pip3

(***) $ python -V

[env_select.sh] Environment Select !! 0: Nomal 1: Anaconda (base) 2: Anaconda (py311)+cuda 3: Anaconda (py37) 4: Anaconda (py37x) 5: Anaconda (py37y) 6: Anaconda (py38) 7: Anaconda (py38a) 8: Anaconda (py38b)+cuda 9: Anaconda (py38_gan) Prease input '0-9' : 1 ** Anaconda environment (base) !! ** [anaconda_setup.sh] Anaconda3 (base) environment initialized conda activate base Exit >> 'conda deactivate' (base) $

#!/bin/sh echo "[anaconda_setup.sh] Anaconda3 (base) environment initialized" source $HOME/anaconda3/etc/profile.d/conda.sh echo "conda activate base" echo " Exit >> 'conda deactivate'" conda activate echo

#!/bin/sh

echo [env_select.sh] Environment Select !!

while :

do

echo " 0: Nomal"

echo " 1: Anaconda (base)"

echo " 2: Anaconda (py311)+cuda"

echo " 3: Anaconda (py37)"

echo " 4: Anaconda (py37x)"

echo " 5: Anaconda (py37y)"

echo " 6: Anaconda (py38)"

echo " 7: Anaconda (py38a)"

echo " 8: Anaconda (py38b)+cuda"

echo " 9: Anaconda (py38_gan)"

read -p " Prease input '0-9' : " key

if [ -z "$key" ]; then

echo -e " ** Phsh 'Enter' Nomal environment select !! **\n"

break

elif [ "$key" = "0" ]; then

echo -e " ** Nomal environment select !! **\n"

break

elif [ "$key" = "1" ]; then

echo -e " ** Anaconda environment (base) select !! **\n"

source $HOME/anaconda_setup.sh

break

elif [ "$key" = "2" ]; then

echo -e " ** Anaconda environment (py311)+cuda select !! **\n"

source $HOME/anaconda_setup_py311.sh

break

elif [ "$key" = "3" ]; then

echo -e " ** Anaconda environment (py37) select !! **\n"

source $HOME/anaconda_setup_py37.sh

break

elif [ "$key" = "4" ]; then

echo -e " ** Anaconda environment (py37x) select !! **\n"

source $HOME/anaconda_setup_py37x.sh

break

elif [ "$key" = "5" ]; then

echo -e " ** Anaconda environment (py37y) select !! **\n"

source $HOME/anaconda_setup_py37y.sh

break

elif [ "$key" = "6" ]; then

echo -e " ** Anaconda environment (py38) select !! **\n"

source $HOME/anaconda_setup_py38.sh

break

elif [ "$key" = "7" ]; then

echo -e " ** Anaconda environment (py38a) select !! **\n"

source $HOME/anaconda_setup_py38a.sh

break

elif [ "$key" = "8" ]; then

echo -e " ** Anaconda environment (py38b) select !! **\n"

source $HOME/anaconda_setup_py38b.sh

break

elif [ "$key" = "9" ]; then

echo -e " ** Anaconda environment (py38_gan) select !! **\n"

source $HOME/anaconda_setup_py38_gan.sh

break

else

echo -e " !!! Input error !!!\n"

fi

done

$ chmod u+x anaconda_setup.sh $ chmod u+x env_select.sh

: source env_select.sh

$ source ~/anaconda3/etc/profile.d/conda.sh・仮想環境作成

(base) $ conda create -n py37 python=3.7・仮想環境の確認

(py37) $ conda info -e ← conda 仮想環境一覧表示 # conda environments: # base /home/USER/anaconda3 py37 /home/USER/anaconda3/py37

(base) $ conda activate py37 (py37) $※ 現在の仮想環境から出る場合

(py37) $ conda deactivate $

#!/bin/sh

echo "[anaconda_setup_py37.sh] Anaconda3 (py37) environment initialized"

if [ -e $HOME/anaconda3/etc/profile.d/conda.sh ]; then

# Anaconda がインスール済みの環境

if [ -z "$ANACONDA_PATHSET" ]; then

export -n PYTHONPATH # 設定クリア

source $HOME/anaconda3/etc/profile.d/conda.sh

if [ -e $HOME/workspace/lib ]; then

export PYTHONPATH=$HOME/workspace/lib

fi

if [ -e $HOME/omz_demos_build/omz_demos.sh ]; then

source ~/omz_demos_build/omz_demos.sh

fi

ANACONDA_PATHSET=$PYTHONPATH

else

echo " Anaconda3 environment already setup !!"

if [ -n "$ANACONDA_PATHSET" ]; then

export PYTHONPATH=$ANACONDA_PATHSET

fi

fi

cd $HOME/workspace_py37

conda activate py37

conda info -e

OPENVINO_PATHSET= # OpenVINO 設定クリア

else

# Anaconda が存在しないとき

echo " Anaconda is not installed !!"

fi

export PYTHONPATH=$PYTHONPATH:$HOME/workspace_py37/mylib

echo " PYTHONPATH =" $PYTHONPATH

echo

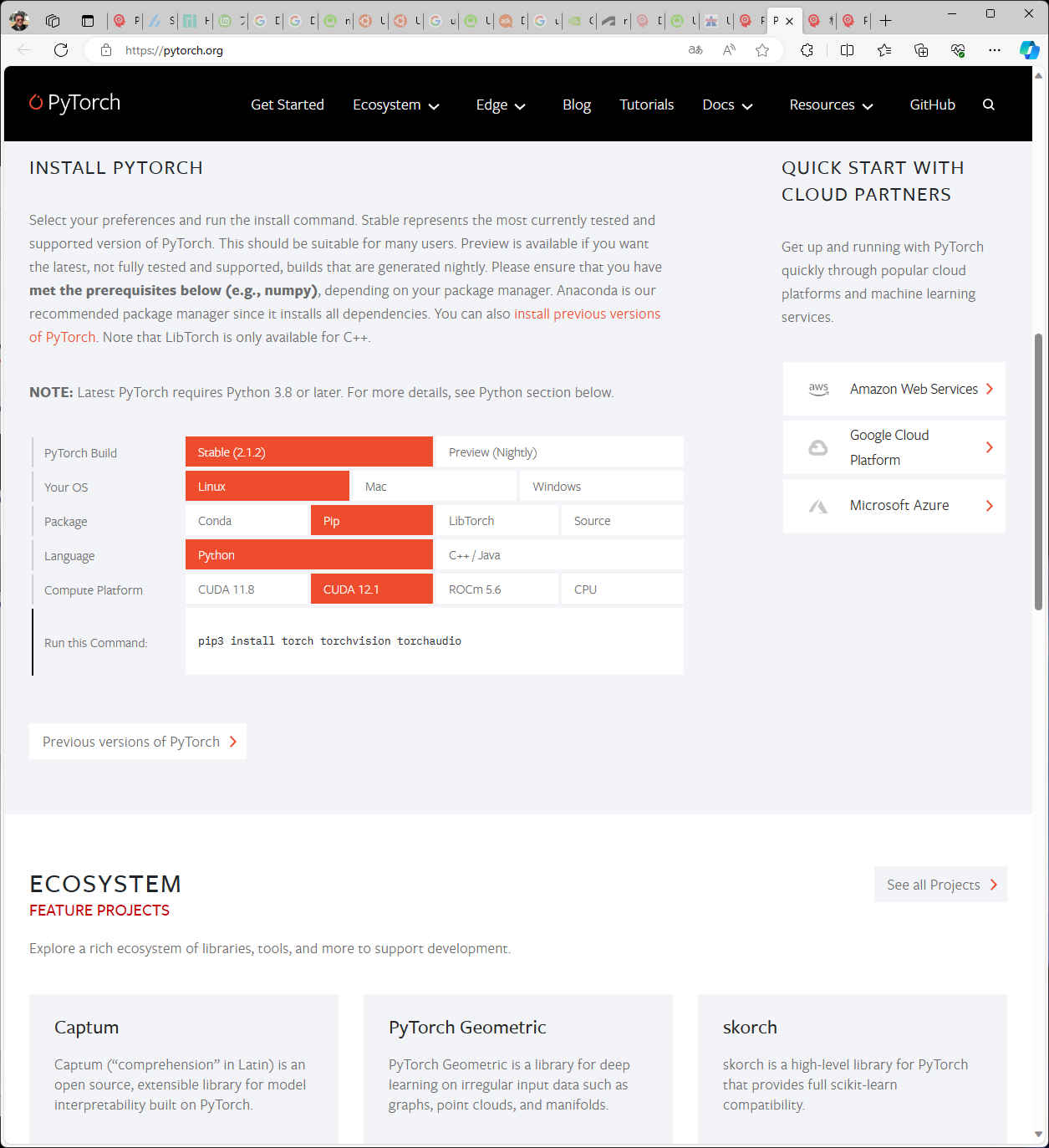

(py37) $ pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cpu ← CPUを指定

(py37) $ pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cpu

Looking in indexes: https://download.pytorch.org/whl/cpu

Collecting torch

Downloading https://download.pytorch.org/whl/cpu/torch-1.13.1%2Bcpu-cp37-cp37m-linux_x86_64.whl (199.1 MB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 199.1/199.1 MB 7.9 MB/s eta 0:00:00

Collecting torchvision

Downloading https://download.pytorch.org/whl/cpu/torchvision-0.14.1%2Bcpu-cp37-cp37m-linux_x86_64.whl (16.8 MB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 16.8/16.8 MB 41.0 MB/s eta 0:00:00

Collecting torchaudio

Downloading https://download.pytorch.org/whl/cpu/torchaudio-0.13.1%2Bcpu-cp37-cp37m-linux_x86_64.whl (4.0 MB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 4.0/4.0 MB 37.9 MB/s eta 0:00:00

Collecting typing-extensions

Downloading https://download.pytorch.org/whl/typing_extensions-4.4.0-py3-none-any.whl (26 kB)

Collecting numpy

Downloading https://download.pytorch.org/whl/numpy-1.21.6-cp37-cp37m-manylinux_2_12_x86_64.manylinux2010_x86_64.whl (15.7 MB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 15.7/15.7 MB 38.3 MB/s eta 0:00:00

Collecting pillow!=8.3.*,>=5.3.0

Downloading https://download.pytorch.org/whl/Pillow-9.3.0-cp37-cp37m-manylinux_2_17_x86_64.manylinux2014_x86_64.whl (3.2 MB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 3.2/3.2 MB 2.7 MB/s eta 0:00:00

Collecting requests

Downloading https://download.pytorch.org/whl/requests-2.28.1-py3-none-any.whl (62 kB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 62.8/62.8 kB 4.4 MB/s eta 0:00:00

Collecting urllib3<1.27,>=1.21.1

Downloading https://download.pytorch.org/whl/urllib3-1.26.13-py2.py3-none-any.whl (140 kB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 140.6/140.6 kB 9.9 MB/s eta 0:00:00

Collecting charset-normalizer<3,>=2

Downloading https://download.pytorch.org/whl/charset_normalizer-2.1.1-py3-none-any.whl (39 kB)

Collecting idna<4,>=2.5

Downloading https://download.pytorch.org/whl/idna-3.4-py3-none-any.whl (61 kB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 61.5/61.5 kB 4.4 MB/s eta 0:00:00

Requirement already satisfied: certifi>=2017.4.17 in ./anaconda3/envs/py37/lib/python3.7/site-packages (from requests->torchvision) (2022.12.7)

Installing collected packages: urllib3, typing-extensions, pillow, numpy, idna, charset-normalizer, torch, requests, torchvision, torchaudio

Successfully installed charset-normalizer-2.1.1 idna-3.4 numpy-1.21.6 pillow-9.3.0 requests-2.28.1 torch-1.13.1+cpu torchaudio-0.13.1+cpu torchvision-0.14.1+cpu typing-extensions-4.4.0 urllib3-1.26.13

WARNING: There was an error checking the latest version of pip.

(py37) $ sudo apt install libgtk2.0-dev

(py37) $ sudo apt install libgtk2.0-dev パッケージリストを読み込んでいます... 完了 依存関係ツリーを作成しています... 完了 状態情報を読み取っています... 完了 以下の追加パッケージがインストールされます: autoconf automake autopoint autotools-dev build-essential debhelper debugedit dh-autoreconf dh-strip-nondeterminism dpkg-dev dwz fakeroot g++ g++-11 gcc gcc-11 gettext gir1.2-gtk-2.0 icu-devtools intltool-debian libalgorithm-diff-perl libalgorithm-diff-xs-perl libalgorithm-merge-perl libarchive-cpio-perl libarchive-zip-perl libasan6 libatk1.0-dev libblkid-dev libbrotli-dev libc-dev-bin libc-devtools libc6-dev libcairo2-dev libcc1-0 libcrypt-dev libdatrie-dev libdebhelper-perl libdeflate-dev libexpat1-dev libfakeroot libffi-dev libfile-stripnondeterminism-perl libfontconfig-dev libfontconfig1-dev libfreetype-dev libfreetype6-dev libfribidi-dev libgcc-11-dev libgdk-pixbuf-2.0-dev libglib2.0-dev libglib2.0-dev-bin libgraphite2-dev libharfbuzz-dev libharfbuzz-gobject0 libice-dev libicu-dev libitm1 libjbig-dev libjpeg-dev libjpeg-turbo8-dev libjpeg8-dev liblsan0 libltdl-dev liblzma-dev libmail-sendmail-perl libmount-dev libnsl-dev libpango1.0-dev libpcre16-3 libpcre2-dev libpcre2-posix3 libpcre3-dev libpcre32-3 libpcrecpp0v5 libpixman-1-dev libpng-dev libpng-tools libpthread-stubs0-dev libselinux1-dev libsepol-dev libsigsegv2 libsm-dev libstdc++-11-dev libsub-override-perl libsys-hostname-long-perl libthai-dev libtiff-dev libtiffxx5 libtirpc-dev libtool libtsan0 libubsan1 libx11-dev libxau-dev libxcb-render0-dev libxcb-shm0-dev libxcb1-dev libxcomposite-dev libxcursor-dev libxdamage-dev libxdmcp-dev libxext-dev libxfixes-dev libxft-dev libxi-dev libxinerama-dev libxml2-utils libxrandr-dev libxrender-dev linux-libc-dev lto-disabled-list m4 make manpages-dev pango1.0-tools po-debconf python3-distutils rpcsvc-proto uuid-dev x11proto-dev xorg-sgml-doctools xtrans-dev zlib1g-dev 提案パッケージ: autoconf-archive gnu-standards autoconf-doc dh-make debian-keyring g++-multilib g++-11-multilib gcc-11-doc gcc-multilib flex bison gcc-doc gcc-11-multilib gcc-11-locales gettext-doc libasprintf-dev libgettextpo-dev glibc-doc libcairo2-doc libdatrie-doc freetype2-doc libgirepository1.0-dev libglib2.0-doc libgraphite2-utils libgtk2.0-doc libice-doc icu-doc libtool-doc liblzma-doc libpango1.0-doc libsm-doc libstdc++-11-doc libthai-doc gfortran | fortran95-compiler gcj-jdk libx11-doc libxcb-doc libxext-doc m4-doc make-doc graphicsmagick libmail-box-perl 以下のパッケージが新たにインストールされます: autoconf automake autopoint autotools-dev build-essential debhelper debugedit dh-autoreconf dh-strip-nondeterminism dpkg-dev dwz fakeroot g++ g++-11 gcc gcc-11 gettext gir1.2-gtk-2.0 icu-devtools intltool-debian libalgorithm-diff-perl libalgorithm-diff-xs-perl libalgorithm-merge-perl libarchive-cpio-perl libarchive-zip-perl libasan6 libatk1.0-dev libblkid-dev libbrotli-dev libc-dev-bin libc-devtools libc6-dev libcairo2-dev libcc1-0 libcrypt-dev libdatrie-dev libdebhelper-perl libdeflate-dev libexpat1-dev libfakeroot libffi-dev libfile-stripnondeterminism-perl libfontconfig-dev libfontconfig1-dev libfreetype-dev libfreetype6-dev libfribidi-dev libgcc-11-dev libgdk-pixbuf-2.0-dev libglib2.0-dev libglib2.0-dev-bin libgraphite2-dev libgtk2.0-dev libharfbuzz-dev libharfbuzz-gobject0 libice-dev libicu-dev libitm1 libjbig-dev libjpeg-dev libjpeg-turbo8-dev libjpeg8-dev liblsan0 libltdl-dev liblzma-dev libmail-sendmail-perl libmount-dev libnsl-dev libpango1.0-dev libpcre16-3 libpcre2-dev libpcre2-posix3 libpcre3-dev libpcre32-3 libpcrecpp0v5 libpixman-1-dev libpng-dev libpng-tools libpthread-stubs0-dev libselinux1-dev libsepol-dev libsigsegv2 libsm-dev libstdc++-11-dev libsub-override-perl libsys-hostname-long-perl libthai-dev libtiff-dev libtiffxx5 libtirpc-dev libtool libtsan0 libubsan1 libx11-dev libxau-dev libxcb-render0-dev libxcb-shm0-dev libxcb1-dev libxcomposite-dev libxcursor-dev libxdamage-dev libxdmcp-dev libxext-dev libxfixes-dev libxft-dev libxi-dev libxinerama-dev libxml2-utils libxrandr-dev libxrender-dev linux-libc-dev lto-disabled-list m4 make manpages-dev pango1.0-tools po-debconf python3-distutils rpcsvc-proto uuid-dev x11proto-dev xorg-sgml-doctools xtrans-dev zlib1g-dev アップグレード: 0 個、新規インストール: 124 個、削除: 0 個、保留: 5 個。 78.6 MB のアーカイブを取得する必要があります。 この操作後に追加で 292 MB のディスク容量が消費されます。 続行しますか? [Y/n] y 取得:1 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libsigsegv2 amd64 2.13-1ubuntu3 [14.6 kB] 取得:2 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 m4 amd64 1.4.18-5ubuntu2 [199 kB] 取得:3 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 autoconf all 2.71-2 [338 kB] 取得:4 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 autotools-dev all 20220109.1 [44.9 kB] 取得:5 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 automake all 1:1.16.5-1.3 [558 kB] 取得:6 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 autopoint all 0.21-4ubuntu4 [422 kB] 取得:7 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libc-dev-bin amd64 2.35-0ubuntu3.5 [20.3 kB] 取得:8 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 linux-libc-dev amd64 5.15.0-91.101 [1,332 kB] 取得:9 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libcrypt-dev amd64 1:4.4.27-1 [112 kB] 取得:10 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 rpcsvc-proto amd64 1.4.2-0ubuntu6 [68.5 kB] 取得:11 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libtirpc-dev amd64 1.3.2-2ubuntu0.1 [192 kB] 取得:12 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libnsl-dev amd64 1.3.0-2build2 [71.3 kB] 取得:13 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libc6-dev amd64 2.35-0ubuntu3.5 [2,098 kB] 取得:14 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libcc1-0 amd64 12.3.0-1ubuntu1~22.04 [48.3 kB] 取得:15 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libitm1 amd64 12.3.0-1ubuntu1~22.04 [30.2 kB] 取得:16 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libasan6 amd64 11.4.0-1ubuntu1~22.04 [2,282 kB] 取得:17 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 liblsan0 amd64 12.3.0-1ubuntu1~22.04 [1,069 kB] 取得:18 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libtsan0 amd64 11.4.0-1ubuntu1~22.04 [2,260 kB] 取得:19 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libubsan1 amd64 12.3.0-1ubuntu1~22.04 [976 kB] 取得:20 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libgcc-11-dev amd64 11.4.0-1ubuntu1~22.04 [2,517 kB] 取得:21 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 gcc-11 amd64 11.4.0-1ubuntu1~22.04 [20.1 MB] 取得:22 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 gcc amd64 4:11.2.0-1ubuntu1 [5,112 B] 取得:23 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libstdc++-11-dev amd64 11.4.0-1ubuntu1~22.04 [2,101 kB] 取得:24 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 g++-11 amd64 11.4.0-1ubuntu1~22.04 [11.4 MB] 取得:25 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 g++ amd64 4:11.2.0-1ubuntu1 [1,412 B] 取得:26 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 make amd64 4.3-4.1build1 [180 kB] 取得:27 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 lto-disabled-list all 24 [12.5 kB] 取得:28 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 dpkg-dev all 1.21.1ubuntu2.2 [922 kB] 取得:29 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 build-essential amd64 12.9ubuntu3 [4,744 B] 取得:30 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libdebhelper-perl all 13.6ubuntu1 [67.2 kB] 取得:31 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libtool all 2.4.6-15build2 [164 kB] 取得:32 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 dh-autoreconf all 20 [16.1 kB] 取得:33 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libarchive-zip-perl all 1.68-1 [90.2 kB] 取得:34 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libsub-override-perl all 0.09-2 [9,532 B] 取得:35 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libfile-stripnondeterminism-perl all 1.13.0-1 [18.1 kB] 取得:36 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 dh-strip-nondeterminism all 1.13.0-1 [5,344 B] 取得:37 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 debugedit amd64 1:5.0-4build1 [47.2 kB] 取得:38 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 dwz amd64 0.14-1build2 [105 kB] 取得:39 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 gettext amd64 0.21-4ubuntu4 [868 kB] 取得:40 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 intltool-debian all 0.35.0+20060710.5 [24.9 kB] 取得:41 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 po-debconf all 1.0.21+nmu1 [233 kB] 取得:42 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 debhelper all 13.6ubuntu1 [923 kB] 取得:43 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libfakeroot amd64 1.28-1ubuntu1 [31.5 kB] 取得:44 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 fakeroot amd64 1.28-1ubuntu1 [60.4 kB] 取得:45 http://jp.archive.ubuntu.com/ubuntu jammy/universe amd64 gir1.2-gtk-2.0 amd64 2.24.33-2ubuntu2 [210 kB] 取得:46 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 icu-devtools amd64 70.1-2 [197 kB] 取得:47 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libalgorithm-diff-perl all 1.201-1 [41.8 kB] 取得:48 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libalgorithm-diff-xs-perl amd64 0.04-6build3 [11.9 kB] 取得:49 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libalgorithm-merge-perl all 0.08-3 [12.0 kB] 取得:50 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libarchive-cpio-perl all 0.10-1.1 [9,928 B] 取得:51 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libffi-dev amd64 3.4.2-4 [63.7 kB] 取得:52 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 python3-distutils all 3.10.8-1~22.04 [139 kB] 取得:53 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libglib2.0-dev-bin amd64 2.72.4-0ubuntu2.2 [117 kB] 取得:54 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 uuid-dev amd64 2.37.2-4ubuntu3 [33.1 kB] 取得:55 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libblkid-dev amd64 2.37.2-4ubuntu3 [185 kB] 取得:56 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libsepol-dev amd64 3.3-1build1 [378 kB] 取得:57 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libpcre2-posix3 amd64 10.39-3ubuntu0.1 [6,130 B] 取得:58 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libpcre2-dev amd64 10.39-3ubuntu0.1 [730 kB] 取得:59 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libselinux1-dev amd64 3.3-1build2 [158 kB] 取得:60 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libmount-dev amd64 2.37.2-4ubuntu3 [14.5 kB] 取得:61 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libpcre16-3 amd64 2:8.39-13ubuntu0.22.04.1 [164 kB] 取得:62 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libpcre32-3 amd64 2:8.39-13ubuntu0.22.04.1 [155 kB] 取得:63 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libpcrecpp0v5 amd64 2:8.39-13ubuntu0.22.04.1 [16.5 kB] 取得:64 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libpcre3-dev amd64 2:8.39-13ubuntu0.22.04.1 [579 kB] 取得:65 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 zlib1g-dev amd64 1:1.2.11.dfsg-2ubuntu9.2 [164 kB] 取得:66 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libglib2.0-dev amd64 2.72.4-0ubuntu2.2 [1,739 kB] 取得:67 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libatk1.0-dev amd64 2.36.0-3build1 [96.6 kB] 取得:68 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libbrotli-dev amd64 1.0.9-2build6 [337 kB] 取得:69 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libc-devtools amd64 2.35-0ubuntu3.5 [28.9 kB] 取得:70 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libexpat1-dev amd64 2.4.7-1ubuntu0.2 [147 kB] 取得:71 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libpng-dev amd64 1.6.37-3build5 [192 kB] 取得:72 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libfreetype-dev amd64 2.11.1+dfsg-1ubuntu0.2 [555 kB] 取得:73 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libfreetype6-dev amd64 2.11.1+dfsg-1ubuntu0.2 [8,290 B] 取得:74 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libfontconfig-dev amd64 2.13.1-4.2ubuntu5 [151 kB] 取得:75 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libfontconfig1-dev amd64 2.13.1-4.2ubuntu5 [1,836 B] 取得:76 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 xorg-sgml-doctools all 1:1.11-1.1 [10.9 kB] 取得:77 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 x11proto-dev all 2021.5-1 [604 kB] 取得:78 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libxau-dev amd64 1:1.0.9-1build5 [9,724 B] 取得:79 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libxdmcp-dev amd64 1:1.1.3-0ubuntu5 [26.5 kB] 取得:80 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 xtrans-dev all 1.4.0-1 [68.9 kB] 取得:81 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libpthread-stubs0-dev amd64 0.4-1build2 [5,516 B] 取得:82 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libxcb1-dev amd64 1.14-3ubuntu3 [86.5 kB] 取得:83 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libx11-dev amd64 2:1.7.5-1ubuntu0.3 [744 kB] 取得:84 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libxrender-dev amd64 1:0.9.10-1build4 [26.7 kB] 取得:85 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libxext-dev amd64 2:1.3.4-1build1 [84.7 kB] 取得:86 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libice-dev amd64 2:1.0.10-1build2 [51.4 kB] 取得:87 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libsm-dev amd64 2:1.2.3-1build2 [18.1 kB] 取得:88 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libpixman-1-dev amd64 0.40.0-1ubuntu0.22.04.1 [280 kB] 取得:89 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libxcb-render0-dev amd64 1.14-3ubuntu3 [19.6 kB] 取得:90 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libxcb-shm0-dev amd64 1.14-3ubuntu3 [6,848 B] 取得:91 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libcairo2-dev amd64 1.16.0-5ubuntu2 [692 kB] 取得:92 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libdatrie-dev amd64 0.2.13-2 [19.7 kB] 取得:93 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libdeflate-dev amd64 1.10-2 [59.2 kB] 取得:94 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libfribidi-dev amd64 1.0.8-2ubuntu3.1 [64.8 kB] 取得:95 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libjpeg-turbo8-dev amd64 2.1.2-0ubuntu1 [257 kB] 取得:96 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libjpeg8-dev amd64 8c-2ubuntu10 [1,476 B] 取得:97 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libjpeg-dev amd64 8c-2ubuntu10 [1,472 B] 取得:98 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libjbig-dev amd64 2.1-3.1ubuntu0.22.04.1 [27.4 kB] 取得:99 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 liblzma-dev amd64 5.2.5-2ubuntu1 [159 kB] 取得:100 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libtiffxx5 amd64 4.3.0-6ubuntu0.7 [5,736 B] 取得:101 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libtiff-dev amd64 4.3.0-6ubuntu0.7 [315 kB] 取得:102 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libgdk-pixbuf-2.0-dev amd64 2.42.8+dfsg-1ubuntu0.2 [47.8 kB] 取得:103 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libgraphite2-dev amd64 1.3.14-1build2 [14.7 kB] 取得:104 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libharfbuzz-gobject0 amd64 2.7.4-1ubuntu3.1 [26.0 kB] 取得:105 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libicu-dev amd64 70.1-2 [11.6 MB] 取得:106 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libharfbuzz-dev amd64 2.7.4-1ubuntu3.1 [553 kB] 取得:107 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libthai-dev amd64 0.1.29-1build1 [26.4 kB] 取得:108 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libxft-dev amd64 2.3.4-1 [52.4 kB] 取得:109 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 pango1.0-tools amd64 1.50.6+ds-2ubuntu1 [45.8 kB] 取得:110 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libpango1.0-dev amd64 1.50.6+ds-2ubuntu1 [154 kB] 取得:111 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libxinerama-dev amd64 2:1.1.4-3 [8,104 B] 取得:112 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libxfixes-dev amd64 1:6.0.0-1 [12.2 kB] 取得:113 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libxi-dev amd64 2:1.8-1build1 [193 kB] 取得:114 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libxrandr-dev amd64 2:1.5.2-1build1 [26.7 kB] 取得:115 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libxcursor-dev amd64 1:1.2.0-2build4 [28.2 kB] 取得:116 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libxcomposite-dev amd64 1:0.4.5-1build2 [9,326 B] 取得:117 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libxdamage-dev amd64 1:1.1.5-2build2 [5,264 B] 取得:118 http://jp.archive.ubuntu.com/ubuntu jammy-updates/main amd64 libxml2-utils amd64 2.9.13+dfsg-1ubuntu0.3 [40.2 kB] 取得:119 http://jp.archive.ubuntu.com/ubuntu jammy/universe amd64 libgtk2.0-dev amd64 2.24.33-2ubuntu2 [778 kB] 取得:120 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libltdl-dev amd64 2.4.6-15build2 [169 kB] 取得:121 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libsys-hostname-long-perl all 1.5-2 [11.5 kB] 取得:122 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libmail-sendmail-perl all 0.80-1.1 [22.7 kB] 取得:123 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 libpng-tools amd64 1.6.37-3build5 [28.7 kB] 取得:124 http://jp.archive.ubuntu.com/ubuntu jammy/main amd64 manpages-dev all 5.10-1ubuntu1 [2,309 kB] 78.6 MB を 12秒 で取得しました (6,505 kB/s) パッケージからテンプレートを展開しています: 100% 以前に未選択のパッケージ libsigsegv2:amd64 を選択しています。 (データベースを読み込んでいます ... 現在 211874 個のファイルとディレクトリがインストールされています。) .../000-libsigsegv2_2.13-1ubuntu3_amd64.deb を展開する準備をしています ... libsigsegv2:amd64 (2.13-1ubuntu3) を展開しています... 以前に未選択のパッケージ m4 を選択しています。 .../001-m4_1.4.18-5ubuntu2_amd64.deb を展開する準備をしています ... m4 (1.4.18-5ubuntu2) を展開しています... 以前に未選択のパッケージ autoconf を選択しています。 .../002-autoconf_2.71-2_all.deb を展開する準備をしています ... autoconf (2.71-2) を展開しています... 以前に未選択のパッケージ autotools-dev を選択しています。 .../003-autotools-dev_20220109.1_all.deb を展開する準備をしています ... autotools-dev (20220109.1) を展開しています... 以前に未選択のパッケージ automake を選択しています。 .../004-automake_1%3a1.16.5-1.3_all.deb を展開する準備をしています ... automake (1:1.16.5-1.3) を展開しています... 以前に未選択のパッケージ autopoint を選択しています。 .../005-autopoint_0.21-4ubuntu4_all.deb を展開する準備をしています ... autopoint (0.21-4ubuntu4) を展開しています... 以前に未選択のパッケージ libc-dev-bin を選択しています。 .../006-libc-dev-bin_2.35-0ubuntu3.5_amd64.deb を展開する準備をしています ... libc-dev-bin (2.35-0ubuntu3.5) を展開しています... 以前に未選択のパッケージ linux-libc-dev:amd64 を選択しています。 .../007-linux-libc-dev_5.15.0-91.101_amd64.deb を展開する準備をしています ... linux-libc-dev:amd64 (5.15.0-91.101) を展開しています... 以前に未選択のパッケージ libcrypt-dev:amd64 を選択しています。 .../008-libcrypt-dev_1%3a4.4.27-1_amd64.deb を展開する準備をしています ... libcrypt-dev:amd64 (1:4.4.27-1) を展開しています... 以前に未選択のパッケージ rpcsvc-proto を選択しています。 .../009-rpcsvc-proto_1.4.2-0ubuntu6_amd64.deb を展開する準備をしています ... rpcsvc-proto (1.4.2-0ubuntu6) を展開しています... 以前に未選択のパッケージ libtirpc-dev:amd64 を選択しています。 .../010-libtirpc-dev_1.3.2-2ubuntu0.1_amd64.deb を展開する準備をしています ... libtirpc-dev:amd64 (1.3.2-2ubuntu0.1) を展開しています... 以前に未選択のパッケージ libnsl-dev:amd64 を選択しています。 .../011-libnsl-dev_1.3.0-2build2_amd64.deb を展開する準備をしています ... libnsl-dev:amd64 (1.3.0-2build2) を展開しています... 以前に未選択のパッケージ libc6-dev:amd64 を選択しています。 .../012-libc6-dev_2.35-0ubuntu3.5_amd64.deb を展開する準備をしています ... libc6-dev:amd64 (2.35-0ubuntu3.5) を展開しています... 以前に未選択のパッケージ libcc1-0:amd64 を選択しています。 .../013-libcc1-0_12.3.0-1ubuntu1~22.04_amd64.deb を展開する準備をしています ... libcc1-0:amd64 (12.3.0-1ubuntu1~22.04) を展開しています... 以前に未選択のパッケージ libitm1:amd64 を選択しています。 .../014-libitm1_12.3.0-1ubuntu1~22.04_amd64.deb を展開する準備をしています ... libitm1:amd64 (12.3.0-1ubuntu1~22.04) を展開しています... 以前に未選択のパッケージ libasan6:amd64 を選択しています。 .../015-libasan6_11.4.0-1ubuntu1~22.04_amd64.deb を展開する準備をしています ... libasan6:amd64 (11.4.0-1ubuntu1~22.04) を展開しています... 以前に未選択のパッケージ liblsan0:amd64 を選択しています。 .../016-liblsan0_12.3.0-1ubuntu1~22.04_amd64.deb を展開する準備をしています ... liblsan0:amd64 (12.3.0-1ubuntu1~22.04) を展開しています... 以前に未選択のパッケージ libtsan0:amd64 を選択しています。 .../017-libtsan0_11.4.0-1ubuntu1~22.04_amd64.deb を展開する準備をしています ... libtsan0:amd64 (11.4.0-1ubuntu1~22.04) を展開しています... 以前に未選択のパッケージ libubsan1:amd64 を選択しています。 .../018-libubsan1_12.3.0-1ubuntu1~22.04_amd64.deb を展開する準備をしています ... libubsan1:amd64 (12.3.0-1ubuntu1~22.04) を展開しています... 以前に未選択のパッケージ libgcc-11-dev:amd64 を選択しています。 .../019-libgcc-11-dev_11.4.0-1ubuntu1~22.04_amd64.deb を展開する準備をしています ... libgcc-11-dev:amd64 (11.4.0-1ubuntu1~22.04) を展開しています... 以前に未選択のパッケージ gcc-11 を選択しています。 .../020-gcc-11_11.4.0-1ubuntu1~22.04_amd64.deb を展開する準備をしています ... gcc-11 (11.4.0-1ubuntu1~22.04) を展開しています... 以前に未選択のパッケージ gcc を選択しています。 .../021-gcc_4%3a11.2.0-1ubuntu1_amd64.deb を展開する準備をしています ... gcc (4:11.2.0-1ubuntu1) を展開しています... 以前に未選択のパッケージ libstdc++-11-dev:amd64 を選択しています。 .../022-libstdc++-11-dev_11.4.0-1ubuntu1~22.04_amd64.deb を展開する準備をしています ... libstdc++-11-dev:amd64 (11.4.0-1ubuntu1~22.04) を展開しています... 以前に未選択のパッケージ g++-11 を選択しています。 .../023-g++-11_11.4.0-1ubuntu1~22.04_amd64.deb を展開する準備をしています ... g++-11 (11.4.0-1ubuntu1~22.04) を展開しています... 以前に未選択のパッケージ g++ を選択しています。 .../024-g++_4%3a11.2.0-1ubuntu1_amd64.deb を展開する準備をしています ... g++ (4:11.2.0-1ubuntu1) を展開しています... 以前に未選択のパッケージ make を選択しています。 .../025-make_4.3-4.1build1_amd64.deb を展開する準備をしています ... make (4.3-4.1build1) を展開しています... 以前に未選択のパッケージ lto-disabled-list を選択しています。 .../026-lto-disabled-list_24_all.deb を展開する準備をしています ... lto-disabled-list (24) を展開しています... 以前に未選択のパッケージ dpkg-dev を選択しています。 .../027-dpkg-dev_1.21.1ubuntu2.2_all.deb を展開する準備をしています ... dpkg-dev (1.21.1ubuntu2.2) を展開しています... 以前に未選択のパッケージ build-essential を選択しています。 .../028-build-essential_12.9ubuntu3_amd64.deb を展開する準備をしています ... build-essential (12.9ubuntu3) を展開しています... 以前に未選択のパッケージ libdebhelper-perl を選択しています。 .../029-libdebhelper-perl_13.6ubuntu1_all.deb を展開する準備をしています ... libdebhelper-perl (13.6ubuntu1) を展開しています... 以前に未選択のパッケージ libtool を選択しています。 .../030-libtool_2.4.6-15build2_all.deb を展開する準備をしています ... libtool (2.4.6-15build2) を展開しています... 以前に未選択のパッケージ dh-autoreconf を選択しています。 .../031-dh-autoreconf_20_all.deb を展開する準備をしています ... dh-autoreconf (20) を展開しています... 以前に未選択のパッケージ libarchive-zip-perl を選択しています。 .../032-libarchive-zip-perl_1.68-1_all.deb を展開する準備をしています ... libarchive-zip-perl (1.68-1) を展開しています... 以前に未選択のパッケージ libsub-override-perl を選択しています。 .../033-libsub-override-perl_0.09-2_all.deb を展開する準備をしています ... libsub-override-perl (0.09-2) を展開しています... 以前に未選択のパッケージ libfile-stripnondeterminism-perl を選択しています。 .../034-libfile-stripnondeterminism-perl_1.13.0-1_all.deb を展開する準備をしています ... libfile-stripnondeterminism-perl (1.13.0-1) を展開しています... 以前に未選択のパッケージ dh-strip-nondeterminism を選択しています。 .../035-dh-strip-nondeterminism_1.13.0-1_all.deb を展開する準備をしています ... dh-strip-nondeterminism (1.13.0-1) を展開しています... 以前に未選択のパッケージ debugedit を選択しています。 .../036-debugedit_1%3a5.0-4build1_amd64.deb を展開する準備をしています ... debugedit (1:5.0-4build1) を展開しています... 以前に未選択のパッケージ dwz を選択しています。 .../037-dwz_0.14-1build2_amd64.deb を展開する準備をしています ... dwz (0.14-1build2) を展開しています... 以前に未選択のパッケージ gettext を選択しています。 .../038-gettext_0.21-4ubuntu4_amd64.deb を展開する準備をしています ... gettext (0.21-4ubuntu4) を展開しています... 以前に未選択のパッケージ intltool-debian を選択しています。 .../039-intltool-debian_0.35.0+20060710.5_all.deb を展開する準備をしています ... intltool-debian (0.35.0+20060710.5) を展開しています... 以前に未選択のパッケージ po-debconf を選択しています。 .../040-po-debconf_1.0.21+nmu1_all.deb を展開する準備をしています ... po-debconf (1.0.21+nmu1) を展開しています... 以前に未選択のパッケージ debhelper を選択しています。 .../041-debhelper_13.6ubuntu1_all.deb を展開する準備をしています ... debhelper (13.6ubuntu1) を展開しています... 以前に未選択のパッケージ libfakeroot:amd64 を選択しています。 .../042-libfakeroot_1.28-1ubuntu1_amd64.deb を展開する準備をしています ... libfakeroot:amd64 (1.28-1ubuntu1) を展開しています... 以前に未選択のパッケージ fakeroot を選択しています。 .../043-fakeroot_1.28-1ubuntu1_amd64.deb を展開する準備をしています ... fakeroot (1.28-1ubuntu1) を展開しています... 以前に未選択のパッケージ gir1.2-gtk-2.0:amd64 を選択しています。 .../044-gir1.2-gtk-2.0_2.24.33-2ubuntu2_amd64.deb を展開する準備をしています ... gir1.2-gtk-2.0:amd64 (2.24.33-2ubuntu2) を展開しています... 以前に未選択のパッケージ icu-devtools を選択しています。 .../045-icu-devtools_70.1-2_amd64.deb を展開する準備をしています ... icu-devtools (70.1-2) を展開しています... 以前に未選択のパッケージ libalgorithm-diff-perl を選択しています。 .../046-libalgorithm-diff-perl_1.201-1_all.deb を展開する準備をしています ... libalgorithm-diff-perl (1.201-1) を展開しています... 以前に未選択のパッケージ libalgorithm-diff-xs-perl を選択しています。 .../047-libalgorithm-diff-xs-perl_0.04-6build3_amd64.deb を展開する準備をしています ... libalgorithm-diff-xs-perl (0.04-6build3) を展開しています... 以前に未選択のパッケージ libalgorithm-merge-perl を選択しています。 .../048-libalgorithm-merge-perl_0.08-3_all.deb を展開する準備をしています ... libalgorithm-merge-perl (0.08-3) を展開しています... 以前に未選択のパッケージ libarchive-cpio-perl を選択しています。 .../049-libarchive-cpio-perl_0.10-1.1_all.deb を展開する準備をしています ... libarchive-cpio-perl (0.10-1.1) を展開しています... 以前に未選択のパッケージ libffi-dev:amd64 を選択しています。 .../050-libffi-dev_3.4.2-4_amd64.deb を展開する準備をしています ... libffi-dev:amd64 (3.4.2-4) を展開しています... 以前に未選択のパッケージ python3-distutils を選択しています。 .../051-python3-distutils_3.10.8-1~22.04_all.deb を展開する準備をしています ... python3-distutils (3.10.8-1~22.04) を展開しています... 以前に未選択のパッケージ libglib2.0-dev-bin を選択しています。 .../052-libglib2.0-dev-bin_2.72.4-0ubuntu2.2_amd64.deb を展開する準備をしています ... libglib2.0-dev-bin (2.72.4-0ubuntu2.2) を展開しています... 以前に未選択のパッケージ uuid-dev:amd64 を選択しています。 .../053-uuid-dev_2.37.2-4ubuntu3_amd64.deb を展開する準備をしています ... uuid-dev:amd64 (2.37.2-4ubuntu3) を展開しています... 以前に未選択のパッケージ libblkid-dev:amd64 を選択しています。 .../054-libblkid-dev_2.37.2-4ubuntu3_amd64.deb を展開する準備をしています ... libblkid-dev:amd64 (2.37.2-4ubuntu3) を展開しています... 以前に未選択のパッケージ libsepol-dev:amd64 を選択しています。 .../055-libsepol-dev_3.3-1build1_amd64.deb を展開する準備をしています ... libsepol-dev:amd64 (3.3-1build1) を展開しています... 以前に未選択のパッケージ libpcre2-posix3:amd64 を選択しています。 .../056-libpcre2-posix3_10.39-3ubuntu0.1_amd64.deb を展開する準備をしています ... libpcre2-posix3:amd64 (10.39-3ubuntu0.1) を展開しています... 以前に未選択のパッケージ libpcre2-dev:amd64 を選択しています。 .../057-libpcre2-dev_10.39-3ubuntu0.1_amd64.deb を展開する準備をしています ... libpcre2-dev:amd64 (10.39-3ubuntu0.1) を展開しています... 以前に未選択のパッケージ libselinux1-dev:amd64 を選択しています。 .../058-libselinux1-dev_3.3-1build2_amd64.deb を展開する準備をしています ... libselinux1-dev:amd64 (3.3-1build2) を展開しています... 以前に未選択のパッケージ libmount-dev:amd64 を選択しています。 .../059-libmount-dev_2.37.2-4ubuntu3_amd64.deb を展開する準備をしています ... libmount-dev:amd64 (2.37.2-4ubuntu3) を展開しています... 以前に未選択のパッケージ libpcre16-3:amd64 を選択しています。 .../060-libpcre16-3_2%3a8.39-13ubuntu0.22.04.1_amd64.deb を展開する準備をしています ... libpcre16-3:amd64 (2:8.39-13ubuntu0.22.04.1) を展開しています... 以前に未選択のパッケージ libpcre32-3:amd64 を選択しています。 .../061-libpcre32-3_2%3a8.39-13ubuntu0.22.04.1_amd64.deb を展開する準備をしています ... libpcre32-3:amd64 (2:8.39-13ubuntu0.22.04.1) を展開しています... 以前に未選択のパッケージ libpcrecpp0v5:amd64 を選択しています。 .../062-libpcrecpp0v5_2%3a8.39-13ubuntu0.22.04.1_amd64.deb を展開する準備をしています ... libpcrecpp0v5:amd64 (2:8.39-13ubuntu0.22.04.1) を展開しています... 以前に未選択のパッケージ libpcre3-dev:amd64 を選択しています。 .../063-libpcre3-dev_2%3a8.39-13ubuntu0.22.04.1_amd64.deb を展開する準備をしています ... libpcre3-dev:amd64 (2:8.39-13ubuntu0.22.04.1) を展開しています... 以前に未選択のパッケージ zlib1g-dev:amd64 を選択しています。 .../064-zlib1g-dev_1%3a1.2.11.dfsg-2ubuntu9.2_amd64.deb を展開する準備をしています ... zlib1g-dev:amd64 (1:1.2.11.dfsg-2ubuntu9.2) を展開しています... 以前に未選択のパッケージ libglib2.0-dev:amd64 を選択しています。 .../065-libglib2.0-dev_2.72.4-0ubuntu2.2_amd64.deb を展開する準備をしています ... libglib2.0-dev:amd64 (2.72.4-0ubuntu2.2) を展開しています... 以前に未選択のパッケージ libatk1.0-dev:amd64 を選択しています。 .../066-libatk1.0-dev_2.36.0-3build1_amd64.deb を展開する準備をしています ... libatk1.0-dev:amd64 (2.36.0-3build1) を展開しています... 以前に未選択のパッケージ libbrotli-dev:amd64 を選択しています。 .../067-libbrotli-dev_1.0.9-2build6_amd64.deb を展開する準備をしています ... libbrotli-dev:amd64 (1.0.9-2build6) を展開しています... 以前に未選択のパッケージ libc-devtools を選択しています。 .../068-libc-devtools_2.35-0ubuntu3.5_amd64.deb を展開する準備をしています ... libc-devtools (2.35-0ubuntu3.5) を展開しています... 以前に未選択のパッケージ libexpat1-dev:amd64 を選択しています。 .../069-libexpat1-dev_2.4.7-1ubuntu0.2_amd64.deb を展開する準備をしています ... libexpat1-dev:amd64 (2.4.7-1ubuntu0.2) を展開しています... 以前に未選択のパッケージ libpng-dev:amd64 を選択しています。 .../070-libpng-dev_1.6.37-3build5_amd64.deb を展開する準備をしています ... libpng-dev:amd64 (1.6.37-3build5) を展開しています... 以前に未選択のパッケージ libfreetype-dev:amd64 を選択しています。 .../071-libfreetype-dev_2.11.1+dfsg-1ubuntu0.2_amd64.deb を展開する準備をしています ... libfreetype-dev:amd64 (2.11.1+dfsg-1ubuntu0.2) を展開しています... 以前に未選択のパッケージ libfreetype6-dev:amd64 を選択しています。 .../072-libfreetype6-dev_2.11.1+dfsg-1ubuntu0.2_amd64.deb を展開する準備をしています ... libfreetype6-dev:amd64 (2.11.1+dfsg-1ubuntu0.2) を展開しています... 以前に未選択のパッケージ libfontconfig-dev:amd64 を選択しています。 .../073-libfontconfig-dev_2.13.1-4.2ubuntu5_amd64.deb を展開する準備をしています ... libfontconfig-dev:amd64 (2.13.1-4.2ubuntu5) を展開しています... 以前に未選択のパッケージ libfontconfig1-dev:amd64 を選択しています。 .../074-libfontconfig1-dev_2.13.1-4.2ubuntu5_amd64.deb を展開する準備をしています ... libfontconfig1-dev:amd64 (2.13.1-4.2ubuntu5) を展開しています... 以前に未選択のパッケージ xorg-sgml-doctools を選択しています。 .../075-xorg-sgml-doctools_1%3a1.11-1.1_all.deb を展開する準備をしています ... xorg-sgml-doctools (1:1.11-1.1) を展開しています... 以前に未選択のパッケージ x11proto-dev を選択しています。 .../076-x11proto-dev_2021.5-1_all.deb を展開する準備をしています ... x11proto-dev (2021.5-1) を展開しています... 以前に未選択のパッケージ libxau-dev:amd64 を選択しています。 .../077-libxau-dev_1%3a1.0.9-1build5_amd64.deb を展開する準備をしています ... libxau-dev:amd64 (1:1.0.9-1build5) を展開しています... 以前に未選択のパッケージ libxdmcp-dev:amd64 を選択しています。 .../078-libxdmcp-dev_1%3a1.1.3-0ubuntu5_amd64.deb を展開する準備をしています ... libxdmcp-dev:amd64 (1:1.1.3-0ubuntu5) を展開しています... 以前に未選択のパッケージ xtrans-dev を選択しています。 .../079-xtrans-dev_1.4.0-1_all.deb を展開する準備をしています ... xtrans-dev (1.4.0-1) を展開しています... 以前に未選択のパッケージ libpthread-stubs0-dev:amd64 を選択しています。 .../080-libpthread-stubs0-dev_0.4-1build2_amd64.deb を展開する準備をしています ... libpthread-stubs0-dev:amd64 (0.4-1build2) を展開しています... 以前に未選択のパッケージ libxcb1-dev:amd64 を選択しています。 .../081-libxcb1-dev_1.14-3ubuntu3_amd64.deb を展開する準備をしています ... libxcb1-dev:amd64 (1.14-3ubuntu3) を展開しています... 以前に未選択のパッケージ libx11-dev:amd64 を選択しています。 .../082-libx11-dev_2%3a1.7.5-1ubuntu0.3_amd64.deb を展開する準備をしています ... libx11-dev:amd64 (2:1.7.5-1ubuntu0.3) を展開しています... 以前に未選択のパッケージ libxrender-dev:amd64 を選択しています。 .../083-libxrender-dev_1%3a0.9.10-1build4_amd64.deb を展開する準備をしています ... libxrender-dev:amd64 (1:0.9.10-1build4) を展開しています... 以前に未選択のパッケージ libxext-dev:amd64 を選択しています。 .../084-libxext-dev_2%3a1.3.4-1build1_amd64.deb を展開する準備をしています ... libxext-dev:amd64 (2:1.3.4-1build1) を展開しています... 以前に未選択のパッケージ libice-dev:amd64 を選択しています。 .../085-libice-dev_2%3a1.0.10-1build2_amd64.deb を展開する準備をしています ... libice-dev:amd64 (2:1.0.10-1build2) を展開しています... 以前に未選択のパッケージ libsm-dev:amd64 を選択しています。 .../086-libsm-dev_2%3a1.2.3-1build2_amd64.deb を展開する準備をしています ... libsm-dev:amd64 (2:1.2.3-1build2) を展開しています... 以前に未選択のパッケージ libpixman-1-dev:amd64 を選択しています。 .../087-libpixman-1-dev_0.40.0-1ubuntu0.22.04.1_amd64.deb を展開する準備をしています ... libpixman-1-dev:amd64 (0.40.0-1ubuntu0.22.04.1) を展開しています... 以前に未選択のパッケージ libxcb-render0-dev:amd64 を選択しています。 .../088-libxcb-render0-dev_1.14-3ubuntu3_amd64.deb を展開する準備をしています ... libxcb-render0-dev:amd64 (1.14-3ubuntu3) を展開しています... 以前に未選択のパッケージ libxcb-shm0-dev:amd64 を選択しています。 .../089-libxcb-shm0-dev_1.14-3ubuntu3_amd64.deb を展開する準備をしています ... libxcb-shm0-dev:amd64 (1.14-3ubuntu3) を展開しています... 以前に未選択のパッケージ libcairo2-dev:amd64 を選択しています。 .../090-libcairo2-dev_1.16.0-5ubuntu2_amd64.deb を展開する準備をしています ... libcairo2-dev:amd64 (1.16.0-5ubuntu2) を展開しています... 以前に未選択のパッケージ libdatrie-dev:amd64 を選択しています。 .../091-libdatrie-dev_0.2.13-2_amd64.deb を展開する準備をしています ... libdatrie-dev:amd64 (0.2.13-2) を展開しています... 以前に未選択のパッケージ libdeflate-dev:amd64 を選択しています。 .../092-libdeflate-dev_1.10-2_amd64.deb を展開する準備をしています ... libdeflate-dev:amd64 (1.10-2) を展開しています... 以前に未選択のパッケージ libfribidi-dev:amd64 を選択しています。 .../093-libfribidi-dev_1.0.8-2ubuntu3.1_amd64.deb を展開する準備をしています ... libfribidi-dev:amd64 (1.0.8-2ubuntu3.1) を展開しています... 以前に未選択のパッケージ libjpeg-turbo8-dev:amd64 を選択しています。 .../094-libjpeg-turbo8-dev_2.1.2-0ubuntu1_amd64.deb を展開する準備をしています ... libjpeg-turbo8-dev:amd64 (2.1.2-0ubuntu1) を展開しています... 以前に未選択のパッケージ libjpeg8-dev:amd64 を選択しています。 .../095-libjpeg8-dev_8c-2ubuntu10_amd64.deb を展開する準備をしています ... libjpeg8-dev:amd64 (8c-2ubuntu10) を展開しています... 以前に未選択のパッケージ libjpeg-dev:amd64 を選択しています。 .../096-libjpeg-dev_8c-2ubuntu10_amd64.deb を展開する準備をしています ... libjpeg-dev:amd64 (8c-2ubuntu10) を展開しています... 以前に未選択のパッケージ libjbig-dev:amd64 を選択しています。 .../097-libjbig-dev_2.1-3.1ubuntu0.22.04.1_amd64.deb を展開する準備をしています ... libjbig-dev:amd64 (2.1-3.1ubuntu0.22.04.1) を展開しています... 以前に未選択のパッケージ liblzma-dev:amd64 を選択しています。 .../098-liblzma-dev_5.2.5-2ubuntu1_amd64.deb を展開する準備をしています ... liblzma-dev:amd64 (5.2.5-2ubuntu1) を展開しています... 以前に未選択のパッケージ libtiffxx5:amd64 を選択しています。 .../099-libtiffxx5_4.3.0-6ubuntu0.7_amd64.deb を展開する準備をしています ... libtiffxx5:amd64 (4.3.0-6ubuntu0.7) を展開しています... 以前に未選択のパッケージ libtiff-dev:amd64 を選択しています。 .../100-libtiff-dev_4.3.0-6ubuntu0.7_amd64.deb を展開する準備をしています ... libtiff-dev:amd64 (4.3.0-6ubuntu0.7) を展開しています... 以前に未選択のパッケージ libgdk-pixbuf-2.0-dev:amd64 を選択しています。 .../101-libgdk-pixbuf-2.0-dev_2.42.8+dfsg-1ubuntu0.2_amd64.deb を展開する準備をしています ... libgdk-pixbuf-2.0-dev:amd64 (2.42.8+dfsg-1ubuntu0.2) を展開しています... 以前に未選択のパッケージ libgraphite2-dev:amd64 を選択しています。 .../102-libgraphite2-dev_1.3.14-1build2_amd64.deb を展開する準備をしています ... libgraphite2-dev:amd64 (1.3.14-1build2) を展開しています... 以前に未選択のパッケージ libharfbuzz-gobject0:amd64 を選択しています。 .../103-libharfbuzz-gobject0_2.7.4-1ubuntu3.1_amd64.deb を展開する準備をしています ... libharfbuzz-gobject0:amd64 (2.7.4-1ubuntu3.1) を展開しています... 以前に未選択のパッケージ libicu-dev:amd64 を選択しています。 .../104-libicu-dev_70.1-2_amd64.deb を展開する準備をしています ... libicu-dev:amd64 (70.1-2) を展開しています... 以前に未選択のパッケージ libharfbuzz-dev:amd64 を選択しています。 .../105-libharfbuzz-dev_2.7.4-1ubuntu3.1_amd64.deb を展開する準備をしています ... libharfbuzz-dev:amd64 (2.7.4-1ubuntu3.1) を展開しています... 以前に未選択のパッケージ libthai-dev:amd64 を選択しています。 .../106-libthai-dev_0.1.29-1build1_amd64.deb を展開する準備をしています ... libthai-dev:amd64 (0.1.29-1build1) を展開しています... 以前に未選択のパッケージ libxft-dev:amd64 を選択しています。 .../107-libxft-dev_2.3.4-1_amd64.deb を展開する準備をしています ... libxft-dev:amd64 (2.3.4-1) を展開しています... 以前に未選択のパッケージ pango1.0-tools を選択しています。 .../108-pango1.0-tools_1.50.6+ds-2ubuntu1_amd64.deb を展開する準備をしています ... pango1.0-tools (1.50.6+ds-2ubuntu1) を展開しています... 以前に未選択のパッケージ libpango1.0-dev:amd64 を選択しています。 .../109-libpango1.0-dev_1.50.6+ds-2ubuntu1_amd64.deb を展開する準備をしています ... libpango1.0-dev:amd64 (1.50.6+ds-2ubuntu1) を展開しています... 以前に未選択のパッケージ libxinerama-dev:amd64 を選択しています。 .../110-libxinerama-dev_2%3a1.1.4-3_amd64.deb を展開する準備をしています ... libxinerama-dev:amd64 (2:1.1.4-3) を展開しています... 以前に未選択のパッケージ libxfixes-dev:amd64 を選択しています。 .../111-libxfixes-dev_1%3a6.0.0-1_amd64.deb を展開する準備をしています ... libxfixes-dev:amd64 (1:6.0.0-1) を展開しています... 以前に未選択のパッケージ libxi-dev:amd64 を選択しています。 .../112-libxi-dev_2%3a1.8-1build1_amd64.deb を展開する準備をしています ... libxi-dev:amd64 (2:1.8-1build1) を展開しています... 以前に未選択のパッケージ libxrandr-dev:amd64 を選択しています。 .../113-libxrandr-dev_2%3a1.5.2-1build1_amd64.deb を展開する準備をしています ... libxrandr-dev:amd64 (2:1.5.2-1build1) を展開しています... 以前に未選択のパッケージ libxcursor-dev:amd64 を選択しています。 .../114-libxcursor-dev_1%3a1.2.0-2build4_amd64.deb を展開する準備をしています ... libxcursor-dev:amd64 (1:1.2.0-2build4) を展開しています... 以前に未選択のパッケージ libxcomposite-dev:amd64 を選択しています。 .../115-libxcomposite-dev_1%3a0.4.5-1build2_amd64.deb を展開する準備をしています ... libxcomposite-dev:amd64 (1:0.4.5-1build2) を展開しています... 以前に未選択のパッケージ libxdamage-dev:amd64 を選択しています。 .../116-libxdamage-dev_1%3a1.1.5-2build2_amd64.deb を展開する準備をしています ... libxdamage-dev:amd64 (1:1.1.5-2build2) を展開しています... 以前に未選択のパッケージ libxml2-utils を選択しています。 .../117-libxml2-utils_2.9.13+dfsg-1ubuntu0.3_amd64.deb を展開する準備をしています ... libxml2-utils (2.9.13+dfsg-1ubuntu0.3) を展開しています... 以前に未選択のパッケージ libgtk2.0-dev:amd64 を選択しています。 .../118-libgtk2.0-dev_2.24.33-2ubuntu2_amd64.deb を展開する準備をしています ... libgtk2.0-dev:amd64 (2.24.33-2ubuntu2) を展開しています... 以前に未選択のパッケージ libltdl-dev:amd64 を選択しています。 .../119-libltdl-dev_2.4.6-15build2_amd64.deb を展開する準備をしています ... libltdl-dev:amd64 (2.4.6-15build2) を展開しています... 以前に未選択のパッケージ libsys-hostname-long-perl を選択しています。 .../120-libsys-hostname-long-perl_1.5-2_all.deb を展開する準備をしています ... libsys-hostname-long-perl (1.5-2) を展開しています... 以前に未選択のパッケージ libmail-sendmail-perl を選択しています。 .../121-libmail-sendmail-perl_0.80-1.1_all.deb を展開する準備をしています ... libmail-sendmail-perl (0.80-1.1) を展開しています... 以前に未選択のパッケージ libpng-tools を選択しています。 .../122-libpng-tools_1.6.37-3build5_amd64.deb を展開する準備をしています ... libpng-tools (1.6.37-3build5) を展開しています... 以前に未選択のパッケージ manpages-dev を選択しています。 .../123-manpages-dev_5.10-1ubuntu1_all.deb を展開する準備をしています ... manpages-dev (5.10-1ubuntu1) を展開しています... python3-distutils (3.10.8-1~22.04) を設定しています ... libpcrecpp0v5:amd64 (2:8.39-13ubuntu0.22.04.1) を設定しています ... libglib2.0-dev-bin (2.72.4-0ubuntu2.2) を設定しています ... manpages-dev (5.10-1ubuntu1) を設定しています ... lto-disabled-list (24) を設定しています ... gettext (0.21-4ubuntu4) を設定しています ... libpixman-1-dev:amd64 (0.40.0-1ubuntu0.22.04.1) を設定しています ... libpcre16-3:amd64 (2:8.39-13ubuntu0.22.04.1) を設定しています ... libpng-tools (1.6.37-3build5) を設定しています ... libalgorithm-diff-perl (1.201-1) を設定しています ... libarchive-zip-perl (1.68-1) を設定しています ... libfribidi-dev:amd64 (1.0.8-2ubuntu3.1) を設定しています ... libdebhelper-perl (13.6ubuntu1) を設定しています ... pango1.0-tools (1.50.6+ds-2ubuntu1) を設定しています ... libjbig-dev:amd64 (2.1-3.1ubuntu0.22.04.1) を設定しています ... linux-libc-dev:amd64 (5.15.0-91.101) を設定しています ... libharfbuzz-gobject0:amd64 (2.7.4-1ubuntu3.1) を設定しています ... libffi-dev:amd64 (3.4.2-4) を設定しています ... libpthread-stubs0-dev:amd64 (0.4-1build2) を設定しています ... libfakeroot:amd64 (1.28-1ubuntu1) を設定しています ... libasan6:amd64 (11.4.0-1ubuntu1~22.04) を設定しています ... intltool-debian (0.35.0+20060710.5) を設定しています ... fakeroot (1.28-1ubuntu1) を設定しています ... update-alternatives: /usr/bin/fakeroot (fakeroot) を提供するために自動モードで /usr/bin/fakeroot-sysv を使います xtrans-dev (1.4.0-1) を設定しています ... libgraphite2-dev:amd64 (1.3.14-1build2) を設定しています ... autotools-dev (20220109.1) を設定しています ... libtirpc-dev:amd64 (1.3.2-2ubuntu0.1) を設定しています ... rpcsvc-proto (1.4.2-0ubuntu6) を設定しています ... make (4.3-4.1build1) を設定しています ... gir1.2-gtk-2.0:amd64 (2.24.33-2ubuntu2) を設定しています ... libsigsegv2:amd64 (2.13-1ubuntu3) を設定しています ... libpcre32-3:amd64 (2:8.39-13ubuntu0.22.04.1) を設定しています ... autopoint (0.21-4ubuntu4) を設定しています ... icu-devtools (70.1-2) を設定しています ... libsepol-dev:amd64 (3.3-1build1) を設定しています ... liblzma-dev:amd64 (5.2.5-2ubuntu1) を設定しています ... libubsan1:amd64 (12.3.0-1ubuntu1~22.04) を設定しています ... libpcre2-posix3:amd64 (10.39-3ubuntu0.1) を設定しています ... dwz (0.14-1build2) を設定しています ... libdatrie-dev:amd64 (0.2.13-2) を設定しています ... libnsl-dev:amd64 (1.3.0-2build2) を設定しています ... libcrypt-dev:amd64 (1:4.4.27-1) を設定しています ... libarchive-cpio-perl (0.10-1.1) を設定しています ... debugedit (1:5.0-4build1) を設定しています ... libsub-override-perl (0.09-2) を設定しています ... xorg-sgml-doctools (1:1.11-1.1) を設定しています ... libxml2-utils (2.9.13+dfsg-1ubuntu0.3) を設定しています ... libc-dev-bin (2.35-0ubuntu3.5) を設定しています ... libdeflate-dev:amd64 (1.10-2) を設定しています ... libsys-hostname-long-perl (1.5-2) を設定しています ... libalgorithm-diff-xs-perl (0.04-6build3) を設定しています ... libcc1-0:amd64 (12.3.0-1ubuntu1~22.04) を設定しています ... libbrotli-dev:amd64 (1.0.9-2build6) を設定しています ... liblsan0:amd64 (12.3.0-1ubuntu1~22.04) を設定しています ... libitm1:amd64 (12.3.0-1ubuntu1~22.04) を設定しています ... libtiffxx5:amd64 (4.3.0-6ubuntu0.7) を設定しています ... libc-devtools (2.35-0ubuntu3.5) を設定しています ... libalgorithm-merge-perl (0.08-3) を設定しています ... libtsan0:amd64 (11.4.0-1ubuntu1~22.04) を設定しています ... libfile-stripnondeterminism-perl (1.13.0-1) を設定しています ... po-debconf (1.0.21+nmu1) を設定しています ... m4 (1.4.18-5ubuntu2) を設定しています ... dpkg-dev (1.21.1ubuntu2.2) を設定しています ... libmail-sendmail-perl (0.80-1.1) を設定しています ... autoconf (2.71-2) を設定しています ... libthai-dev:amd64 (0.1.29-1build1) を設定しています ... dh-strip-nondeterminism (1.13.0-1) を設定しています ... libgcc-11-dev:amd64 (11.4.0-1ubuntu1~22.04) を設定しています ... gcc-11 (11.4.0-1ubuntu1~22.04) を設定しています ... libc6-dev:amd64 (2.35-0ubuntu3.5) を設定しています ... libicu-dev:amd64 (70.1-2) を設定しています ... automake (1:1.16.5-1.3) を設定しています ... update-alternatives: /usr/bin/automake (automake) を提供するために自動モードで /usr/bin/automake-1.16 を使います libjpeg-turbo8-dev:amd64 (2.1.2-0ubuntu1) を設定しています ... libpcre2-dev:amd64 (10.39-3ubuntu0.1) を設定しています ... libtool (2.4.6-15build2) を設定しています ... libselinux1-dev:amd64 (3.3-1build2) を設定しています ... libpcre3-dev:amd64 (2:8.39-13ubuntu0.22.04.1) を設定しています ... gcc (4:11.2.0-1ubuntu1) を設定しています ... dh-autoreconf (20) を設定しています ... libltdl-dev:amd64 (2.4.6-15build2) を設定しています ... libexpat1-dev:amd64 (2.4.7-1ubuntu0.2) を設定しています ... uuid-dev:amd64 (2.37.2-4ubuntu3) を設定しています ... libstdc++-11-dev:amd64 (11.4.0-1ubuntu1~22.04) を設定しています ... zlib1g-dev:amd64 (1:1.2.11.dfsg-2ubuntu9.2) を設定しています ... libjpeg8-dev:amd64 (8c-2ubuntu10) を設定しています ... libblkid-dev:amd64 (2.37.2-4ubuntu3) を設定しています ... g++-11 (11.4.0-1ubuntu1~22.04) を設定しています ... libpng-dev:amd64 (1.6.37-3build5) を設定しています ... libjpeg-dev:amd64 (8c-2ubuntu10) を設定しています ... debhelper (13.6ubuntu1) を設定しています ... libfreetype-dev:amd64 (2.11.1+dfsg-1ubuntu0.2) を設定しています ... libtiff-dev:amd64 (4.3.0-6ubuntu0.7) を設定しています ... g++ (4:11.2.0-1ubuntu1) を設定しています ... update-alternatives: /usr/bin/c++ (c++) を提供するために自動モードで /usr/bin/g++ を使います build-essential (12.9ubuntu3) を設定しています ... libmount-dev:amd64 (2.37.2-4ubuntu3) を設定しています ... libfontconfig-dev:amd64 (2.13.1-4.2ubuntu5) を設定しています ... libfreetype6-dev:amd64 (2.11.1+dfsg-1ubuntu0.2) を設定しています ... libglib2.0-dev:amd64 (2.72.4-0ubuntu2.2) を設定しています ... libfontconfig1-dev:amd64 (2.13.1-4.2ubuntu5) を設定しています ... install-info (6.8-4build1) のトリガを処理しています ... libglib2.0-0:amd64 (2.72.4-0ubuntu2.2) のトリガを処理しています ... libc-bin (2.35-0ubuntu3.5) のトリガを処理しています ... man-db (2.10.2-1) のトリガを処理しています ... sgml-base (1.30) のトリガを処理しています ... libatk1.0-dev:amd64 (2.36.0-3build1) を設定しています ... x11proto-dev (2021.5-1) を設定しています ... libgdk-pixbuf-2.0-dev:amd64 (2.42.8+dfsg-1ubuntu0.2) を設定しています ... libharfbuzz-dev:amd64 (2.7.4-1ubuntu3.1) を設定しています ... libxau-dev:amd64 (1:1.0.9-1build5) を設定しています ... libice-dev:amd64 (2:1.0.10-1build2) を設定しています ... libsm-dev:amd64 (2:1.2.3-1build2) を設定しています ... libxdmcp-dev:amd64 (1:1.1.3-0ubuntu5) を設定しています ... libxcb1-dev:amd64 (1.14-3ubuntu3) を設定しています ... libx11-dev:amd64 (2:1.7.5-1ubuntu0.3) を設定しています ... libxfixes-dev:amd64 (1:6.0.0-1) を設定しています ... libxcb-shm0-dev:amd64 (1.14-3ubuntu3) を設定しています ... libxcb-render0-dev:amd64 (1.14-3ubuntu3) を設定しています ... libxext-dev:amd64 (2:1.3.4-1build1) を設定しています ... libxi-dev:amd64 (2:1.8-1build1) を設定しています ... libxrender-dev:amd64 (1:0.9.10-1build4) を設定しています ... libxft-dev:amd64 (2.3.4-1) を設定しています ... libxdamage-dev:amd64 (1:1.1.5-2build2) を設定しています ... libxcomposite-dev:amd64 (1:0.4.5-1build2) を設定しています ... libxcursor-dev:amd64 (1:1.2.0-2build4) を設定しています ... libxrandr-dev:amd64 (2:1.5.2-1build1) を設定しています ... libxinerama-dev:amd64 (2:1.1.4-3) を設定しています ... libcairo2-dev:amd64 (1.16.0-5ubuntu2) を設定しています ... libpango1.0-dev:amd64 (1.50.6+ds-2ubuntu1) を設定しています ... libgtk2.0-dev:amd64 (2.24.33-2ubuntu2) を設定しています ...

(py37) $ sudo apt install pkg-config

(py37) $ sudo apt install pkg-config パッケージリストを読み込んでいます... 完了 依存関係ツリーを作成しています... 完了 状態情報を読み取っています... 完了 pkg-config はすでに最新バージョン (0.29.2-1ubuntu3) です。 pkg-config は手動でインストールしたと設定されました。 アップグレード: 0 個、新規インストール: 0 個、削除: 0 個、保留: 5 個。

(py37) $ conda install --channel loopbio --channel conda-forge --channel pkgw-forge gtk2 ffmpeg gtk2-feature opencv

(py37) $ conda install --channel loopbio --channel conda-forge --channel pkgw-forge gtk2 ffmpeg gtk2-feature opencv

Collecting package metadata (current_repodata.json): done

Solving environment: done

==> WARNING: A newer version of conda exists. <==

current version: 23.7.4

latest version: 23.11.0

Please update conda by running

$ conda update -n base -c defaults conda

Or to minimize the number of packages updated during conda update use

conda install conda=23.11.0

## Package Plan ##

environment location: /home/USER/anaconda3/envs/py37

added / updated specs:

- ffmpeg

- gtk2

- gtk2-feature

- opencv

The following packages will be downloaded:

package | build

---------------------------|-----------------

atk-2.36.0 | h06a4308_0 18 KB

atk-1.0-2.36.0 | ha1a6a79_0 466 KB

blas-1.0 | openblas 46 KB

bzip2-1.0.8 | h7f98852_4 484 KB conda-forge

ca-certificates-2023.11.17 | hbcca054_0 151 KB conda-forge

cairo-1.16.0 | hb05425b_5 1.2 MB

certifi-2023.11.17 | pyhd8ed1ab_0 155 KB conda-forge

cyrus-sasl-2.1.28 | h9c0eb46_1 237 KB

eigen-3.4.0 | h4bd325d_0 1.2 MB conda-forge

ffmpeg-4.2.2 | h20bf706_0 59.6 MB

freetype-2.10.4 | h0708190_1 890 KB conda-forge

fribidi-1.0.10 | h36c2ea0_0 112 KB conda-forge

gdk-pixbuf-2.42.10 | h5eee18b_0 600 KB

giflib-5.2.1 | h36c2ea0_2 77 KB conda-forge

gmp-6.1.2 | hf484d3e_1000 751 KB conda-forge

gnutls-3.6.15 | he1e5248_0 1.0 MB

gobject-introspection-1.72.0| py37hbb6d50b_1 1.4 MB

graphite2-1.3.14 | h295c915_1 97 KB

gtk2-2.24.31 | 2 6.4 MB loopbio

gtk2-feature-1.0 | 1 3 KB loopbio

harfbuzz-4.3.0 | hf52aaf7_1 1.3 MB

hdf5-1.10.6 | h3ffc7dd_1 3.6 MB

icu-58.2 | hf484d3e_1000 22.6 MB conda-forge

jpeg-9e | h166bdaf_1 268 KB conda-forge

krb5-1.20.1 | h568e23c_1 1.3 MB

lame-3.100 | h7f98852_1001 496 KB conda-forge

libblas-3.9.0 |15_linux64_openblas 12 KB conda-forge

libcblas-3.9.0 |15_linux64_openblas 12 KB conda-forge

libcups-2.4.2 | ha637b67_0 4.4 MB

libdeflate-1.17 | h5eee18b_1 64 KB

libedit-3.1.20230828 | h5eee18b_0 179 KB

libevent-2.1.12 | h8f2d780_0 425 KB

libgfortran-ng-13.2.0 | h69a702a_0 23 KB conda-forge

libgfortran5-13.2.0 | ha4646dd_0 1.4 MB conda-forge

libidn2-2.3.4 | h5eee18b_0 146 KB

liblapack-3.9.0 |15_linux64_openblas 12 KB conda-forge

libopenblas-0.3.20 |pthreads_h78a6416_0 10.1 MB conda-forge

libopus-1.3.1 | h7f98852_1 255 KB conda-forge

libpq-12.15 | h37d81fd_1 2.4 MB

libtasn1-4.19.0 | h5eee18b_0 63 KB

libunistring-0.9.10 | h7f98852_0 1.4 MB conda-forge

libvpx-1.7.0 | hfc679d8_0 2.6 MB loopbio

mysql-5.7.24 | he378463_2 60.0 MB

nettle-3.7.3 | hbbd107a_1 809 KB

ninja-1.10.2 | h06a4308_5 8 KB

ninja-base-1.10.2 | hd09550d_5 109 KB

numpy-1.21.6 | py37h976b520_0 6.1 MB conda-forge

opencv-4.6.0 | py37h417a72b_3 32.4 MB

openh264-2.1.1 | h4ff587b_0 711 KB

pango-1.50.7 | h05da053_0 427 KB

pcre-8.45 | h9c3ff4c_0 253 KB conda-forge

pixman-0.40.0 | h7f8727e_1 373 KB

python_abi-3.7 | 2_cp37m 4 KB conda-forge

qt-main-5.15.2 | h5b8104b_9 53.7 MB

qt-webengine-5.15.9 | hbbf29b9_6 49.2 MB

x264-1!157.20191217 | h7b6447c_0 922 KB

------------------------------------------------------------

Total: 332.7 MB

The following NEW packages will be INSTALLED:

atk pkgs/main/linux-64::atk-2.36.0-h06a4308_0

atk-1.0 pkgs/main/linux-64::atk-1.0-2.36.0-ha1a6a79_0

blas pkgs/main/linux-64::blas-1.0-openblas

bzip2 conda-forge/linux-64::bzip2-1.0.8-h7f98852_4

cairo pkgs/main/linux-64::cairo-1.16.0-hb05425b_5

cyrus-sasl pkgs/main/linux-64::cyrus-sasl-2.1.28-h9c0eb46_1

dbus pkgs/main/linux-64::dbus-1.13.18-hb2f20db_0

eigen conda-forge/linux-64::eigen-3.4.0-h4bd325d_0

expat pkgs/main/linux-64::expat-2.5.0-h6a678d5_0

ffmpeg pkgs/main/linux-64::ffmpeg-4.2.2-h20bf706_0

fontconfig pkgs/main/linux-64::fontconfig-2.14.1-h4c34cd2_2

freetype conda-forge/linux-64::freetype-2.10.4-h0708190_1

fribidi conda-forge/linux-64::fribidi-1.0.10-h36c2ea0_0

gdk-pixbuf pkgs/main/linux-64::gdk-pixbuf-2.42.10-h5eee18b_0

giflib conda-forge/linux-64::giflib-5.2.1-h36c2ea0_2

glib pkgs/main/linux-64::glib-2.69.1-he621ea3_2

gmp conda-forge/linux-64::gmp-6.1.2-hf484d3e_1000

gnutls pkgs/main/linux-64::gnutls-3.6.15-he1e5248_0

gobject-introspec~ pkgs/main/linux-64::gobject-introspection-1.72.0-py37hbb6d50b_1

graphite2 pkgs/main/linux-64::graphite2-1.3.14-h295c915_1

gst-plugins-base pkgs/main/linux-64::gst-plugins-base-1.14.1-h6a678d5_1

gstreamer pkgs/main/linux-64::gstreamer-1.14.1-h5eee18b_1

gtk2 loopbio/linux-64::gtk2-2.24.31-2

gtk2-feature loopbio/linux-64::gtk2-feature-1.0-1

harfbuzz pkgs/main/linux-64::harfbuzz-4.3.0-hf52aaf7_1

hdf5 pkgs/main/linux-64::hdf5-1.10.6-h3ffc7dd_1

icu conda-forge/linux-64::icu-58.2-hf484d3e_1000

jpeg conda-forge/linux-64::jpeg-9e-h166bdaf_1

krb5 pkgs/main/linux-64::krb5-1.20.1-h568e23c_1

lame conda-forge/linux-64::lame-3.100-h7f98852_1001

lerc pkgs/main/linux-64::lerc-3.0-h295c915_0

libblas conda-forge/linux-64::libblas-3.9.0-15_linux64_openblas

libcblas conda-forge/linux-64::libcblas-3.9.0-15_linux64_openblas

libclang pkgs/main/linux-64::libclang-14.0.6-default_hc6dbbc7_1

libclang13 pkgs/main/linux-64::libclang13-14.0.6-default_he11475f_1

libcups pkgs/main/linux-64::libcups-2.4.2-ha637b67_0

libdeflate pkgs/main/linux-64::libdeflate-1.17-h5eee18b_1

libedit pkgs/main/linux-64::libedit-3.1.20230828-h5eee18b_0

libevent pkgs/main/linux-64::libevent-2.1.12-h8f2d780_0

libgfortran-ng conda-forge/linux-64::libgfortran-ng-13.2.0-h69a702a_0

libgfortran5 conda-forge/linux-64::libgfortran5-13.2.0-ha4646dd_0

libidn2 pkgs/main/linux-64::libidn2-2.3.4-h5eee18b_0

liblapack conda-forge/linux-64::liblapack-3.9.0-15_linux64_openblas

libllvm14 pkgs/main/linux-64::libllvm14-14.0.6-hdb19cb5_3

libopenblas conda-forge/linux-64::libopenblas-0.3.20-pthreads_h78a6416_0

libopus conda-forge/linux-64::libopus-1.3.1-h7f98852_1

libpng pkgs/main/linux-64::libpng-1.6.39-h5eee18b_0

libpq pkgs/main/linux-64::libpq-12.15-h37d81fd_1

libprotobuf pkgs/main/linux-64::libprotobuf-3.20.3-he621ea3_0

libtasn1 pkgs/main/linux-64::libtasn1-4.19.0-h5eee18b_0

libtiff pkgs/main/linux-64::libtiff-4.5.1-h6a678d5_0

libunistring conda-forge/linux-64::libunistring-0.9.10-h7f98852_0

libuuid pkgs/main/linux-64::libuuid-1.41.5-h5eee18b_0

libvpx loopbio/linux-64::libvpx-1.7.0-hfc679d8_0

libwebp pkgs/main/linux-64::libwebp-1.3.2-h11a3e52_0

libwebp-base pkgs/main/linux-64::libwebp-base-1.3.2-h5eee18b_0

libxcb pkgs/main/linux-64::libxcb-1.15-h7f8727e_0

libxkbcommon pkgs/main/linux-64::libxkbcommon-1.0.1-h5eee18b_1

libxml2 pkgs/main/linux-64::libxml2-2.10.4-hcbfbd50_0

libxslt pkgs/main/linux-64::libxslt-1.1.37-h2085143_0

lz4-c pkgs/main/linux-64::lz4-c-1.9.4-h6a678d5_0

mysql pkgs/main/linux-64::mysql-5.7.24-he378463_2

nettle pkgs/main/linux-64::nettle-3.7.3-hbbd107a_1

ninja pkgs/main/linux-64::ninja-1.10.2-h06a4308_5

ninja-base pkgs/main/linux-64::ninja-base-1.10.2-hd09550d_5

numpy conda-forge/linux-64::numpy-1.21.6-py37h976b520_0

opencv pkgs/main/linux-64::opencv-4.6.0-py37h417a72b_3

openh264 pkgs/main/linux-64::openh264-2.1.1-h4ff587b_0

openjpeg pkgs/main/linux-64::openjpeg-2.4.0-h3ad879b_0

pango pkgs/main/linux-64::pango-1.50.7-h05da053_0

pcre conda-forge/linux-64::pcre-8.45-h9c3ff4c_0

pixman pkgs/main/linux-64::pixman-0.40.0-h7f8727e_1

python_abi conda-forge/linux-64::python_abi-3.7-2_cp37m

qt-main pkgs/main/linux-64::qt-main-5.15.2-h5b8104b_9

qt-webengine pkgs/main/linux-64::qt-webengine-5.15.9-hbbf29b9_6

qtwebkit pkgs/main/linux-64::qtwebkit-5.212-h3fafdc1_5

x264 pkgs/main/linux-64::x264-1!157.20191217-h7b6447c_0

zstd pkgs/main/linux-64::zstd-1.5.5-hc292b87_0

The following packages will be UPDATED:

certifi pkgs/main/linux-64::certifi-2022.12.7~ --> conda-forge/noarch::certifi-2023.11.17-pyhd8ed1ab_0

The following packages will be SUPERSEDED by a higher-priority channel:

ca-certificates pkgs/main::ca-certificates-2023.12.12~ --> conda-forge::ca-certificates-2023.11.17-hbcca054_0

Proceed ([y]/n)?

Downloading and Extracting Packages

Preparing transaction: done

Verifying transaction: done

Executing transaction: done

(py37) $ conda install pandas

(py37) $ conda install pandas

Collecting package metadata (current_repodata.json): done

Solving environment: unsuccessful initial attempt using frozen solve. Retrying with flexible solve.

Solving environment: unsuccessful attempt using repodata from current_repodata.json, retrying with next repodata source.

Collecting package metadata (repodata.json): done

Solving environment: done

==> WARNING: A newer version of conda exists. <==

current version: 23.7.4

latest version: 23.11.0

Please update conda by running

$ conda update -n base -c defaults conda

Or to minimize the number of packages updated during conda update use

conda install conda=23.11.0

## Package Plan ##

environment location: /home/USER/anaconda3/envs/py37

added / updated specs:

- pandas

The following packages will be downloaded:

package | build

---------------------------|-----------------

bottleneck-1.3.5 | py37h7deecbd_0 115 KB

numexpr-2.8.4 | py37hd2a5715_0 133 KB

packaging-22.0 | py37h06a4308_0 68 KB

pandas-1.3.5 | py37h8c16a72_0 9.3 MB

pytz-2022.7 | py37h06a4308_0 207 KB

------------------------------------------------------------

Total: 9.8 MB

The following NEW packages will be INSTALLED:

bottleneck pkgs/main/linux-64::bottleneck-1.3.5-py37h7deecbd_0

numexpr pkgs/main/linux-64::numexpr-2.8.4-py37hd2a5715_0

packaging pkgs/main/linux-64::packaging-22.0-py37h06a4308_0

pandas pkgs/main/linux-64::pandas-1.3.5-py37h8c16a72_0

python-dateutil pkgs/main/noarch::python-dateutil-2.8.2-pyhd3eb1b0_0

pytz pkgs/main/linux-64::pytz-2022.7-py37h06a4308_0

six pkgs/main/noarch::six-1.16.0-pyhd3eb1b0_1

The following packages will be UPDATED:

ca-certificates conda-forge::ca-certificates-2023.11.~ --> pkgs/main::ca-certificates-2023.12.12-h06a4308_0

The following packages will be SUPERSEDED by a higher-priority channel:

certifi conda-forge/noarch::certifi-2023.11.1~ --> pkgs/main/linux-64::certifi-2022.12.7-py37h06a4308_0

Proceed ([y]/n)? y

Downloading and Extracting Packages

Preparing transaction: done

Verifying transaction: done

Executing transaction: done

(py37) $ conda install tqdm

(py37) $ conda install tqdm

Collecting package metadata (current_repodata.json): done

Solving environment: done

==> WARNING: A newer version of conda exists. <==

current version: 23.7.4

latest version: 23.11.0

Please update conda by running

$ conda update -n base -c defaults conda

Or to minimize the number of packages updated during conda update use

conda install conda=23.11.0

## Package Plan ##

environment location: /home/USER/anaconda3/envs/py37

added / updated specs:

- tqdm

The following packages will be downloaded:

package | build

---------------------------|-----------------

tqdm-4.64.1 | py37h06a4308_0 126 KB

------------------------------------------------------------

Total: 126 KB

The following NEW packages will be INSTALLED:

tqdm pkgs/main/linux-64::tqdm-4.64.1-py37h06a4308_0

Proceed ([y]/n)? y

Downloading and Extracting Packages

Preparing transaction: done

Verifying transaction: done

Executing transaction: done

(py37) $ conda install matplotlib

(py37) $ conda install matplotlib

Collecting package metadata (current_repodata.json): done

Solving environment: unsuccessful initial attempt using frozen solve. Retrying with flexible solve.

Solving environment: unsuccessful attempt using repodata from current_repodata.json, retrying with next repodata source.

Collecting package metadata (repodata.json): done

Solving environment: done

==> WARNING: A newer version of conda exists. <==

current version: 23.7.4

latest version: 23.11.0

Please update conda by running

$ conda update -n base -c defaults conda

Or to minimize the number of packages updated during conda update use

conda install conda=23.11.0

## Package Plan ##

environment location: /home/USER/anaconda3/envs/py37

added / updated specs:

- matplotlib

The following packages will be downloaded:

package | build

---------------------------|-----------------

kiwisolver-1.3.2 | py37h295c915_0 80 KB

matplotlib-3.4.3 | py37h06a4308_0 28 KB

matplotlib-base-3.4.3 | py37hbbc1b5f_0 5.6 MB

olefile-0.46 | py37_0 50 KB

pillow-8.3.1 | py37h2c7a002_0 635 KB

ply-3.11 | py37_0 82 KB

pyparsing-3.0.9 | py37h06a4308_0 150 KB

pyqt-5.15.7 | py37h6a678d5_1 5.1 MB

pyqt5-sip-12.11.0 | py37h6a678d5_1 87 KB

sip-6.6.2 | py37h6a678d5_0 425 KB

tornado-6.2 | py37h5eee18b_0 584 KB

------------------------------------------------------------

Total: 12.7 MB

The following NEW packages will be INSTALLED:

brotli pkgs/main/linux-64::brotli-1.0.9-h5eee18b_7

brotli-bin pkgs/main/linux-64::brotli-bin-1.0.9-h5eee18b_7

cycler pkgs/main/noarch::cycler-0.11.0-pyhd3eb1b0_0

fonttools pkgs/main/noarch::fonttools-4.25.0-pyhd3eb1b0_0

kiwisolver pkgs/main/linux-64::kiwisolver-1.3.2-py37h295c915_0

lcms2 pkgs/main/linux-64::lcms2-2.12-h3be6417_0

libbrotlicommon pkgs/main/linux-64::libbrotlicommon-1.0.9-h5eee18b_7

libbrotlidec pkgs/main/linux-64::libbrotlidec-1.0.9-h5eee18b_7

libbrotlienc pkgs/main/linux-64::libbrotlienc-1.0.9-h5eee18b_7

matplotlib pkgs/main/linux-64::matplotlib-3.4.3-py37h06a4308_0

matplotlib-base pkgs/main/linux-64::matplotlib-base-3.4.3-py37hbbc1b5f_0

munkres pkgs/main/noarch::munkres-1.1.4-py_0

olefile pkgs/main/linux-64::olefile-0.46-py37_0

pillow pkgs/main/linux-64::pillow-8.3.1-py37h2c7a002_0

ply pkgs/main/linux-64::ply-3.11-py37_0

pyparsing pkgs/main/linux-64::pyparsing-3.0.9-py37h06a4308_0

pyqt pkgs/main/linux-64::pyqt-5.15.7-py37h6a678d5_1

pyqt5-sip pkgs/main/linux-64::pyqt5-sip-12.11.0-py37h6a678d5_1

sip pkgs/main/linux-64::sip-6.6.2-py37h6a678d5_0

toml pkgs/main/noarch::toml-0.10.2-pyhd3eb1b0_0

tornado pkgs/main/linux-64::tornado-6.2-py37h5eee18b_0

Proceed ([y]/n)? y

Downloading and Extracting Packages

Preparing transaction: done

Verifying transaction: done

Executing transaction: done

(py37) $ conda install PyYAML

(py37) $ conda install PyYAML

Collecting package metadata (current_repodata.json): done

Solving environment: done

==> WARNING: A newer version of conda exists. <==

current version: 23.7.4

latest version: 23.11.0

Please update conda by running

$ conda update -n base -c defaults conda

Or to minimize the number of packages updated during conda update use

conda install conda=23.11.0

## Package Plan ##

environment location: /home/USER/anaconda3/envs/py37

added / updated specs:

- pyyaml

The following packages will be downloaded:

package | build

---------------------------|-----------------

pyyaml-6.0 | py37h5eee18b_1 185 KB

------------------------------------------------------------

Total: 185 KB

The following NEW packages will be INSTALLED:

pyyaml pkgs/main/linux-64::pyyaml-6.0-py37h5eee18b_1

yaml pkgs/main/linux-64::yaml-0.2.5-h7b6447c_0

Proceed ([y]/n)? y

Downloading and Extracting Packages

Preparing transaction: done

Verifying transaction: done

Executing transaction: done

(py37) $ pip install scikit-learn

(py37) $ pip install scikit-learn

Collecting scikit-learn

Downloading scikit_learn-1.0.2-cp37-cp37m-manylinux_2_17_x86_64.manylinux2014_x86_64.whl (24.8 MB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 24.8/24.8 MB 45.7 MB/s eta 0:00:00

Requirement already satisfied: numpy>=1.14.6 in ./anaconda3/envs/py37/lib/python3.7/site-packages (from scikit-learn) (1.21.6)

Collecting scipy>=1.1.0 (from scikit-learn)

Downloading scipy-1.7.3-cp37-cp37m-manylinux_2_12_x86_64.manylinux2010_x86_64.whl (38.1 MB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 38.1/38.1 MB 38.4 MB/s eta 0:00:00

Collecting joblib>=0.11 (from scikit-learn)

Downloading joblib-1.3.2-py3-none-any.whl.metadata (5.4 kB)

Collecting threadpoolctl>=2.0.0 (from scikit-learn)

Downloading threadpoolctl-3.1.0-py3-none-any.whl (14 kB)

Downloading joblib-1.3.2-py3-none-any.whl (302 kB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 302.2/302.2 kB 28.2 MB/s eta 0:00:00

Installing collected packages: threadpoolctl, scipy, joblib, scikit-learn

Successfully installed joblib-1.3.2 scikit-learn-1.0.2 scipy-1.7.3 threadpoolctl-3.1.0

(py37) $ pip install pycocotools

(py37) $ pip install pycocotools Collecting pycocotools Downloading pycocotools-2.0.7-cp37-cp37m-manylinux_2_17_x86_64.manylinux2014_x86_64.whl.metadata (1.1 kB) Requirement already satisfied: matplotlib>=2.1.0 in ./anaconda3/envs/py37/lib/python3.7/site-packages (from pycocotools) (3.4.3) Requirement already satisfied: numpy in ./anaconda3/envs/py37/lib/python3.7/site-packages (from pycocotools) (1.21.6) Requirement already satisfied: cycler>=0.10 in ./anaconda3/envs/py37/lib/python3.7/site-packages (from matplotlib>=2.1.0->pycocotools) (0.11.0) Requirement already satisfied: kiwisolver>=1.0.1 in ./anaconda3/envs/py37/lib/python3.7/site-packages (from matplotlib>=2.1.0->pycocotools) (1.3.2) Requirement already satisfied: pillow>=6.2.0 in ./anaconda3/envs/py37/lib/python3.7/site-packages (from matplotlib>=2.1.0->pycocotools) (8.3.1) Requirement already satisfied: pyparsing>=2.2.1 in ./anaconda3/envs/py37/lib/python3.7/site-packages (from matplotlib>=2.1.0->pycocotools) (3.0.9) Requirement already satisfied: python-dateutil>=2.7 in ./anaconda3/envs/py37/lib/python3.7/site-packages (from matplotlib>=2.1.0->pycocotools) (2.8.2) Requirement already satisfied: six>=1.5 in ./anaconda3/envs/py37/lib/python3.7/site-packages (from python-dateutil>=2.7->matplotlib>=2.1.0->pycocotools) (1.16.0) Downloading pycocotools-2.0.7-cp37-cp37m-manylinux_2_17_x86_64.manylinux2014_x86_64.whl (403 kB) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 403.3/403.3 kB 7.2 MB/s eta 0:00:00 Installing collected packages: pycocotools Successfully installed pycocotools-2.0.7

(py37) $ pip install facenet-pytorch

(py37) $ pip install facenet-pytorch

Collecting facenet-pytorch

Downloading facenet_pytorch-2.5.3-py3-none-any.whl (1.9 MB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 1.9/1.9 MB 19.8 MB/s eta 0:00:00

Requirement already satisfied: numpy in ./anaconda3/envs/py37/lib/python3.7/site-packages (from facenet-pytorch) (1.21.6)

Requirement already satisfied: requests in ./anaconda3/envs/py37/lib/python3.7/site-packages (from facenet-pytorch) (2.28.1)

Requirement already satisfied: torchvision in ./anaconda3/envs/py37/lib/python3.7/site-packages (from facenet-pytorch) (0.14.1+cpu)

Requirement already satisfied: pillow in ./anaconda3/envs/py37/lib/python3.7/site-packages (from facenet-pytorch) (8.3.1)

Requirement already satisfied: charset-normalizer<3,>=2 in ./anaconda3/envs/py37/lib/python3.7/site-packages (from requests->facenet-pytorch) (2.1.1)

Requirement already satisfied: idna<4,>=2.5 in ./anaconda3/envs/py37/lib/python3.7/site-packages (from requests->facenet-pytorch) (3.4)

Requirement already satisfied: urllib3<1.27,>=1.21.1 in ./anaconda3/envs/py37/lib/python3.7/site-packages (from requests->facenet-pytorch) (1.26.13)

Requirement already satisfied: certifi>=2017.4.17 in ./anaconda3/envs/py37/lib/python3.7/site-packages (from requests->facenet-pytorch) (2022.12.7)

Requirement already satisfied: typing-extensions in ./anaconda3/envs/py37/lib/python3.7/site-packages (from torchvision->facenet-pytorch) (4.4.0)

Requirement already satisfied: torch==1.13.1 in ./anaconda3/envs/py37/lib/python3.7/site-packages (from torchvision->facenet-pytorch) (1.13.1+cpu)

Collecting pillow (from facenet-pytorch)

Downloading Pillow-9.5.0-cp37-cp37m-manylinux_2_28_x86_64.whl (3.4 MB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 3.4/3.4 MB 29.5 MB/s eta 0:00:00

Installing collected packages: pillow, facenet-pytorch

Attempting uninstall: pillow

Found existing installation: Pillow 8.3.1

Uninstalling Pillow-8.3.1:

Successfully uninstalled Pillow-8.3.1

Successfully installed facenet-pytorch-2.5.3 pillow-9.3.0

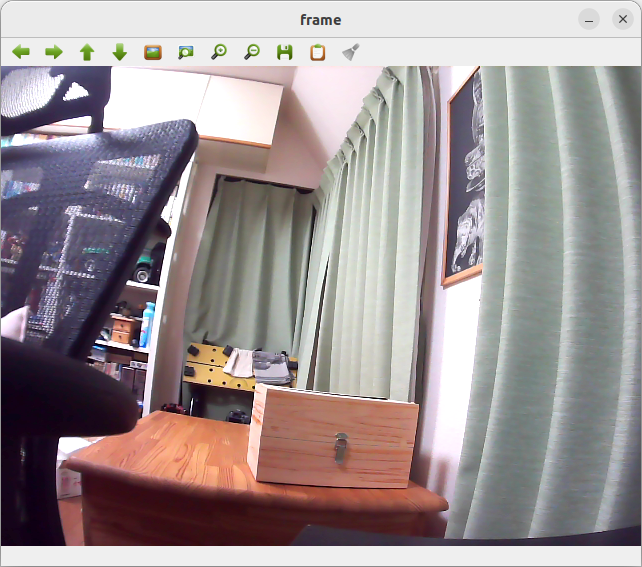

(py37) $ python -c "import torch"

(py37) $ $ python -c 'import torch;print(torch.zeros(1).cuda())'

Traceback (most recent call last):

File "<string>", line 1, in <module>

File "/home/USER/anaconda3/envs/py37/lib/python3.7/site-packages/torch/cuda/__init__.py", line 221, in _lazy_init

raise AssertionError("Torch not compiled with CUDA enabled")

AssertionError: Torch not compiled with CUDA enabled

※ 今回ドライバをインストールしていないのでエラーとなる(py37) $ python -c 'import tkinter'

(py37) $ ffmpeg -h

ffmpeg version 4.2.2 Copyright (c) 2000-2019 the FFmpeg developers

built with gcc 7.3.0 (crosstool-NG 1.23.0.449-a04d0)

configuration: --prefix=/tmp/build/80754af9/ffmpeg_1587154242452/_h_env_placehold_placehold_placehold_placehold_placehold_placehold_placehold_placehold_placehold_placehold_placehold_placehold_placehold_placehold_placehold_placehold_placehold_placehold_placehold_placehold_placeho --cc=/tmp/build/80754af9/ffmpeg_1587154242452/_build_env/bin/x86_64-conda_cos6-linux-gnu-cc --disable-doc --enable-avresample --enable-gmp --enable-hardcoded-tables --enable-libfreetype --enable-libvpx --enable-pthreads --enable-libopus --enable-postproc --enable-pic --enable-pthreads --enable-shared --enable-static --enable-version3 --enable-zlib --enable-libmp3lame --disable-nonfree --enable-gpl --enable-gnutls --disable-openssl --enable-libopenh264 --enable-libx264

libavutil 56. 31.100 / 56. 31.100

libavcodec 58. 54.100 / 58. 54.100

libavformat 58. 29.100 / 58. 29.100

libavdevice 58. 8.100 / 58. 8.100

libavfilter 7. 57.100 / 7. 57.100

libavresample 4. 0. 0 / 4. 0. 0

libswscale 5. 5.100 / 5. 5.100

libswresample 3. 5.100 / 3. 5.100

libpostproc 55. 5.100 / 55. 5.100

Hyper fast Audio and Video encoder

usage: ffmpeg [options] [[infile options] -i infile]... {[outfile options] outfile}...

Getting help:

-h -- print basic options

-h long -- print more options

-h full -- print all options (including all format and codec specific options, very long)

-h type=name -- print all options for the named decoder/encoder/demuxer/muxer/filter/bsf

See man ffmpeg for detailed description of the options.

Print help / information / capabilities:

-L show license

-h topic show help

-? topic show help

-help topic show help

--help topic show help

-version show version

-buildconf show build configuration

-formats show available formats

-muxers show available muxers

-demuxers show available demuxers

-devices show available devices

-codecs show available codecs

-decoders show available decoders

-encoders show available encoders

-bsfs show available bit stream filters

-protocols show available protocols

-filters show available filters

-pix_fmts show available pixel formats

-layouts show standard channel layouts

-sample_fmts show available audio sample formats

-colors show available color names

-sources device list sources of the input device

-sinks device list sinks of the output device

-hwaccels show available HW acceleration methods

Global options (affect whole program instead of just one file:

-loglevel loglevel set logging level

-v loglevel set logging level

-report generate a report

-max_alloc bytes set maximum size of a single allocated block

-y overwrite output files

-n never overwrite output files

-ignore_unknown Ignore unknown stream types

-filter_threads number of non-complex filter threads

-filter_complex_threads number of threads for -filter_complex

-stats print progress report during encoding

-max_error_rate maximum error rate ratio of errors (0.0: no errors, 1.0: 100% errors) above which ffmpeg returns an error instead of success.

-bits_per_raw_sample number set the number of bits per raw sample

-vol volume change audio volume (256=normal)

Per-file main options:

-f fmt force format

-c codec codec name

-codec codec codec name

-pre preset preset name

-map_metadata outfile[,metadata]:infile[,metadata] set metadata information of outfile from infile

-t duration record or transcode "duration" seconds of audio/video

-to time_stop record or transcode stop time

-fs limit_size set the limit file size in bytes

-ss time_off set the start time offset

-sseof time_off set the start time offset relative to EOF

-seek_timestamp enable/disable seeking by timestamp with -ss

-timestamp time set the recording timestamp ('now' to set the current time)

-metadata string=string add metadata

-program title=string:st=number... add program with specified streams

-target type specify target file type ("vcd", "svcd", "dvd", "dv" or "dv50" with optional prefixes "pal-", "ntsc-" or "film-")

-apad audio pad

-frames number set the number of frames to output

-filter filter_graph set stream filtergraph

-filter_script filename read stream filtergraph description from a file

-reinit_filter reinit filtergraph on input parameter changes

-discard discard

-disposition disposition

Video options:

-vframes number set the number of video frames to output

-r rate set frame rate (Hz value, fraction or abbreviation)

-s size set frame size (WxH or abbreviation)

-aspect aspect set aspect ratio (4:3, 16:9 or 1.3333, 1.7777)

-bits_per_raw_sample number set the number of bits per raw sample

-vn disable video

-vcodec codec force video codec ('copy' to copy stream)